AI가 진짜 유용하려면 어떻게 되어야 할까요? 실시간 번역을 해주고, 주변 상황을 파악해서 알아서 도와주고, 하루 종일 배터리 걱정 없이 작동해야 합니다. 그런데 지금 AI는 대부분 클라우드에 있죠. 구글이 이 문제를 정면으로 해결하려는 플랫폼을 내놓았습니다.

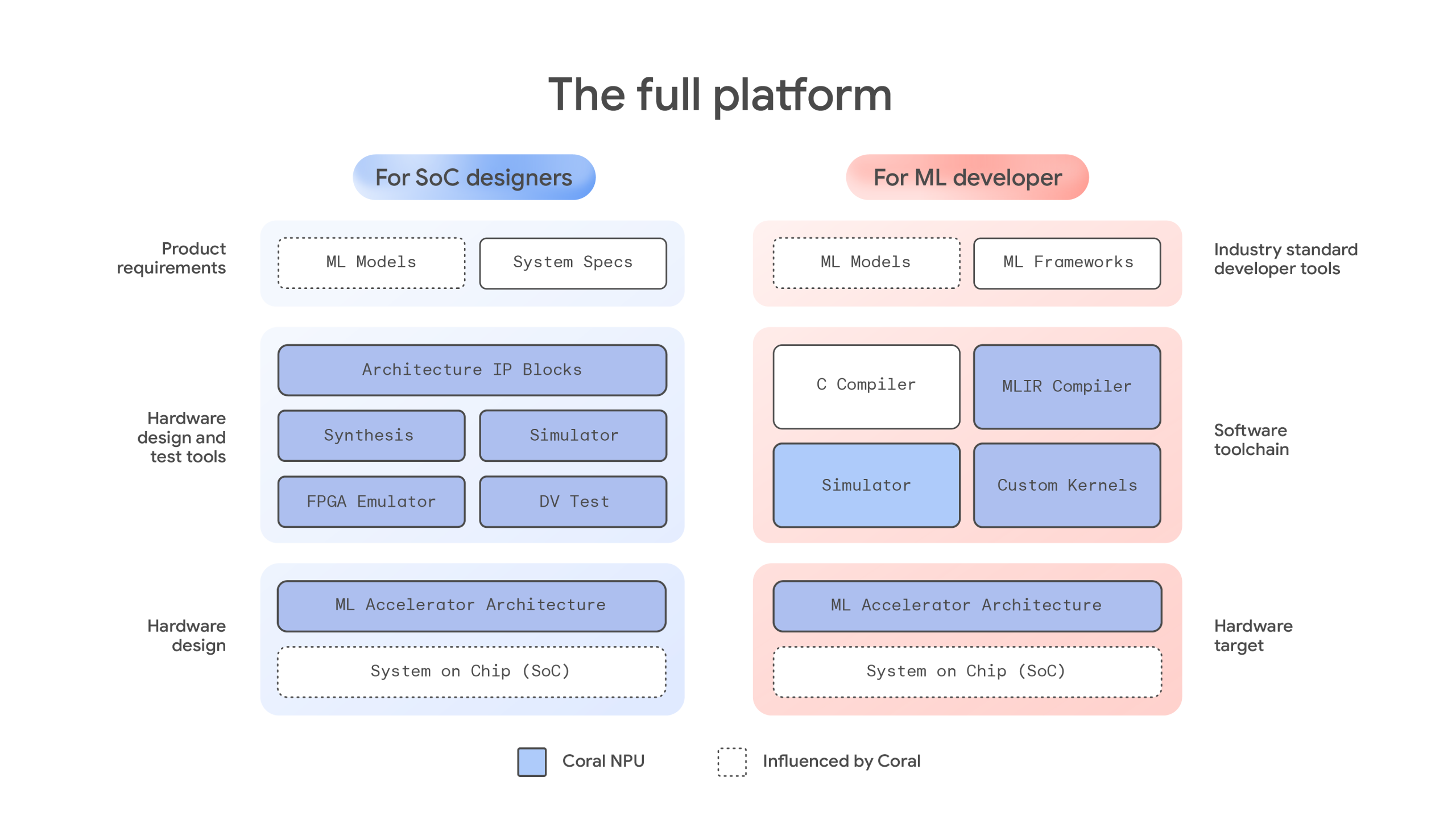

구글이 엣지 AI를 위한 완전한 오픈소스 플랫폼 Coral NPU를 공개했습니다. 웨어러블과 IoT 기기에서 초저전력으로 AI를 구동하기 위한 하드웨어 아키텍처로, RISC-V 기반이라 누구나 자신의 칩에 통합할 수 있죠. 핵심은 ‘수 밀리와트로 512 GOPS’라는 성능입니다. 스마트워치에서 하루 종일 AI가 작동할 수 있는 수준이에요.

출처: Introducing Coral NPU: A full-stack platform for Edge AI – Google Developers Blog

AI 우선 설계: 칩 구조를 뒤집다

전통적인 칩은 범용 CPU가 중심이고 AI 가속기는 보조 역할이었습니다. Coral NPU는 이를 완전히 뒤집었어요. ML 행렬 엔진을 최우선에 두고, 그 주변에 RISC-V 스칼라 코어와 벡터 실행 유닛을 배치했죠. 마치 자동차를 만들 때 엔진부터 설계하고 나머지를 붙이는 것과 비슷합니다.

이 접근 방식 덕분에 Coral NPU는 극도로 효율적입니다. 몇 밀리와트의 전력으로 초당 512기가 연산(GOPS)을 처리하죠. 스마트워치나 무선 이어폰처럼 배터리가 작은 기기에서도 하루 종일 AI를 켜둘 수 있는 이유입니다. 음성 인식, 제스처 감지, 실시간 번역 같은 ‘항상 켜져 있는 AI’ 경험이 가능해집니다.

파편화 해결: 하나의 도구로 모든 프레임워크 지원

엣지 AI 개발자들이 겪는 큰 문제 중 하나가 플랫폼마다 다른 컴파일러와 도구를 써야 한다는 겁니다. Coral NPU는 IREE와 MLIR 같은 업계 표준 컴파일러를 지원해서 TensorFlow, PyTorch, JAX 같은 주요 ML 프레임워크를 모두 하나의 툴체인으로 처리할 수 있게 했어요. 개발자 입장에서는 한 번 배우면 여러 하드웨어에 적용할 수 있다는 뜻입니다.

더 흥미로운 건 Gemma 팀과의 협업입니다. Coral NPU는 소형 트랜스포머 모델을 최적화하고 있어요. 즉, 웨어러블 기기에서 LLM을 돌리는 게 목표죠. 구글은 Coral NPU를 “저전력 NPU로 웨어러블에 LLM을 가져오도록 설계된 업계 최초의 오픈 표준 기반 칩”이라고 소개합니다.

이미 제품으로: Synaptics의 첫 구현

Coral NPU는 개념만 공개한 게 아닙니다. 반도체 기업 Synaptics가 이미 Coral 아키텍처를 구현한 칩을 발표했어요. Astra SL2610 라인의 Torq NPU가 바로 그것인데, 2026년 2분기 출시 예정입니다. 이 칩은 트랜스포머 모델을 지원하고 동적 연산자를 처리할 수 있어서, 앞으로 나올 생성형 AI 애플리케이션에도 대응할 수 있죠.

구글이 Coral NPU를 오픈소스로 공개한 건 단순히 코드를 나누는 것 이상의 의미가 있습니다. 엣지 AI 하드웨어의 파편화 문제를 해결하고, 통일된 표준을 만들겠다는 전략이에요. 스마트폰부터 스마트워치, AR 글래스, 무선 이어폰까지 다양한 기기에서 작동하는 일관된 AI 경험을 만들 수 있는 기반이 생긴 셈입니다.

보안 측면에서도 흥미로운 접근을 하고 있어요. CHERI 같은 하드웨어 수준 메모리 보호 기술을 지원하도록 설계해서, AI 모델과 개인 데이터를 하드웨어로 격리할 수 있습니다. 클라우드에 의존하지 않고 기기 안에서 모든 처리를 끝내면서도 프라이버시를 보장하는 구조죠.

참고자료:

답글 남기기