AI가 만든 짧은 영상 클립은 이제 꽤 그럴듯합니다. 하지만 여러 장면을 이어붙여 하나의 스토리를 만들려고 하면 문제가 생기죠. 첫 장면에서 금발이던 주인공이 다음 장면에선 갑자기 흑발로 바뀌고, 배경도 달라지고, 심지어 옷까지 바뀌어버립니다. AI가 이전 장면을 “기억”하지 못하기 때문입니다.

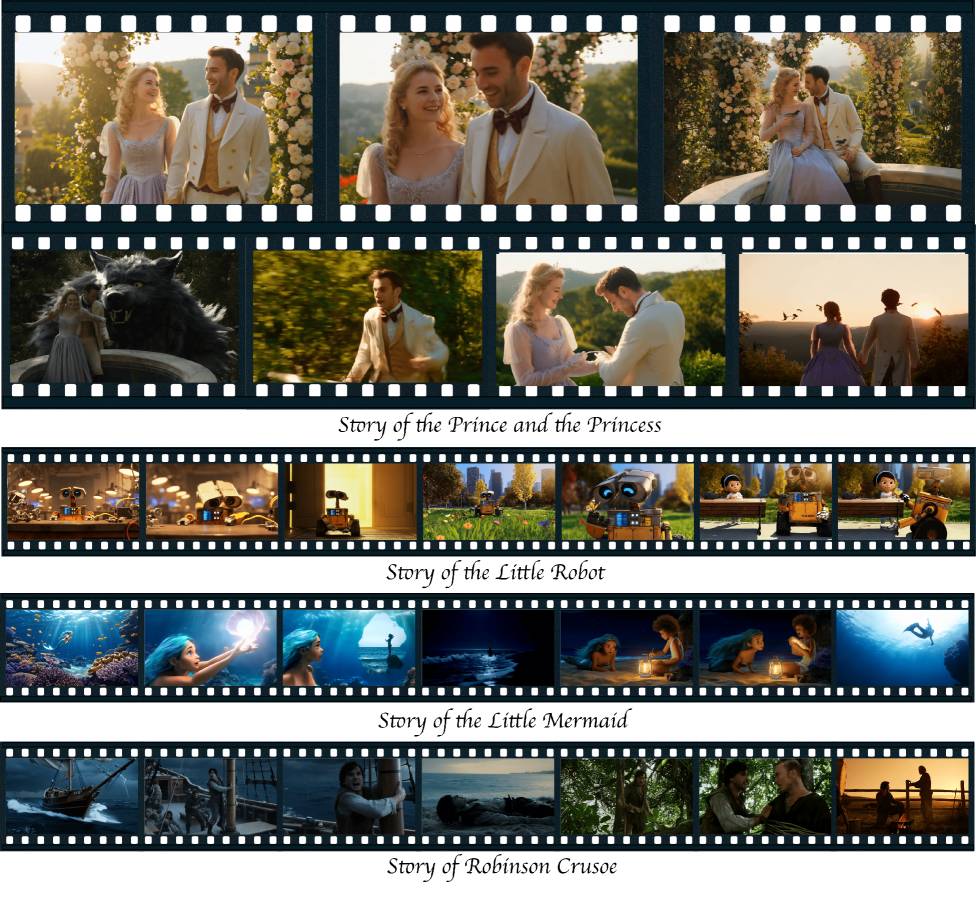

ByteDance와 난양공대 연구팀이 개발한 StoryMem은 AI 비디오 모델에 메모리 기능을 추가해 여러 장면에걸쳐 캐릭터와 배경을 일관되게 유지하는 시스템입니다. 이전 장면의 핵심 프레임을 저장해두고 새 장면을 만들 때 참조하는 방식이죠. 기존 최고 기술 대비 9.4%, 베이스 모델 대비 28.7%나 일관성이 향상됐습니다.

출처: StoryMem 공식 프로젝트 페이지 – ByteDance Research

AI 비디오 생성의 딜레마

Sora, Kling, Veo 같은 AI 비디오 모델들은 몇 초짜리 개별 클립은 인상적으로 만들어냅니다. 하지만 여러 장면을 연결해 완전한 스토리를 만들려고 하면 근본적인 문제에 부딪히죠.

연구팀에 따르면 기존 방식은 두 가지 선택지 중 하나를 택해야 했습니다. 모든 장면을 한 번에 처리하면 컴퓨팅 비용이 폭증하고, 각 장면을 따로 만들어서 합치면 장면 간 일관성이 사라집니다. 어느 쪽도 실용적이지 않았어요.

메모리 뱅크: AI에게 기억을 심다

StoryMem은 제3의 접근법을 택했습니다. 마치 사람이 이전 장면을 기억하듯, AI가 생성 과정에서 선택된 핵심 프레임을 메모리 뱅크에 저장하고 새 장면을 만들 때 참조하는 거죠.

작동 방식은 이렇습니다. 모든 프레임을 저장하는 대신, 알고리즘이 시각적으로 중요한 이미지만 골라냅니다. 내용을 분석해서 의미적으로 구별되는 프레임을 찾고, 두 번째 필터가 흐릿하거나 노이즈가 많은 이미지는 걸러내죠.

메모리 뱅크는 하이브리드 시스템을 사용합니다. 초반 핵심 이미지는 장기 참조로 유지하고, 최근 이미지들은 슬라이딩 윈도우 방식으로 순환시킵니다. 스토리 초반의 중요한 시각 정보를 잃지 않으면서도 메모리 크기를 관리 가능하게 유지하는 거예요.

새 장면을 생성할 때는 저장된 이미지들이 현재 만들어지는 비디오와 함께 모델에 입력됩니다. RoPE(Rotary Position Embedding)라는 특별한 위치 인코딩을 사용해서 모델이 메모리 프레임을 이전 사건으로 해석하도록 만들죠. 연구팀은 저장된 이미지에 음수 시간 인덱스를 부여해 모델이 이를 과거 사건으로 취급하게 했습니다.

효율적인 학습, 인상적인 결과

이 접근법의 실용적 장점은 학습 노력이 적다는 점입니다. 경쟁 방식들은 긴 연속 비디오 시퀀스로 학습해야 하는데, 고품질 데이터를 구하기 어렵죠. StoryMem은 Alibaba의 오픈소스 모델 Wan2.2-I2V에 LoRA 방식으로 적용됩니다.

연구팀은 각 5초짜리 짧은 클립 40만 개로 학습시켰습니다. 시각적 유사성으로 클립들을 그룹화해서 모델이 관련 이미지에서 일관된 후속 장면을 생성하도록 학습시켰죠. 이 확장은 14B 파라미터 모델에 약 0.7B 파라미터만 추가합니다.

연구팀이 자체 제작한 ST-Bench 벤치마크로 평가한 결과, StoryMem은 장면 간 일관성에서 큰 개선을 보였습니다. 수정하지 않은 베이스 모델보다 28.7% 향상됐고, 연구팀이 이전 최고 기술로 꼽은 HoloCine보다도 9.4% 나았습니다. 일관성에 최적화된 모든 방법 중 가장 높은 미학 점수도 기록했어요.

사용자 연구 결과도 정량적 수치를 뒷받침했습니다. 참가자들은 대부분의 평가 카테고리에서 StoryMem의 결과물을 선호했죠.

새로운 가능성, 남아있는 과제

이 프레임워크는 두 가지 추가 활용 사례를 지원합니다. 사용자가 자신의 참조 이미지를 메모리 뱅크의 시작점으로 제공할 수 있어요. 예를 들어 사람이나 장소 사진을 넣으면 시스템이 그 요소들이 계속 등장하는 스토리를 생성합니다. 또한 더 부드러운 장면 전환도 가능합니다. 한 장면의 마지막 프레임을 다음 장면의 첫 프레임으로 사용할 수 있거든요.

물론 한계도 있습니다. 연구팀은 많은 캐릭터가 등장하는 복잡한 장면에서 어려움을 겪는다고 밝혔습니다. 메모리 뱅크가 이미지를 저장할 때 특정 캐릭터에 할당하지 않기 때문에, 새 캐릭터가 나타나면 모델이 가끔 시각적 속성을 잘못 적용하기도 하죠.

연구팀은 해결책으로 각 프롬프트에서 캐릭터를 명시적으로 설명하라고 권장합니다. 움직임 속도가 매우 다른 장면 간 전환도 부자연스러워 보일 수 있습니다. 프레임 연결이 속도 정보를 담지 않기 때문이에요.

그럼에도 StoryMem은 AI 비디오 생성에서 중요한 진전입니다. 단편적인 클립이 아니라 일관된 스토리를 가진 분 단위 영상을 만들 수 있는 가능성을 보여줬으니까요. 프로젝트 페이지에서 다양한 예시 영상을 볼 수 있고, 모델 가중치는 Hugging Face에 공개됐습니다.

참고자료:

- ByteDance’s StoryMem gives AI video models a memory – The Decoder

- StoryMem Hugging Face 모델 – Hugging Face

답글 남기기