AI비용최적화

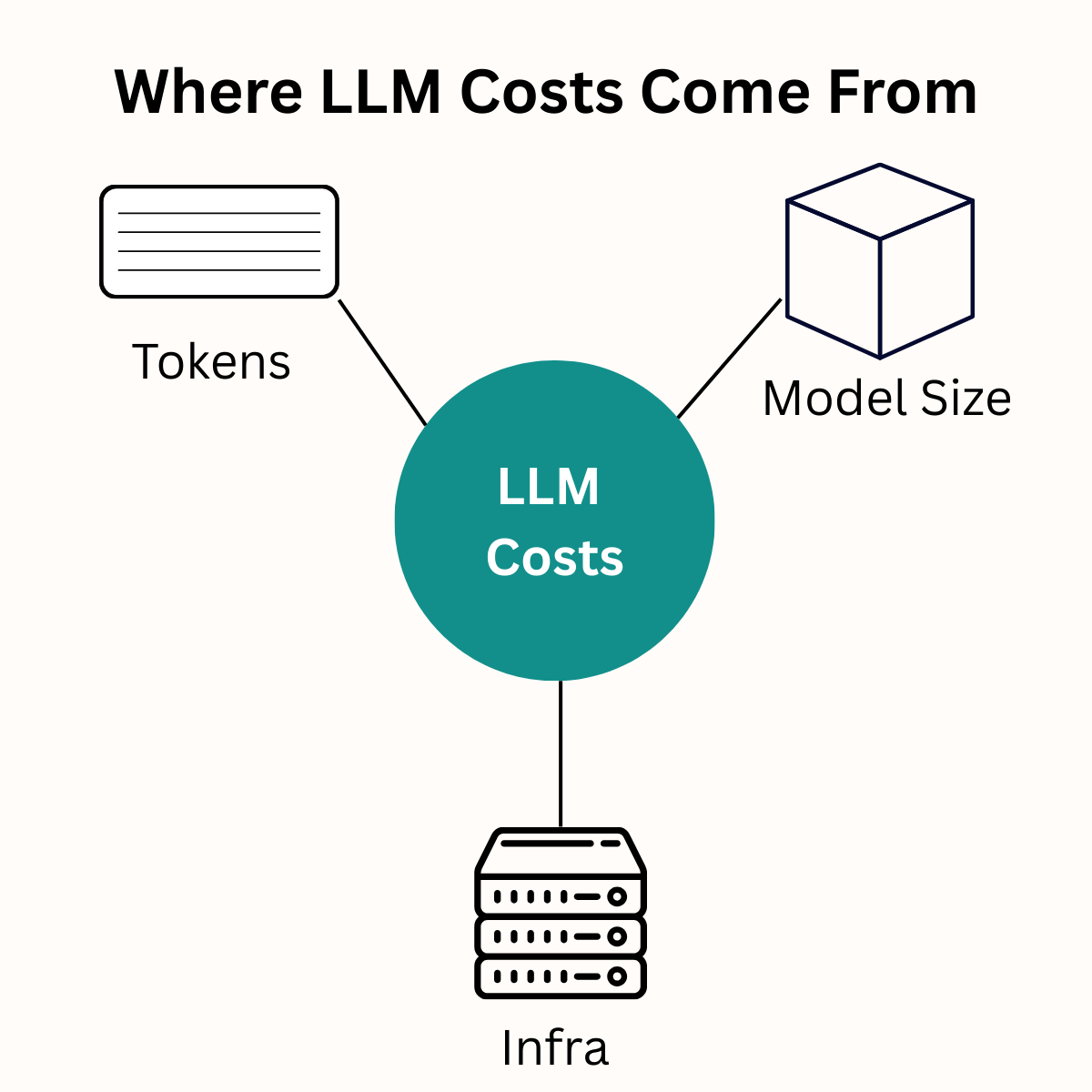

LLM API 비용 90% 절약하기 – 성능 저하 없이 AI 서비스 비용을 줄이는 7가지 전략

LLM API 운영 비용을 90%까지 절감할 수 있는 7가지 실무 전략을 소개한다. 프롬프트 최적화, 적절한 모델 선택, 하이브리드 추론 등 검증된 방법론을 통해 성능 저하 없이 AI 서비스 비용을 대폭 줄이는 구체적인 실행 방안을 제시한다.

Written by

Redis 8의 시맨틱 캐싱으로 LLM 비용 90% 절감하기

Redis 8의 혁신적인 시맨틱 캐싱 기술로 LLM 운영 비용을 대폭 절감하는 방법을 상세히 알아보세요. Vector Sets, LangCache, Redis Flex 등 새로운 기능들과 다양한 캐싱 전략을 실무 관점에서 분석합니다.

Written by