Vercel이 AI 에이전트 마켓플레이스와 개발 도구를 동시에 공개하며, 에이전트 배포와 운영의 복잡성을 해소하는 통합 플랫폼을 선보였습니다. 10년 전 웹 프레임워크가 그랬듯, 이번에도 복잡성의 제거가 새로운 혁신의 시작점이 될 것입니다.

핵심 포인트:

- 실전 검증된 생산성: Vercel 내부에서 고객 지원 티켓 1/3 감축, 보안 위협 자동 분석, Slack 대화에서 블로그 초안까지 자동 생성하며 실제 효과 입증

- 통합 기술 스택: AI SDK(주간 300만 다운로드) + AI Gateway(20ms 미만 라우팅, 마크업 0%) + Fluid Compute(사고 중에만 과금) + Workflow Development Kit(내구성 있는 장기 실행)로 개발부터 운영까지 완결

- Build or Buy 전략: CodeRabbit, Corridor 등 즉시 사용 가능한 에이전트부터 커스텀 개발까지, 선택의 자유와 확장성을 동시에 제공

반복 작업을 제거한 세 가지 내부 에이전트

Vercel은 자사 팀들에게 “가장 하기 싫은 일이 무엇인가?”라고 물었습니다. 그 답변들이 곧바로 에이전트로 구현되었고, 실제 시간을 절약하는 결과로 이어졌습니다.

고객 경험 팀은 지원 에이전트를 만들어 티켓을 1/3 감축했습니다. 문제를 즉시 해결하거나 문서에서 정확한 답변을 찾아주는 방식입니다. 보안 팀은 잠재적으로 위험한 URL을 자동으로 시각 분석하고, 페이지 의도를 파악해 권장 조치를 제시하는 에이전트를 구축했습니다. 콘텐츠 팀은 Slack 스레드를 블로그 초안으로 변환하는 에이전트를 만들어, 아이디어 수집 단계를 자동화하고 빈 페이지에서 시작하는 부담을 덜었습니다.

공통된 패턴은 명확합니다. 팀에게 시간을 돌려주는 것. 아이디어에서 결과물까지의 경로를 단축하고, 단순 작업 대기 시간을 줄이며, 병렬 작업을 누적 진전으로 전환하는 구조입니다.

속도만이 아닙니다. 팀이 걸 수 있는 베팅의 수가 늘어나고, 실험할 수 있는 표면적이 넓어지며, 깊은 사고를 위한 대역폭이 회복됩니다.

프로덕션을 위한 기술 스택

에이전트는 신뢰성과 비용을 일급 관심사로 다루는 환경이 필요합니다. Vercel AI Cloud가 바로 그 환경입니다. 모델 라우팅, 탄력적 컴퓨팅, 격리된 실행, 워크플로 내구성을 한데 모았습니다.

AI SDK는 단일 TypeScript 인터페이스로 모든 주요 LLM 제공자를 통합합니다. 현재 OpenAI 다음으로 인기 있는 JS/TS AI 패키지로, 주간 300만 다운로드를 기록하고 있습니다. 제공자를 바꿔도 코드는 거의 그대로입니다.

AI Gateway는 하나의 키로 여러 모델과 제공자에 접근하게 해줍니다. 20ms 미만의 지연 시간으로 라우팅하고, 자동 failover를 제공하며, 무엇보다 마크업이 0%입니다. 자체 키를 사용할 경우 제공자 직접 사용과 동일한 가격입니다.

Fluid Compute는 코드가 실제로 실행되는 동안만 CPU 비용을 청구합니다. AI 모델 호출이나 데이터베이스 쿼리처럼 외부 서비스의 응답을 기다리는 I/O 작업 중에는 CPU 과금이 중단됩니다. 메모리는 인스턴스가 실행되는 동안 지속적으로 과금되지만, CPU 비용보다 90% 이상 저렴합니다. 최대 실행 시간은 Hobby 플랜 300초, Pro와 Enterprise 플랜은 800초까지 지원됩니다.

Workflow Development Kit (WDK)는 장기 실행 작업의 문제를 해결합니다. 예를 들어 라이드 호출 시스템을 생각해보세요. 요청 검증 → 드라이버 배정 → 승객 알림 → 영수증 생성이라는 여러 단계를 거칩니다. 각 단계는 외부 API를 호출하는데, 중간에 서버가 재시작되거나 네트워크가 끊기면 어떻게 될까요?

export async function hailRide(requestId: string) {

"use workflow"; // 이 함수를 내구성 있는 워크플로로 만듦

const request = await validateRideRequest(requestId); // 1단계

const trip = await assignDriver(request); // 2단계

const confirmation = await notifyRider(trip); // 3단계

const receipt = await createReceipt(trip); // 4단계

return receipt;

}WDK는 함수 맨 위에 "use workflow"를 선언하면, 각 단계의 결과를 자동으로 저장합니다. 만약 2단계를 완료한 직후 서버가 크래시되면, 재시작 후 1~2단계를 다시 실행하지 않고 3단계부터 이어갑니다. 각 await 지점이 체크포인트가 되어 진행 상황을 기록하는 것입니다.

더 강력한 기능은 긴 대기 시간을 처리하는 방식입니다. 예를 들어 고객에게 로열티 리워드를 3일 후에 지급해야 한다면, await sleep("3d")로 워크플로를 일시 중지할 수 있습니다. 이 3일 동안 서버 리소스는 전혀 사용하지 않으며, 3일 후 자동으로 깨어나 다음 작업을 수행합니다.

단계별 실전 구현 가이드

첫 번째 단계는 LLM을 호출하는 것입니다. AI SDK의 generateText 함수를 사용하면 됩니다. AI Gateway를 사용하기 때문에 제공자별 패키지를 설치할 필요가 없습니다. 모델을 문자열로만 정의하면 됩니다.

두 번째 단계는 도구를 정의하는 것입니다. 도구는 모델이 호출할 수 있는 함수입니다. AI SDK는 tool 함수로 도구를 정의하며, 설명과 입력 스키마(Zod로 정의), 그리고 실행 함수를 받습니다.

import { generateText, tool } from 'ai';

import { z } from 'zod';

const result = await generateText({

model: 'openai:gpt-4',

tools: {

weather: tool({

description: '특정 도시의 현재 날씨를 조회합니다',

parameters: z.object({

city: z.string().describe('도시 이름'),

}),

execute: async ({ city }) => {

// 실제 API 호출

return { city, temp: 22, condition: 'sunny' };

},

}),

},

prompt: '서울 날씨 알려줘',

});세 번째 단계는 다단계 에이전트 루프를 구성하는 것입니다. 기본적으로 AI SDK는 1단계로 제한되지만, stopWhen과 stepCountIs를 사용해 여러 단계를 실행할 수 있습니다. 모델은 텍스트를 생성하거나 도구를 호출할지 결정하고, 도구 호출 시 AI SDK가 자동으로 실행하고 결과를 대화 기록에 추가한 뒤 다음 생성을 트리거합니다.

import { generateText, tool, stepCountIs } from 'ai';

const result = await generateText({

model: 'openai:gpt-4',

tools: { /* 도구 정의 */ },

prompt: '서울과 부산의 날씨를 비교해줘',

stopWhen: stepCountIs(5), // 최대 5단계

});프로덕션에 배포할 때는 API 라우트를 생성하면 됩니다. Vercel에 배포되면 자동으로 Fluid compute를 사용해 콜드 스타트를 최소화하고, 백그라운드 작업을 지원하며, 더 긴 실행 시간을 허용합니다.

마켓플레이스: 표준이 충분하면 Buy, 차별화가 필요하면 Build

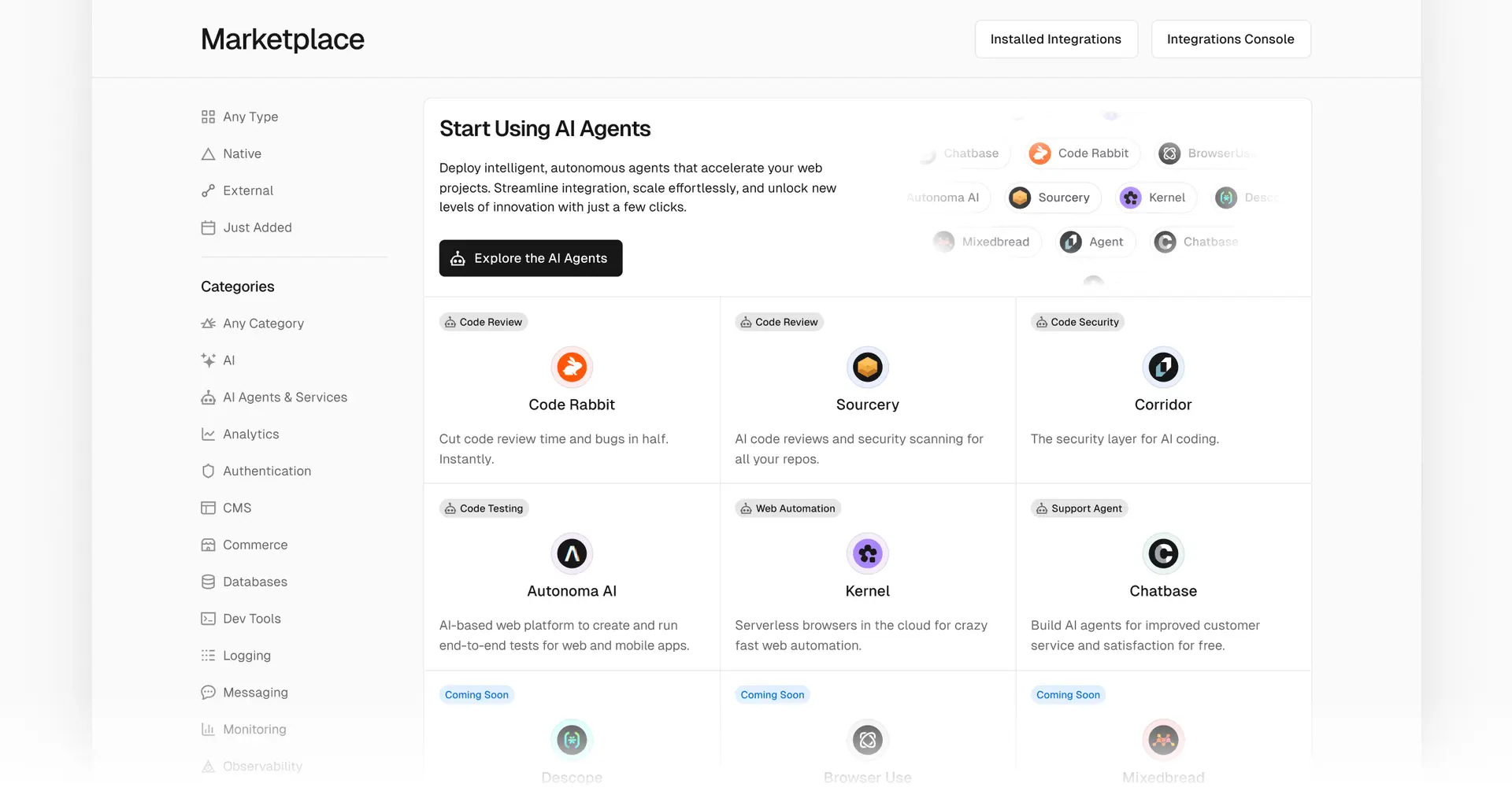

많은 팀은 처음부터 만들기보다 검증된 에이전트를 도입하는 것으로 시작할 것입니다. Vercel은 프로덕션급 에이전트를 찾아 실행할 수 있는 에이전트 마켓플레이스를 공개했습니다.

즉시 사용 가능한 에이전트:

CodeRabbit은 자동 코드 리뷰와 PR 피드백을 제공합니다. Corridor는 실시간 보안 및 위협 감지를 수행하며, 의심스러운 패턴을 찾아 프로덕션에 도달하기 전에 개발 팀에 알립니다. Sourcery는 코드 리뷰와 생성을 지원해 아이디어에서 프로덕션까지 더 빠르게 이동하게 돕습니다.

인프라 서비스:

Braintrust는 평가 및 모니터링 프레임워크를 제공합니다. Kernel은 에이전트 워크로드를 위한 클라우드 브라우저 인프라를 제공하고, Mixedbread는 문서, 코드, 미디어 전반에 걸친 멀티모달 AI 검색 및 검색을 지원합니다. Browser Use는 웹 자동화를 위한 자연어 브라우저 제어를 제공하고, Descope는 사용자, 파트너, AI 에이전트를 위한 노코드 인증 워크플로를 제공합니다.

대시보드에서 에이전트를 설치하고, 필요한 접근 권한을 구성하며, 애플리케이션과 동일한 플랫폼에서 실행할 수 있습니다. 커스텀 로직이 큰 가치를 만들 시점이 오면, SDK를 사용해 워크플로에 맞게 에이전트를 조정하면 됩니다.

일반적인 지침은 명확합니다. 표준으로 충분할 때는 Buy, 차별화가 중요할 때는 Build입니다. 플랫폼은 두 경로를 모두 지원합니다.

시작하는 방법

첫 에이전트를 어디서 시작할지 고민이라면, 팀원들과의 대화부터 시작하세요.

지원, 영업, 재무, 운영, 마케팅, 엔지니어링 각 팀에게 물어보세요. 하루에도 수십 번 반복하는 10~15분짜리 작업이 있는지, 중요한 일을 가로막는 1시간짜리 작업이 무엇인지 말입니다. 이때 입력 조건과 제약사항이 명확하고, 결과물을 바로 내보내기 전에 한 번 검토할 수 있는 작업이 좋습니다. 시간 절약 효과를 측정하기 쉬운 후보를 선택하는 것도 중요합니다.

템플릿으로 시작해서 도구 하나나 둘을 연결하세요. 그리고 작은 그룹과 함께 테스트를 진행합니다. 사용자들이 수정하고 피드백하는 과정에서 시스템은 점점 더 나아집니다.

첫 성공 사례가 만들어지면, 다음 기회는 자연스럽게 보입니다. 같은 방식을 반복하면서 성과는 쌓여갑니다.

AI 에이전트가 만드는 새로운 변화

10년 전 웹 개발은 라우팅과 빌드 스크립트를 직접 작성하던 시대였습니다. Next.js 같은 프레임워크가 등장하면서 복잡성이 사라지자 개발 속도가 빨라졌고, 새로운 제품들이 쏟아져 나왔습니다.

AI 에이전트도 같은 전환점을 맞이했습니다. 모델 호출, 도구 연결, 워크플로 관리를 위한 인프라를 직접 구축하는 대신, 이미 준비된 도구와 플랫폼을 활용할 수 있게 되었습니다. Vercel이 제시한 방식은 하나의 예시이지만, 핵심은 명확합니다. 반복 작업을 제거하고 팀이 본질적인 문제 해결에 집중할 수 있게 만드는 것입니다.

참고자료:

답글 남기기