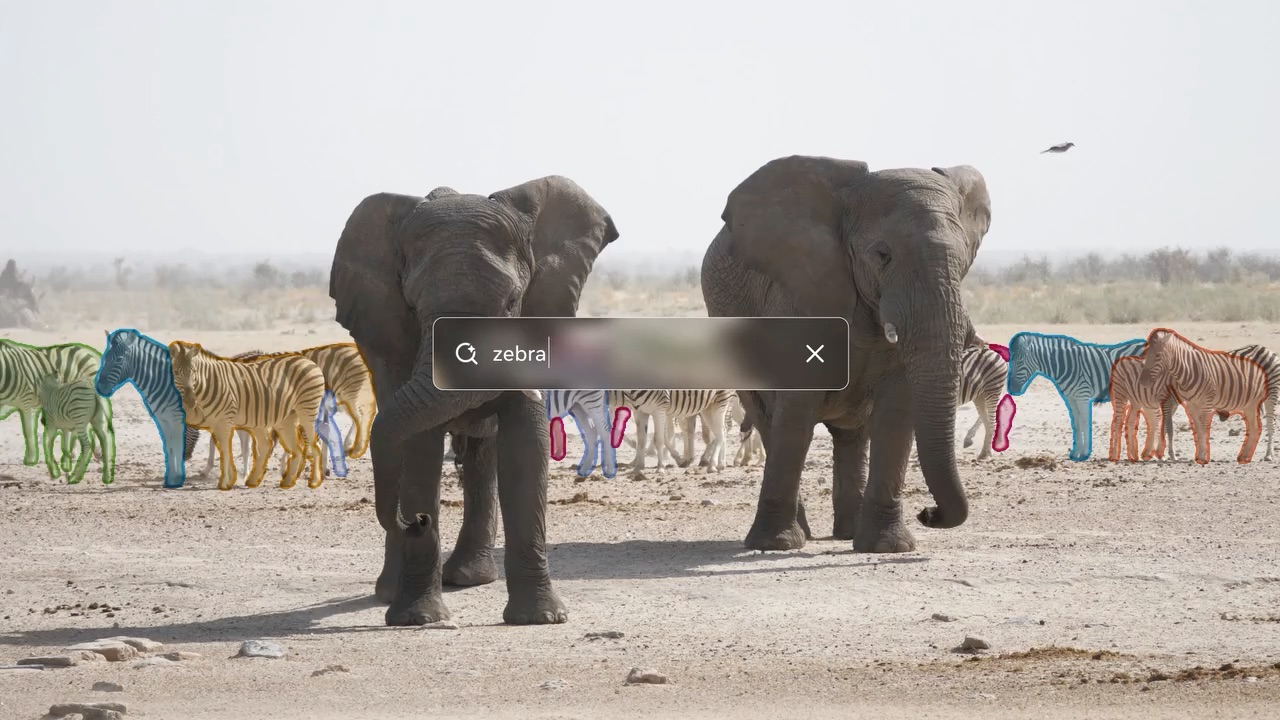

“빨간 야구모자”라고 입력하면 영상 속 모든 빨간 야구모자를 자동으로 찾아 추적합니다. 심지어 “앉아 있는 사람들 중 선물 상자를 들지 않은 사람”처럼 복잡한 조건도 이해하죠. Meta가 공개한 SAM 3는 컴퓨터 비전의 오랜 난제였던 ‘언어-시각 연결’을 해결하며 객체 분할 기술의 새 지평을 열었습니다.

Meta가 Segment Anything Model의 3세대 버전인 SAM 3를 공개했습니다. 텍스트 프롬프트만으로 이미지와 영상에서 객체를 검출하고 추적하는 획기적인 기능을 선보였으며, 기존 시스템 대비 정확도를 2배 향상시켰습니다. Instagram Edits와 Facebook Marketplace 등 실제 서비스에 이미 적용 중입니다.

출처: Introducing Meta Segment Anything Model 3 and Segment Anything Playground – Meta AI Blog

단어만으로 객체를 찾아내다

기존 객체 분할 모델들은 “버스”나 “차” 같은 단순한 개념만 인식할 수 있었습니다. 미리 정해진 라벨 목록에 없는 개념은 처리하지 못했죠. SAM 3는 이 한계를 돌파했습니다. “노란색 스쿨버스”나 “줄무늬 빨간 우산”처럼 구체적이고 세밀한 표현도 정확히 이해합니다.

작동 방식은 간단합니다. 짧은 명사구를 입력하면 SAM 3가 이미지나 영상에서 해당하는 모든 객체를 찾아 분할합니다. 예시 이미지를 보여주는 방식(exemplar prompt)도 지원하죠. 원하는 객체 주변에 박스를 그리면 SAM 3가 비슷한 객체를 모두 찾아냅니다. 기존 SAM 2의 클릭·박스 프롬프트 기능도 그대로 유지돼 다양한 방식으로 활용할 수 있습니다.

AI와 인간이 함께 만든 데이터

이런 성능은 혁신적인 데이터 생성 방식에서 나왔습니다. Meta는 SAM 3와 Llama 기반 AI 모델, 그리고 인간 어노테이터를 결합한 하이브리드 시스템을 구축했습니다. AI 모델이 이미지와 영상을 자동으로 분석해 캡션을 생성하고 초기 분할 마스크를 만들면, 인간과 AI 어노테이터가 이를 검증하고 수정합니다.

이 방식은 기존 인간 중심 파이프라인보다 2배 이상 빠릅니다. 특히 이미지에 없는 개념을 확인하는 작업(네거티브 프롬프트)에서는 5배, 어려운 세밀한 영역에서도 36% 더 빠르죠. AI 어노테이터가 쉬운 사례를 자동으로 걸러내 인간은 가장 어려운 케이스에만 집중할 수 있었습니다. 이렇게 400만 개 이상의 독특한 개념을 학습한 대규모 데이터셋이 완성됐습니다.

실전에 투입된 SAM 3

성능 수치도 인상적입니다. Meta가 새로 공개한 SA-Co(Segment Anything with Concepts) 벤치마크에서 SAM 3는 기존 시스템보다 cgF1 점수(개념 인식 및 위치 추정 정확도)를 2배 향상시켰습니다. Gemini 2.5 Pro 같은 범용 모델과 GLEE, OWLv2 같은 전문 모델들을 모두 앞섰죠. 사용자 테스트에서는 가장 강력한 경쟁 모델인 OWLv2보다 약 3:1 비율로 선호되었습니다.

추론 속도도 빠릅니다. H200 GPU에서 100개 이상의 객체가 있는 단일 이미지를 30밀리초에 처리합니다. 영상에서는 약 5개 객체까지 거의 실시간으로 추적 가능하죠.

SAM 3는 이미 실제 서비스에 투입됐습니다. Instagram의 영상 제작 앱 Edits에서는 곧 크리에이터들이 특정 사람이나 객체에만 효과를 적용할 수 있게 됩니다. 복잡한 편집 작업을 한 번의 탭으로 처리하는 거죠. Facebook Marketplace의 ‘View in Room’ 기능은 SAM 3와 SAM 3D를 활용해 가구를 구매 전에 자신의 공간에 가상으로 배치해볼 수 있게 합니다.

과학 분야에서도 활용이 시작됐습니다. Conservation X Labs, Osa Conservation과 협력해 만든 SA-FARI 데이터셋은 100종 이상의 야생동물이 담긴 1만 개 이상의 카메라 트랩 영상을 제공합니다. 모든 프레임의 동물에 경계 박스와 분할 마스크가 달려 있어 야생동물 모니터링 연구에 바로 쓸 수 있죠.

열린 가능성, 남은 과제

SAM 3는 짧은 텍스트 프롬프트에서 탁월한 성능을 보이지만 한계도 있습니다. “혈소판”처럼 전문 지식이 필요한 세밀한 개념이나 의료·과학 이미지 같은 특수 영역에서는 제로샷 일반화에 어려움을 겪습니다. “맨 위 선반 오른쪽에서 두 번째 책”처럼 복잡한 설명도 직접 처리하지 못하죠.

다만 Meta는 소량의 데이터로도 빠르게 적응할 수 있는 파인튜닝 방법을 공개했습니다. Roboflow와 파트너십을 맺어 누구나 데이터를 어노테이션하고 SAM 3를 자신의 용도에 맞게 튜닝할 수 있습니다. Llama 같은 멀티모달 대형 언어 모델과 결합하면 더 복잡한 쿼리도 처리할 수 있고요.

SAM 3의 모델 가중치, 코드, SA-Co 벤치마크 데이터셋은 모두 오픈소스로 공개됐습니다. Segment Anything Playground에서 기술 지식 없이도 바로 테스트해볼 수 있죠. 창작자에게는 새로운 표현 도구가, 개발자에게는 강력한 빌딩 블록이, 연구자에게는 발전의 토대가 될 것입니다.

참고자료:

답글 남기기