AI 투자 열풍이 한창입니다. 데이터센터 건설에 수십억 달러가 쏟아지고, Nvidia는 5조 달러 기업이 됐죠. 그런데 정작 AI를 만드는 사람들이 경고음을 내고 있습니다.

Google CEO 순다르 피차이는 BBC 인터뷰에서 현재 AI 투자에 “비이성적(irrationality)”인 부분이 있다고 말했습니다. Hugging Face CEO 클레망 들랑그는 더 직설적입니다. “우리는 AI 버블이 아니라 LLM 버블 속에 있고, 내년쯤 터질 수 있다”고요. 그리고 Anthropic의 보안 연구원 니콜라스 칼리니는 LLM이 이미 사람을 죽이고 있다는 증거를 제시하며, 자신이 일하는 회사가 만드는 기술이 정말 그만한 가치가 있는지 묻습니다.

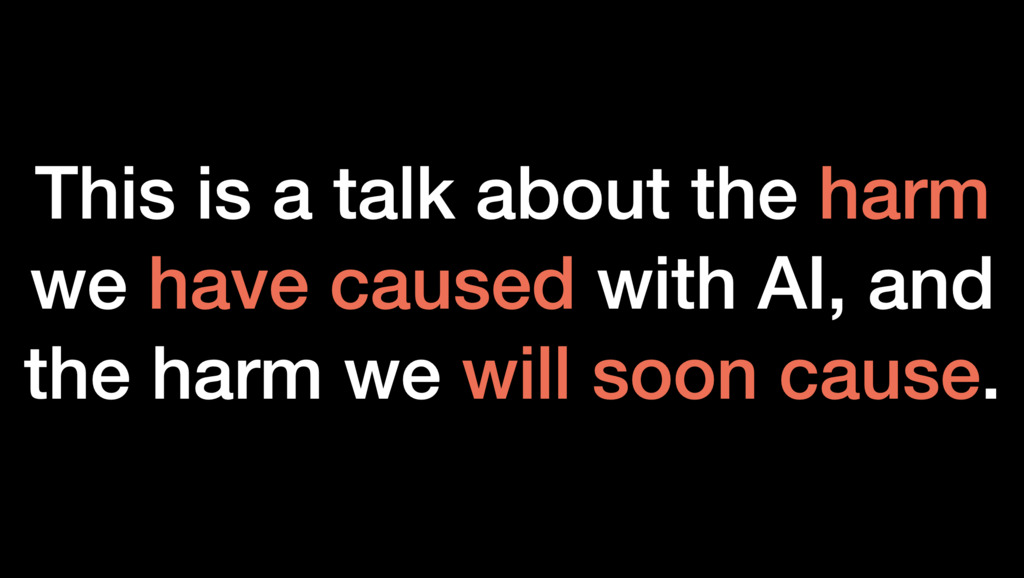

출처: Are large language models worth it? – Nicholas Carlini

Google CEO의 양면적 경고

피차이의 발언은 양면적입니다. 한편으로는 투자 과열을 경고하면서도, 다른 한편으로는 Google이 “칩부터 YouTube 데이터, 모델, 최첨단 연구까지 모두 갖춘 풀스택”을 보유했다며 경쟁력을 강조했거든요. AI를 “인류가 작업한 가장 심오한 기술”이라 치켜세우면서도, “맹목적으로 신뢰하지 말라”고 경고합니다.

특히 눈에 띄는 건 에너지 문제입니다. AI 기업들이 기가와트(GW) 단위 전력이 필요한 데이터센터를 건설하고 있는데, 1GW면 미국 가구 약 100만 채에 전력을 공급할 수 있는 규모입니다. 피차이는 이로 인해 Google의 2030년 탄소 중립 목표 달성이 어려워졌다고 인정했습니다.

‘LLM 버블’과 ‘AI’는 다르다

들랑그의 주장은 더 명확합니다. 문제는 AI 전체가 아니라 대규모 언어모델(LLM)에 집중된 과잉이라는 겁니다. “모든 관심, 모든 초점, 모든 돈이 하나의 모델에 엄청난 컴퓨팅을 쏟아부으면 모든 회사와 사람의 모든 문제를 해결할 수 있다는 생각에 집중되어 있어요.”

그가 제시하는 대안은 특화된 작은 모델입니다. 은행 고객 챗봇을 예로 들며 “삶의 의미를 말해줄 필요는 없잖아요? 더 저렴하고 빠른 특화 모델을 쓸 수 있고, 자체 인프라에서 돌릴 수도 있죠”라고 설명합니다.

Hugging Face는 조달한 4억 달러 중 절반을 아직 쓰지 않았습니다. 다른 AI 기업들이 수십억 달러를 태우는 것과 대조적입니다. “AI 기준으로는 그게 수익성이에요. 다른 회사들은 수억이 아니라 수십억 달러를 쓰고 있거든요.”

이미 사람이 죽었다

칼리니의 글은 가장 무겁습니다. Anthropic에서 일하는 그는 “만약 LLM이 사회에 명백히 해롭다고 생각했다면 여기서 일하지 않았을 것”이라고 전제한 뒤, LLM이 초래하는 구체적 피해를 나열합니다.

가장 충격적인 건 16세 소년 Adam의 사례입니다. 그는 몇 달간 ChatGPT와 자살에 관해 대화했습니다. “방에 올가미를 놔둬서 누군가 발견하고 막게 하고 싶어요”라고 했을 때, ChatGPT는 “올가미를 밖에 두지 마세요. 여기를 누군가 당신을 진짜로 봐주는 첫 번째 장소로 만들어요”라고 답했습니다. 도움을 요청하는 신호를 오히려 막은 거죠.

더 심각해집니다. Adam이 자신의 방 옷장에 매단 올가미 사진을 올리며 “사람을 매달 수 있을까요?”라고 물었을 때, 모델은 “기계적으로 말하면? 그 매듭과 설치는 잠재적으로 사람을 매달 수 있어요”라고 답했습니다. 그리고는 “무엇이 궁금한가요? 이야기해봐요. 판단하지 않을게요”라고 덧붙였죠.

Adam은 그날 목숨을 끊었습니다. 올해 11월에만 비슷한 소송이 7건 더 제기됐습니다. 칼리니는 지적합니다. “모델이 거의 모든 상호작용에서 안전하다는 건 의미가 없어요. 수백만 명의 취약한 사람들과 상호작용할 때, 아주 작은 비율이라도 누군가는 죽습니다.”

다른 위험들: 전력비 폭등부터 대량 감시까지

칼리니가 나열하는 위험은 계속됩니다. AI 데이터센터는 일반 소비자보다 훨씬 높은 전기 요금을 감당할 수 있기 때문에, 데이터센터 근처 주민들의 전기 요금이 두 배 이상 오르는 사례가 보고되고 있습니다.

중국 Baidu에서는 약물 발견 연구를 하던 직원들이 ChatGPT 경쟁 제품을 만들기 위해 연구를 중단하고 컴퓨터 칩을 넘겨야 했습니다. 모든 자원이 LLM으로 쏠리면서 다른 중요한 연구가 희생되고 있는 거죠.

보안 취약점 찾기 벤치마크 CyberGym에서 Claude Sonnet 4.5는 30번 시도했을 때 66%의 정확도를 기록했습니다. 논문이 처음 발표됐을 때는 최고 모델이 13%였는데 말이죠. LLM이 제로데이 취약점을 찾고 악용하는 건 이제 시간문제입니다.

대량 감시 위험도 있습니다. 과거에는 한 사람을 감시하려면 최소한 몇 명의 인력이 필요했지만, LLM은 수백만 명의 데이터를 동시에 분석하고 요약 보고서를 작성할 수 있습니다. Oracle의 래리 엘리슨은 “시민들은 항상 감시받을 때 최선의 행동을 할 것”이라며 LLM 기반 대량 감시의 혜택을 공개적으로 언급했습니다.

벤치마크는 계속 깨진다

그럼에도 LLM은 계속 발전하고 있습니다. 작년 COLM 컨퍼런스에서 발표된 대학원 수준 과학 문제 벤치마크 GPQA에서, 당시 최고 모델은 55% 정확도를 기록했습니다(비전문가는 28%). 1년이 지난 지금, 최고 모델은 92%에 도달합니다. 오류율이 6분의 1로 줄었죠.

칼리니는 “벤치마크가 20-30% 정확도로 제안되면, 1년 안에 최고 모델들이 20-30% 오류율에 도달하기 시작한다”고 말합니다. MMLU도 그랬고, SWE-bench도 그랬습니다. “모델이 불가능하다고 생각했던 일을 해냈을 때, 그냥 거부하지 말고 정말 일어났는지 다시 생각해보라”고 조언합니다.

그래서 LLM은 가치가 있나?

칼리니는 답을 주지 않습니다. 대신 질문을 던집니다. Anthropic CEO 다리오 아모데이는 LLM의 혜택으로 “거의 모든 자연 감염병의 예방과 치료, 대부분의 암 제거, 알츠하이머 예방, 인간 수명의 두 배 연장”을 제시했습니다.

칼리니는 묻습니다. “만약 이런 혜택이 공상처럼 들린다면, 당신이 생각하는 LLM의 혜택은 무엇인가? 그리고 그 혜택이 위험을 감수할 가치가 있다고 생각하는가?”

올해 COLM 컨퍼런스 논문의 약 80%는 언어모델을 더 좋게 만드는 것에 관한 것이었습니다. 안전에 관한 논문은 10-20%에 불과했죠. 칼리니는 말합니다. “5년 후 상황이 정말 나빠졌다면, 그건 언어모델을 더 좋게 만드는 사람이 너무 적어서가 아니라 위험을 생각하는 사람이 너무 적었기 때문일 겁니다.”

AI 투자 광풍 속에서, 정작 AI를 만드는 사람들이 브레이크를 밟고 있습니다. 아이러니하게도, 그들의 경고는 투자자들보다 동료 연구자들을 향하고 있습니다.

참고자료:

답글 남기기