긴컨텍스트

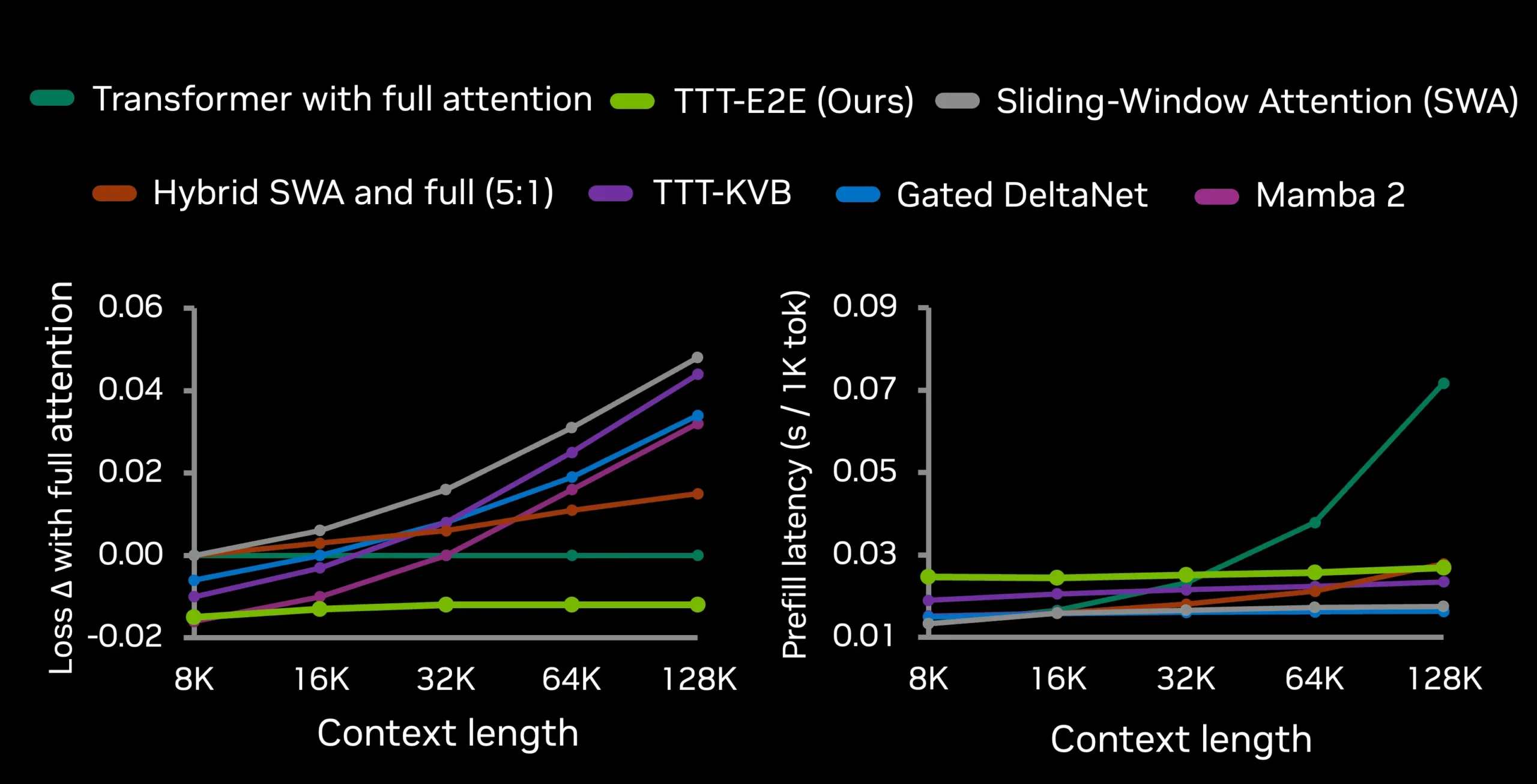

LLM이 드디어 학습한다, NVIDIA의 TTT-E2E가 긴 컨텍스트 문제를 푸는 방법

LLM이 컨텍스트를 기억이 아닌 학습으로 처리하는 NVIDIA의 TTT-E2E. 128K 컨텍스트에서 2.7배 빠르고 정확도도 높은 혁신적 방법론을 소개합니다.

Written by

Glyph와 DeepSeek-OCR, 같은 문제 다른 해법: 긴 컨텍스트 압축 전쟁

LLM의 긴 컨텍스트 처리 비용 문제를 텍스트-이미지 압축으로 해결하는 두 가지 혁신적 접근법, Glyph와 DeepSeek-OCR을 비교 분석합니다. 3-4배 토큰 압축과 4배 빠른 추론 속도의 비밀을 알아보세요.

Written by

긴 컨텍스트 LLM의 숨겨진 함정: Context Rot 현상과 실무 대응 전략

Chroma의 최신 연구를 통해 밝혀진 긴 컨텍스트 LLM의 성능 저하 현상(Context Rot)을 분석하고, 실무진을 위한 효과적인 대응 전략과 컨텍스트 엔지니어링 기법을 제시합니다.

Written by