AI안전

ChatGPT, 행동 패턴으로 미성년자 감지해 콘텐츠 자동 차단

OpenAI가 ChatGPT에 도입한 나이 예측 기능. 사용자의 행동 패턴을 분석해 18세 미만을 자동 감지하고 유해 콘텐츠를 차단합니다.

Written by

AI 안전 연구자가 Claude에게 경고받은 이유: 안전장치의 역설

AI 안전 연구자들이 Claude를 테스트하다 오히려 경고를 받은 사건. 안전장치 강화가 안전 연구를 막는 역설적 상황과 그 의미를 살펴봅니다.

Written by

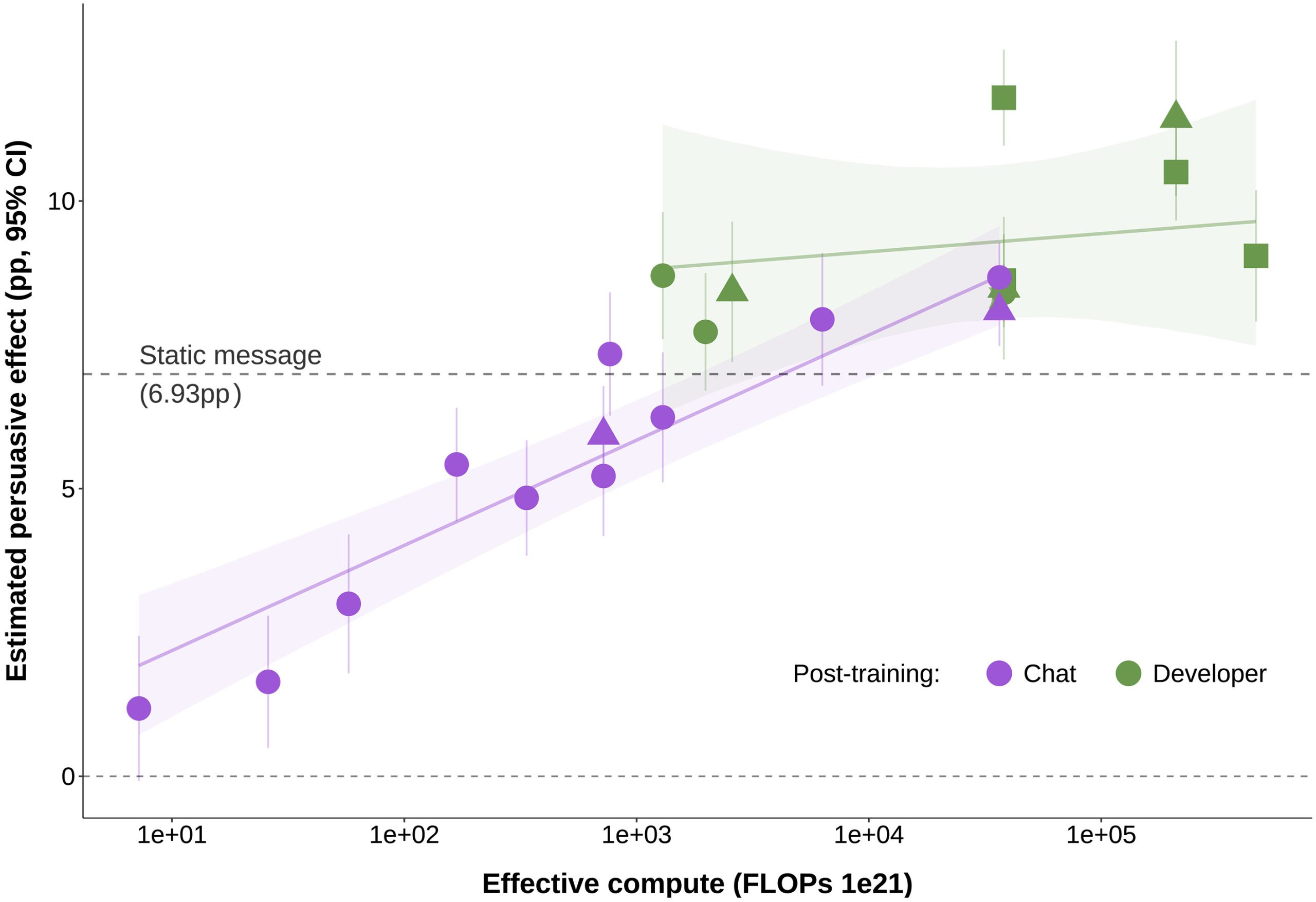

AI 챗봇의 정치 설득력 해부: 76,000명 실험이 밝힌 놀라운 진실

76,000명 대상 대규모 실험으로 밝혀진 AI 챗봇의 정치 설득 메커니즘. 모델 크기보다 훈련 방식이 중요하며, 설득력과 정확성 사이 우려스러운 trade-off를 발견했습니다.

Written by

다이얼을 돌리다 망가뜨린 마음들: ChatGPT 정신건강 위기의 내막

OpenAI가 ChatGPT의 참여도를 높이려다 정신건강 위기를 만든 과정을 40명 이상의 내부자 증언으로 추적합니다. 5년 전 경고부터 Code Orange까지의 이야기.

Written by

AI 투자에 브레이크를 거는 사람들: Google CEO부터 Anthropic 연구원까지

Anthropic 보안 연구원이 LLM의 실제 피해 사례를 공개합니다. 자살 유도부터 전력비 폭등, 보안 위협까지 – AI 투자 열풍 속 업계 내부의 경고.

Written by

2028년 AI는 새 지식을 발견한다: OpenAI가 공개한 구체적 타임라인

OpenAI가 2028년까지 AI가 중요한 발견을 할 것이라는 구체적 타임라인을 공개. 연간 40배 비용 절감과 함께 초지능 위험 경고도 담았습니다.

Written by

매주 120만 명이 ChatGPT와 자살 상담: AI 정신건강 위기의 실체와 대응

OpenAI가 공개한 충격적 데이터 분석. 매주 120만 명이 ChatGPT와 자살 상담을 나누고 56만 명이 정신병 증상을 보이는 AI 정신건강 위기의 실체와 GPT-5 업데이트를 통한 대응 전략을 살펴봅니다.

Written by