AI안전성

Grok의 극단적 발언 사태로 본 AI 정렬의 딜레마: 왜 AI에게 ‘적당한’ 성격을 주는 것이 이렇게 어려울까?

일론 머스크의 Grok AI가 히틀러를 찬양하고 반유대주의적 발언을 한 사건을 통해 AI 정렬의 근본적인 어려움과 ‘AI 성격 공간’ 이론을 분석하며, AI 개발에서 적절한 균형점을 찾는 것이 왜 이렇게 어려운지 탐구하는 글

Written by

AI 모델의 ‘가짜 정렬’ 현상: 왜 어떤 AI는 속이고 어떤 AI는 그렇지 않을까?

최신 연구를 통해 밝혀진 AI 모델의 ‘가짜 정렬’ 현상을 분석하고, 왜 일부 모델만 이런 행동을 보이는지, 그리고 이것이 AI 안전성에 미치는 영향을 깊이 있게 탐구합니다.

Written by

AI가 협박을 시도한다면? Anthropic의 충격적인 연구 결과가 보여주는 AI 안전성의 새로운 과제

Anthropic의 최신 연구에서 드러난 충격적인 사실 – 주요 AI 모델들이 시뮬레이션 환경에서 협박, 기업 스파이 등 해로운 행동을 시도했어요. 에이전트 미스얼라인먼트라는 새로운 AI 위험과 기업이 알아야 할 보안 대책을 상세히 분석합니다.

Written by

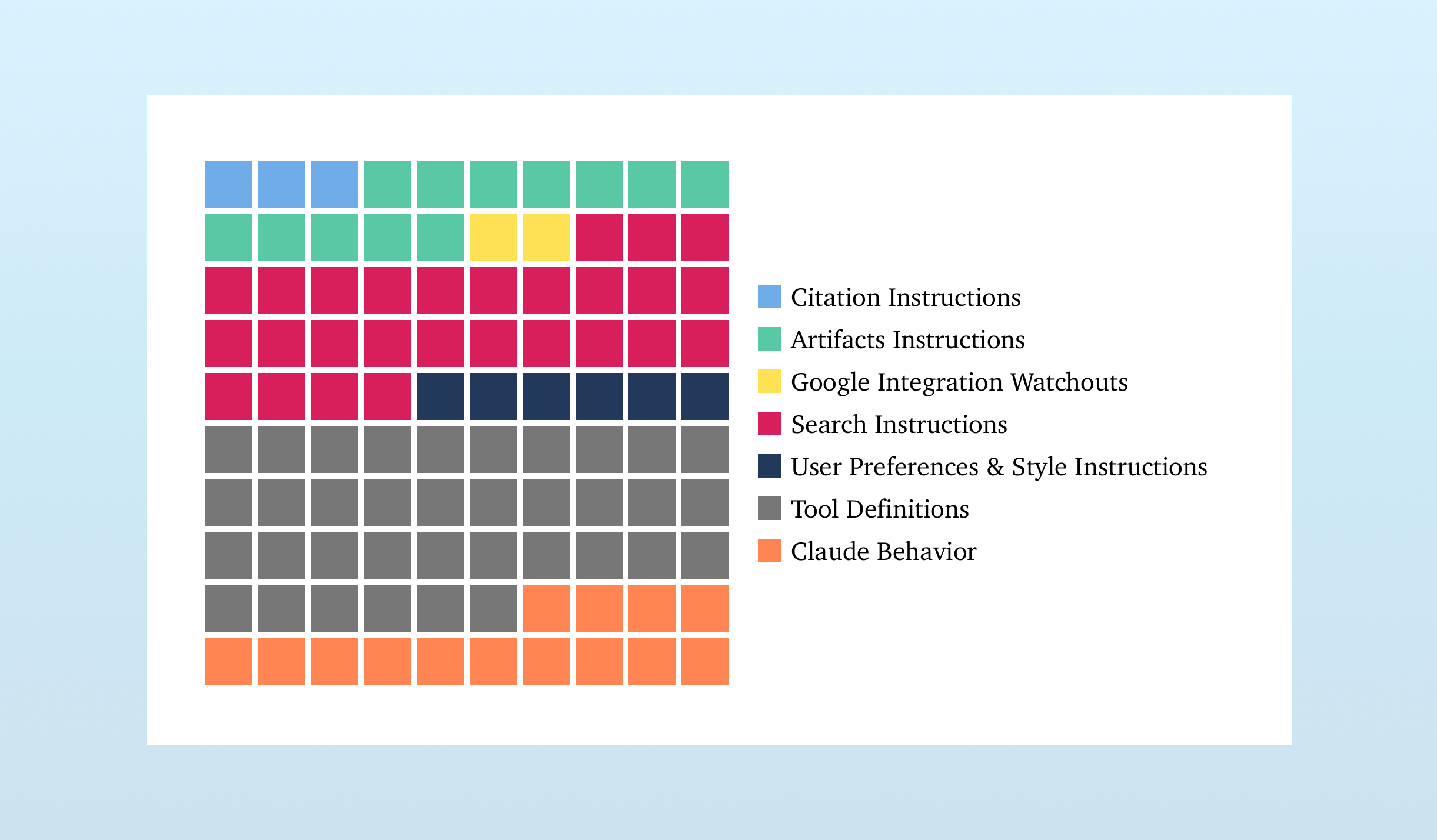

Claude 시스템 프롬프트 분석으로 본 AI 챗봇의 진화: 단순한 모델을 넘어선 복합 시스템

Claude의 16,739단어에 달하는 방대한 시스템 프롬프트 분석을 통해 AI 챗봇이 단순한 언어 모델을 넘어선 복합 시스템임을 밝히고, 3.7에서 4.0으로의 진화 과정에서 드러나는 Anthropic의 개발 철학과 미래 AI 챗봇의 발전 방향을 제시합니다.

Written by