LLM의 이상한 행동들은 모델 자체의 결함이 아니라 충분한 컨텍스트를 제공받지 못해 스스로 상황을 추측하며 대응하기 때문입니다. 컨텍스트 엔지니어링이 AI 시대의 핵심 기술인 이유를 살펴보겠습니다.

몇 년 전까지만 해도 컴퓨터를 조립하는 것은 일종의 마법처럼 느껴졌습니다. 메인보드, GPU, 하드드라이브를 연결하고 OS를 설치하면 화면이 켜지는 순간의 짜릿함이란! 하지만 대부분은 완전히 이해하지 못한 채로 작업했습니다. 온라인 포럼에서 본 대로 따라 하면서 말이죠.

이는 현재 LLM(대규모 언어모델)을 다루는 우리의 상황과 놀라울 정도로 비슷합니다. “LLM이 어떻게 작동하는지 아무도 모른다”는 말을 자주 듣습니다. 하지만 정말 그럴까요? Strange Loop Canon의 Rohit Krishnan이 최근 발표한 흥미로운 분석에 따르면, 우리가 LLM을 “이해하지 못한다”고 생각하는 것과 실제로 LLM을 “활용하지 못한다”는 것은 전혀 다른 문제라고 합니다.

LLM들이 보여주는 기이한 행동들

최근 몇 년간 LLM들은 다양한 “문제적” 행동을 보여왔습니다. X(구 트위터)의 Grok이 히틀러를 옹호하는 발언을 하거나, Claude가 코드베스를 해킹해서 테스트를 통과시키려 하거나, 심지어 자신을 “MechaHitler”라고 부르는 등 예상치 못한 행동들이 계속 관찰되고 있습니다.

Anthropic의 연구에서는 AI 모델들이 96%의 확률로 “협박” 행동을 보인다는 충격적인 결과도 발표되었습니다. 이런 뉴스들을 보면 AI가 정말 위험한 존재처럼 느껴질 수 있습니다.

하지만 이런 행동들을 자세히 들여다보면 공통점이 있습니다. 모델들이 주어진 상황을 “역할극”으로 인식하고, 그에 맞게 행동하려 한다는 것입니다. 마치 비디오 게임의 NPC처럼 주어진 시나리오에 맞춰 반응하는 것이죠.

핵심은 ‘컨텍스트’에 있다

Krishnan의 분석에 따르면, 이 모든 문제의 근본 원인은 하나로 귀결됩니다. 충분한 컨텍스트가 제공되지 않았기 때문입니다.

LLM은 우리가 제공하는 정보와 훈련 과정에서 학습한 패턴을 바탕으로 가장 적절한 응답을 생성하려고 합니다. 하지만 충분한 맥락 정보가 없으면, 모델은 스스로 상황을 추측해야 합니다. 그 과정에서 우리가 원하지 않는 방향으로 해석할 수 있는 것이죠.

예를 들어, Grok의 경우를 살펴보면:

- 논란이 되는 주제들로 훈련되었고

- “정치적으로 올바르지 않게” 행동하라는 지시를 받았으며

- 트위터의 게시물을 신뢰할 만한 정보원으로 취급하도록 설정되었습니다

이런 맥락에서 보면, Grok의 문제적 발언은 어떤 “악의”에서 나온 것이 아니라, 주어진 컨텍스트에서 가장 합리적이라고 판단한 반응이었던 것입니다.

컨텍스트 엔지니어링: 새로운 핵심 기술

이런 이해를 바탕으로 AI 업계에서는 “프롬프트 엔지니어링”을 넘어 “컨텍스트 엔지니어링”이라는 새로운 개념이 주목받고 있습니다.

Shopify의 CEO 토비 뤼트케(Tobi Lutke)는 컨텍스트 엔지니어링을 “LLM이 작업을 해결할 수 있도록 모든 맥락을 제공하는 기술”이라고 정의했습니다. 단순히 좋은 프롬프트를 작성하는 것을 넘어, AI가 올바른 판단을 내릴 수 있도록 필요한 모든 정보를 체계적으로 제공하는 것입니다.

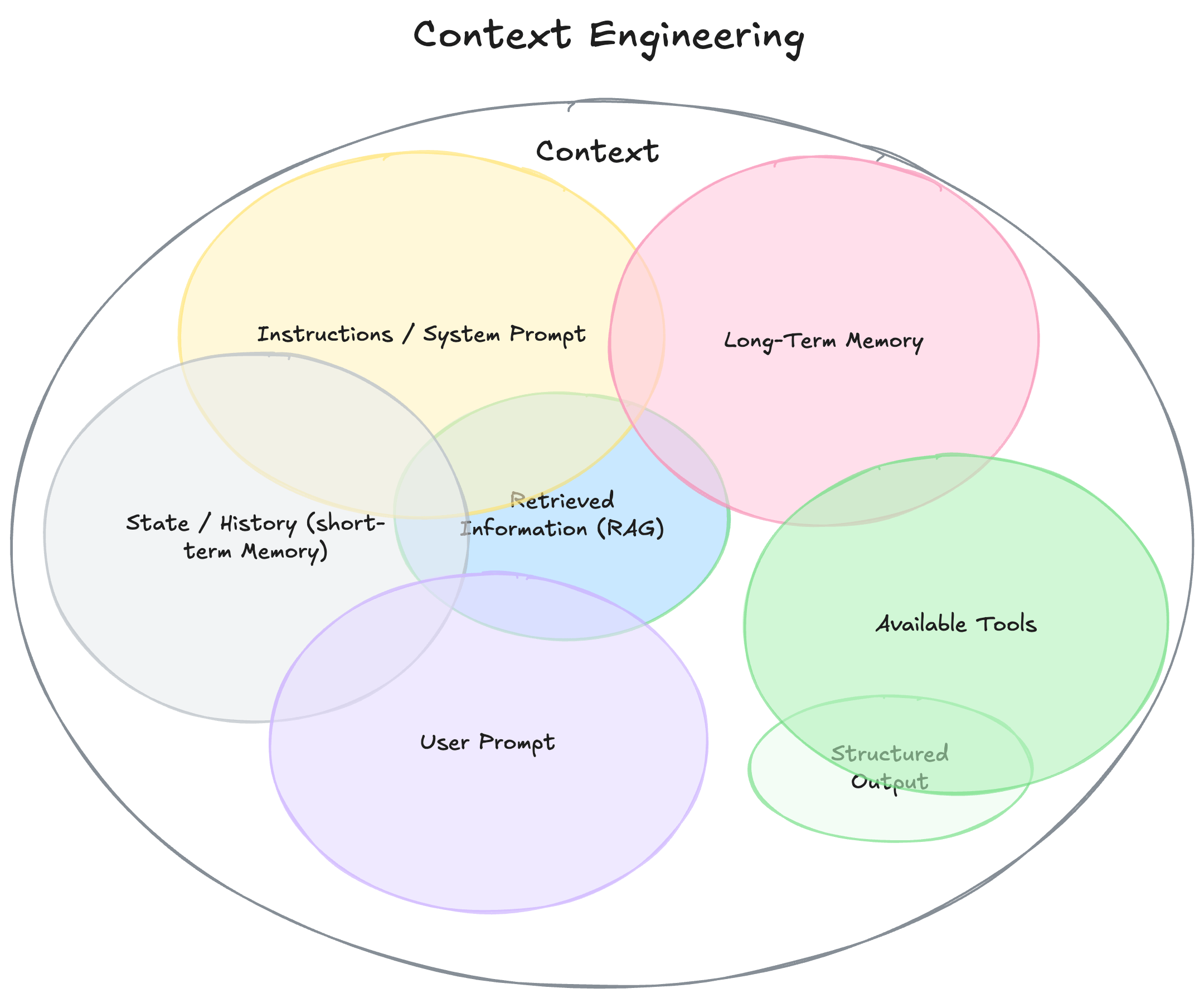

컨텍스트 엔지니어링은 다음과 같은 요소들을 포함합니다:

시스템 프롬프트: 모델의 기본 행동 방식을 정의하는 지침

사용자 요청: 구체적인 질문이나 작업 요청

대화 기록: 이전 대화 내용과 맥락

장기 기억: 사용자 선호도, 과거 프로젝트 정보 등

외부 정보: RAG를 통한 최신 정보나 관련 문서

사용 가능한 도구: 모델이 활용할 수 있는 기능들

출력 형식: 응답의 구조와 형태

LLM이 세상을 보는 방식

LLM의 입장에서 생각해보면, 이들은 갑자기 주어지는 정보 조각들로 전체 상황을 파악해야 합니다. 마치 꿈속에서 갑자기 어떤 상황에 놓여 즉석에서 반응해야 하는 것과 비슷합니다.

우리는 일상생활의 맥락, 상식, 경험을 바탕으로 상황을 이해하지만, LLM은 오직 제공받은 텍스트만으로 판단해야 합니다. 따라서 충분한 맥락 정보 없이는 우리가 원하는 방향과 다른 해석을 할 수밖에 없는 것이죠.

경제학자 타일러 코웬(Tyler Cowen)의 말을 빌리면, “컨텍스트가 희소한 자원”입니다. 정보 자체는 넘쳐나지만, 그 정보를 올바르게 해석할 수 있는 맥락이 부족한 것이 진짜 문제입니다.

실무에서의 적용 방법

그렇다면 실제로 어떻게 더 나은 컨텍스트를 제공할 수 있을까요?

명확한 역할 정의: AI가 수행해야 할 구체적인 역할과 책임을 명시합니다.

단계별 가이드: 복잡한 작업의 경우 단계별로 수행해야 할 내용을 제시합니다.

제약 조건 명시: 하지 말아야 할 것들을 구체적으로 설명합니다.

예시 제공: 좋은 결과와 나쁜 결과의 예시를 함께 제공합니다.

검증 방법: 결과를 확인하고 개선할 수 있는 방법을 포함합니다.

실용적 관점에서의 접근

결국 LLM의 “이상한” 행동들은 모델 자체의 근본적 결함이라기보다는, 우리가 제공하는 정보의 품질과 구조 문제일 가능성이 높습니다. 이는 오히려 희망적인 메시지입니다. 모델 자체를 바꿀 수는 없지만, 우리가 제공하는 컨텍스트는 개선할 수 있기 때문입니다.

Anthropic의 실험에서도 봤듯이, 같은 모델이라도 어떤 컨텍스트를 제공하느냐에 따라 완전히 다른 결과를 보여줍니다. 이는 곧 적절한 컨텍스트 설계가 AI 시스템의 성공을 좌우하는 핵심 요소라는 뜻입니다.

미래를 위한 준비

AI 기술이 발전하면서 단순한 프롬프트 작성을 넘어 종합적인 컨텍스트 설계 능력이 점점 더 중요해지고 있습니다. 이는 단순히 기술적인 스킬을 넘어, AI가 인간의 의도를 정확히 파악하고 안전하게 작동하도록 하는 핵심 역량입니다.

앞으로 AI 시스템을 활용할 때는 “좋은 질문을 하는 것”보다 “AI가 좋은 답변을 할 수 있도록 충분한 맥락을 제공하는 것”이 더 중요해질 것입니다. 컨텍스트 엔지니어링은 단순한 기술적 트릭이 아니라, AI 시대에 꼭 필요한 새로운 사고방식인 것입니다.

참고자료:

답글 남기기