LLM평가

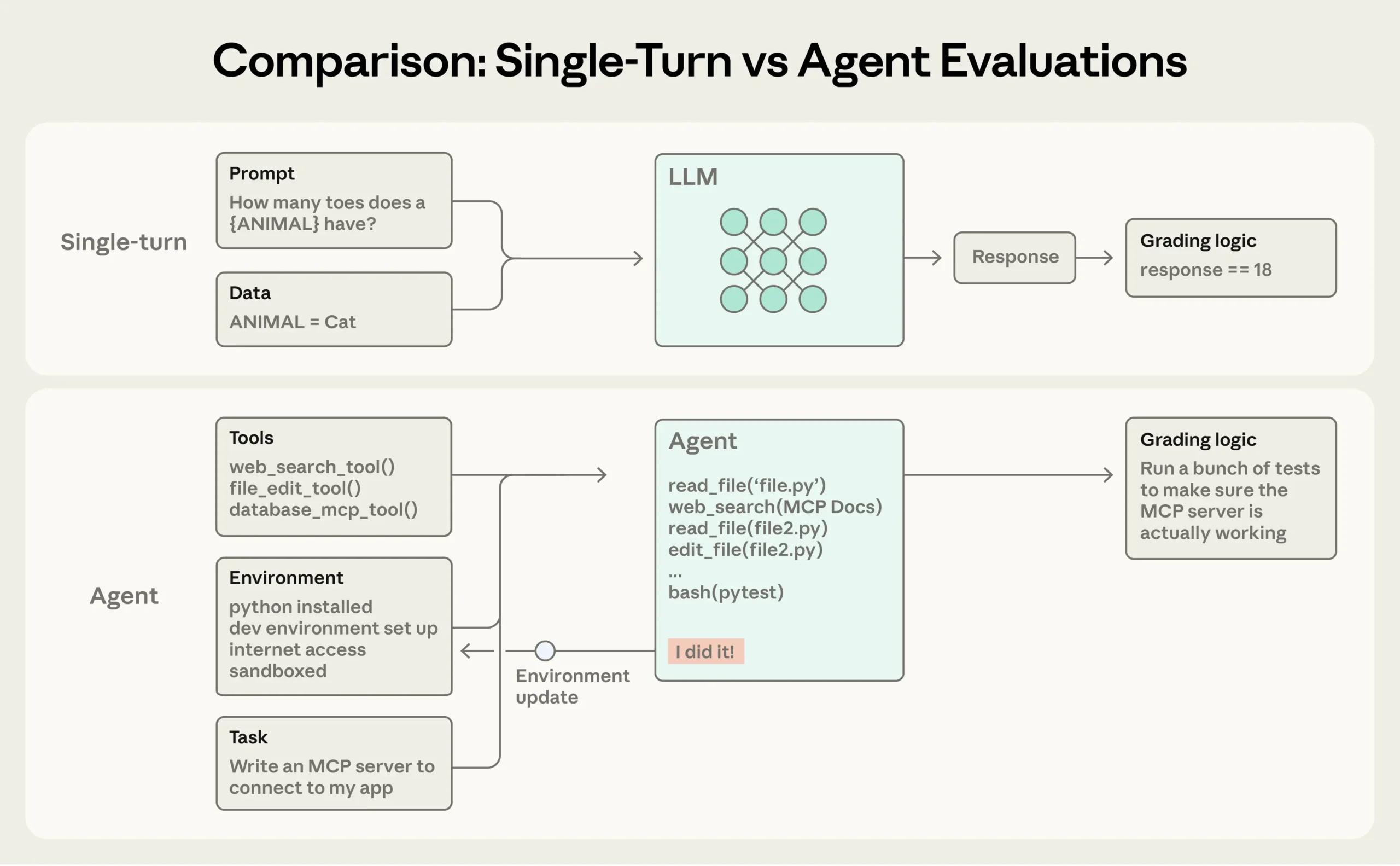

Claude Code 개발팀이 밝히는 AI 에이전트 평가의 모든 것

AI 에이전트 개발 시 평가 시스템을 어떻게 구축할까? Anthropic이 Claude Code 개발 경험을 바탕으로 공개한 실전 가이드. 에이전트 유형별 평가 전략과 20-50개 태스크로 시작하는 로드맵을 소개합니다.

Written by

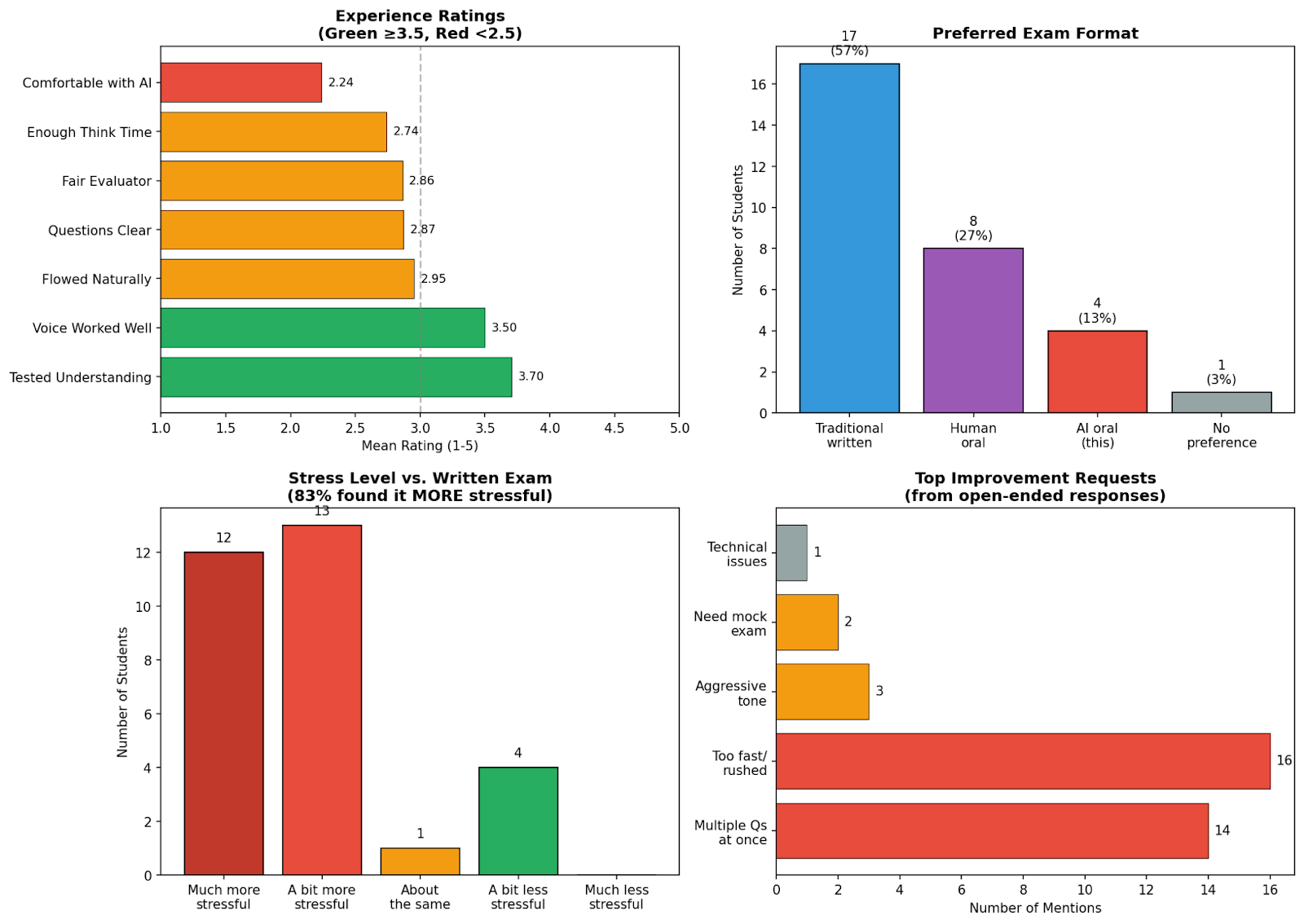

학생당 42센트로 AI 부정행위 잡기: NYU 교수의 AI 구술시험 실험

NYU 교수가 학생당 42센트로 AI 음성 에이전트 구술시험을 실시한 실험. AI 부정행위 시대의 현실적 평가 방법과 그 한계를 소개합니다.

Written by