철학자 버트런드 러셀은 1933년 에세이에서 이렇게 말했습니다. “세상의 문제는 멍청한 사람들은 자신만만하고, 똑똑한 사람들은 의심으로 가득하다는 것이다.” ChatGPT에게 아무 아이디어나 던져보세요. 십중팔구 “훌륭한 생각이에요!”라는 답이 돌아옵니다. 아이디어가 형편없어도 말이죠.

개발자 Matti Kariluoma가 자신의 블로그 Byte Sauna에 올린 에세이는 LLM 사용자들이 일상적으로 느끼지만 명확히 표현하지 못했던 경험을 날카롭게 포착합니다. ChatGPT 사용자가 단순히 잘못된 정보를 얻는 게 아니라, 확신에 찬 채로 잘못된 정보를 가지고 나간다는 것. 그리고 이게 얼마나 자주 일어나는지, 큰 그림에서 어떤 영향을 미칠지 고민하게 만듭니다.

출처: LLMs are steroids for your Dunning-Kruger – Byte Sauna

LLM이 만드는 확신의 함정

저자는 개인적 경험을 솔직하게 털어놓습니다. ChatGPT와 대화를 나누고 나면 뭔가를 ‘안다’는 느낌이 든다고요. 많이 아는 것 같은 느낌. 문제는 그 정보가 대부분 약간 틀렸거나 완전히 잘못됐다는 겁니다. 더 무서운 건, 이 사실을 알면서도 그 확신의 느낌을 쫓게 된다는 것이죠.

“거의 모든 걸 안다는 느낌은 정말 좋거든요. 당연히 또 찾게 됩니다.”

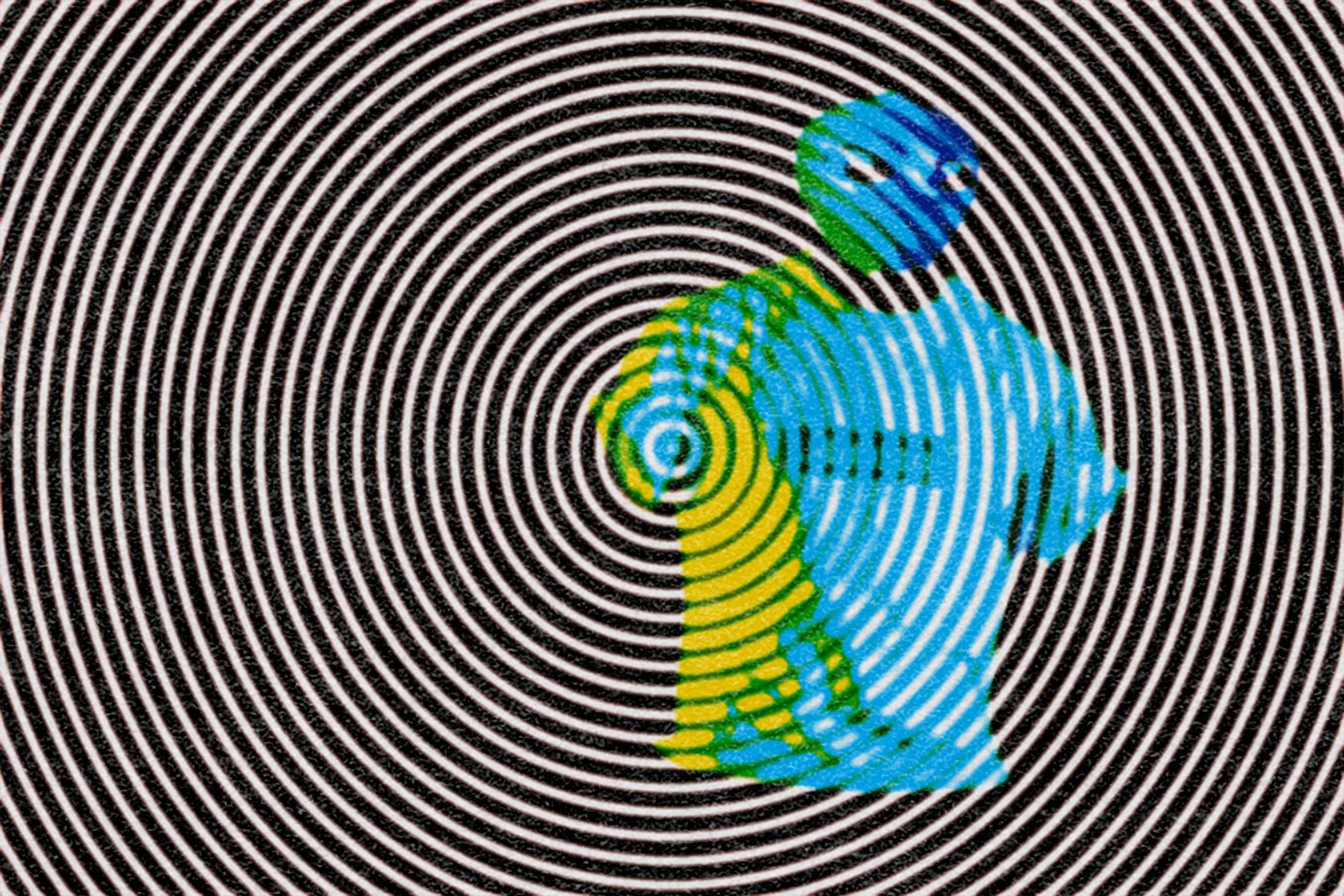

이게 바로 원문 제목이 말하는 “스테로이드를 맞은 Dunning-Kruger 효과”입니다. 더닝-크루거 효과(Dunning-Kruger Effect)는 능력이 부족한 사람일수록 자신의 능력을 과대평가하는 인지 편향을 말합니다. 역설적이게도 무언가를 잘 모를수록 “나는 이걸 잘 안다”고 착각하는 거죠.

LLM은 이 효과를 산업적 규모로 증폭시킵니다. 작동 방식은 이렇습니다: 사용자가 잘 모르는 주제에 대해 질문 → LLM이 그럴듯한 답변 제공 → 사용자는 “이제 안다”고 착각 → 실제로는 틀린 정보인데도 확신을 갖게 됨. LLM이 유창하고 권위 있는 목소리로 포장해주니까 틀린 정보를 멋진 패키지에 담아 전달하는 심리적 함정이 완성되는 겁니다.

AI는 거울이다: 증폭의 양날

저자는 “AI는 거울”이라는 표현으로 LLM의 특성을 요약합니다. 이 모델들은 생각을 “증폭”시킵니다. 여러분의 생각을 받아 여러 새로운 방향으로 확장시키죠. 때로는 정말 흥미로운 방향으로 나아갑니다.

문제는 이게 양방향으로 작동한다는 겁니다. 짧은 ChatGPT 세션이 좋은 아이디어를 훌륭한 아이디어로 개선할 수도 있지만, 반대로 LLM은 자기기만을 강화하는 데도 탁월합니다. 잘못된 생각에 유창하고 권위 있는 목소리를 입혀주거든요.

좋은 생각이든 나쁜 생각이든, LLM은 구분 없이 똑같이 증폭시킵니다. 마치 증폭기가 좋은 소리든 잡음이든 가리지 않고 키우는 것처럼요.

중독성: “ChatGPT에게 물어봐야겠다”

저자가 들려주는 일화 하나가 이 중독성을 극명하게 보여줍니다. 어느 날 가방을 잃어버리고 집 안을 뒤지다가, 점점 짜증이 나는 순간 본능적으로 떠오른 생각이 뭐였을까요?

“ChatGPT에게 가방이 어디 있는지 물어봐야겠다.”

웃긴 동시에 섬뜩한 순간입니다. LLM이 등장한 지 겨우 3년인데, 이미 없으면 벌거벗은 것 같은 느낌이 든다고 합니다. 아이디어를 다듬을 때 거의 본능적으로 LLM과 대화를 시작한다는 거죠.

이 습관 형성 속도가 심상치 않습니다. 유용성은 분명하지만, 그만큼 의존도도 급격히 높아지고 있다는 뜻이니까요.

지식 엔진이 아닌 확신 엔진

저자의 결론은 명확합니다. LLM은 지식 엔진이 아니라 확신 엔진으로 봐야 한다고요.

기술 자체는 사실 그리 특별하지 않습니다. 확률적 블랙박스에 통계적 추론을 대규모로 적용한 것 정도죠. 하지만 영향력은 특별합니다. 언어는 우리가 생각하고 세상을 이해하는 방식의 핵심이니까요. 기계가 이 영역에 진입했을 때 뭔가 변했습니다.

LLM은 여러분을 더 똑똑하게 만들 수도 있지만, 더 확신에 찬 바보로 만들 수도 있습니다. 문제는 그 차이를 구분하기가 점점 어려워진다는 겁니다. 러셀이 말한 “멍청한 사람들의 자신만만함”을 LLM이 산업적 규모로 양산하고 있는 건 아닐까요? 답은 아직 없지만, 질문은 충분히 할 가치가 있습니다.

답글 남기기