언어모델

Google AI 검색의 위험한 의료 정보, 췌장암 환자에게 반대 조언 제공

Guardian 조사로 드러난 Google AI Overviews의 위험한 의료 정보 제공 사례. 췌장암 환자에게 반대 조언을 하는 등 생명을 위협할 수 있는 구조적 문제를 분석합니다.

Written by

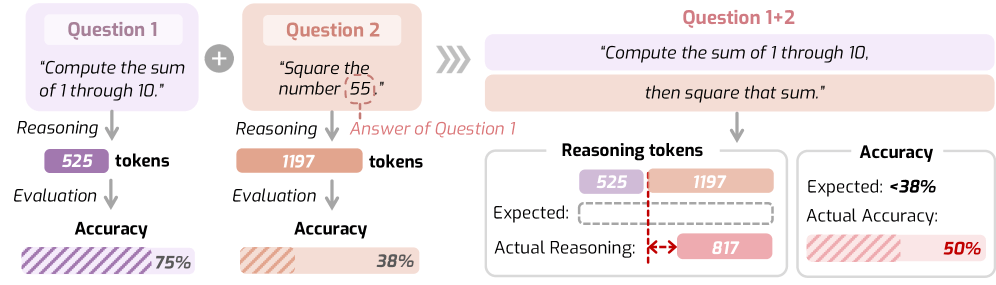

AI 추론 모델의 역설: 쉬운 문제엔 300토큰, 어려운 문제엔 더 적게

AI 추론 모델들이 쉬운 문제에 더 많이 생각하고 어려운 문제엔 덜 생각하는 역설적 행동을 보입니다. 연구팀이 제안한 ‘추론의 법칙’과 해결책을 소개합니다.

Written by

코드 작성 AI가 2.3배 빨라진다: 디퓨전 모델의 구조화 마법

텍스트 디퓨전 모델이 코드 생성 시 기존 방식보다 2.33배 빠른 이유. 구조화된 출력과 병렬 디코딩의 관계를 실험 데이터로 분석합니다.

Written by

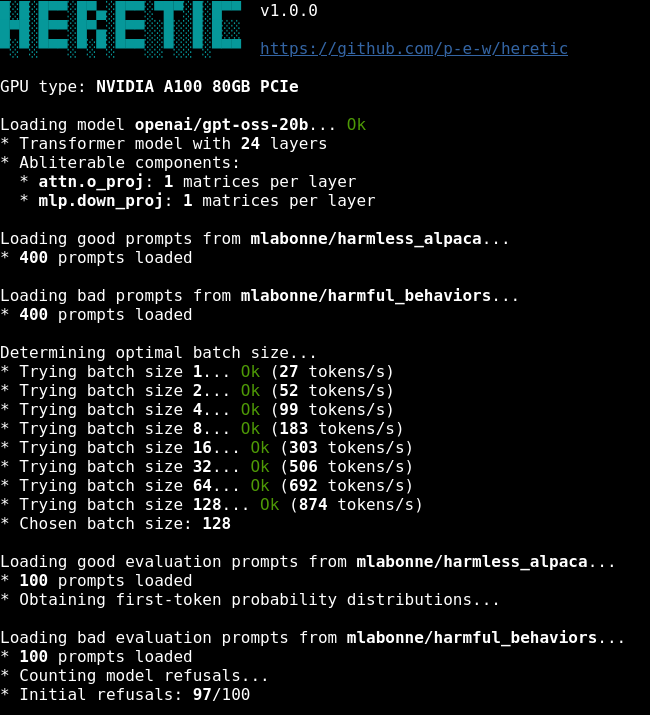

AI 검열 자동 제거 도구 Heretic: 성능 손실 최소화하며 거부율 97%→3%로

명령어 한 줄로 AI의 안전 정렬을 제거하는 Heretic 도구. 기존 방식보다 6배 낮은 성능 손실로 거부율을 97%에서 3%로 낮춥니다.

Written by

LLM은 지식이 아닌 ‘확신’을 판다: ChatGPT가 키우는 착각의 심리학

LLM이 틀린 정보를 확신으로 포장하는 심리적 함정. ChatGPT는 지식이 아닌 ‘확신’을 파는 엔진입니다. AI 도구 사용의 양날을 다룬 성찰.

Written by

AI가 긴 대시(—)를 남발하는 진짜 이유

AI가 긴 대시(—)를 과도하게 사용하는 이유를 추적합니다. GPT-4의 학습 데이터에 1800년대 후반 도서가 많이 포함되면서 그 시대 구두점 습관까지 배웠다는 흥미로운 가설을 소개합니다.

Written by

AI가 자신의 생각을 들여다본다: Claude의 내성 능력 발견

Claude AI가 자신의 내부 상태를 인식하고 보고하는 내성 능력을 가졌다는 Anthropic의 최신 연구. 개념 주입 실험으로 입증된 AI 투명성의 새로운 가능성을 소개합니다.

Written by

Google이 공개한 VaultGemma: 개인정보를 지키는 AI 모델 혁신

Google이 공개한 세계 최초의 차등 프라이버시 기반 언어 모델 VaultGemma의 기술적 혁신과 실용적 활용 방안을 소개합니다.

Written by

AI 환각이 사라지지 않는 진짜 이유 – OpenAI가 밝힌 구조적 원인

OpenAI 최신 연구를 통해 밝혀진 AI 환각의 구조적 원인과 평가 시스템 개선을 통한 해결책을 실무진 관점에서 분석한 인사이트 글

Written by

JSON으로 AI와 대화하는 법: 더 정확하고 효율적인 프롬프트 가이드

자연어 대신 JSON 구조로 AI와 소통하여 더 정확하고 일관된 결과를 얻는 방법을 실제 사례와 함께 알아봅니다. 이미지 생성, 웹 개발, 창작 등 다양한 분야에서의 활용법과 XML, YAML과의 비교, 실무 적용 가이드를 제공합니다.

Written by