고성능 AI를 쓰려면 큰 비용을 감수해야 한다는 고정관념이 있습니다. 하지만 중국 AI 기업 Zhipu AI가 내놓은 GLM-4.7 Flash는 이런 통념을 깨뜨립니다. 전체 358억 개의 파라미터 중 필요한 32억 개만 활성화하는 영리한 구조로, 상용 모델급 성능을 저비용으로 제공하는 오픈소스 모델이에요.

Analytics Vidhya가 GLM-4.7 Flash의 기술적 특징과 실전 활용법을 분석한 글을 발표했습니다. 이 모델은 Mixture-of-Experts(MoE) 아키텍처로 효율성을 극대화했으며, 코딩 보조부터 문서 요약까지 개발자 실무에 바로 쓸 수 있는 기능을 갖췄습니다. 특히 SWE-Bench에서 73.8%를 기록하며 실제 GitHub 이슈 해결 능력을 입증했죠.

출처: GLM-4.7 Flash: The AI Powerhouse Built for Developers – Analytics Vidhya

전문가 팀처럼 일하는 MoE 아키텍처

GLM-4.7 Flash의 핵심은 Mixture-of-Experts 구조입니다. 팀 프로젝트를 생각해보세요. 모든 팀원이 모든 작업에 투입되는 게 아니라, 각 작업에 가장 적합한 전문가만 참여하는 방식이죠. MoE 모델도 마찬가지입니다.

전체 모델에는 358억 개의 파라미터가 있지만, 특정 질문에는 약 32억 개만 활성화됩니다. Flash 버전은 더 경량화되어 총 30억 개 수준으로 작동해요. 이런 설계 덕분에 일반 하드웨어에서도 구동할 수 있으면서, 방대한 지식에 접근할 수 있습니다.

효율성의 의미는 단순히 “가볍다”가 아닙니다. 개발자 노트북에서도 돌릴 수 있고, API 비용도 상용 모델의 몇 분의 일 수준이라는 뜻이에요. Zhipu AI는 개발자들에게 무료로 제공하며, 유료 API도 경쟁사 대비 훨씬 저렴합니다.

코딩과 추론 능력의 대폭 강화

GLM-4.7 Flash는 단순 업그레이드가 아니라 개발자 워크플로우에 최적화된 모델입니다. 세 가지 핵심 개선사항이 있어요.

첫째, “Vibe Coding” 개념을 도입했습니다. 코드가 작동하기만 하면 되는 게 아니라, 포맷, 스타일, UI 외관까지 고려해 전문적으로 보이는 코드를 생성합니다. 대규모 코드 데이터셋으로 최적화한 결과, 더 큰 상용 모델과 비슷한 수준의 코딩 벤치마크를 기록했어요.

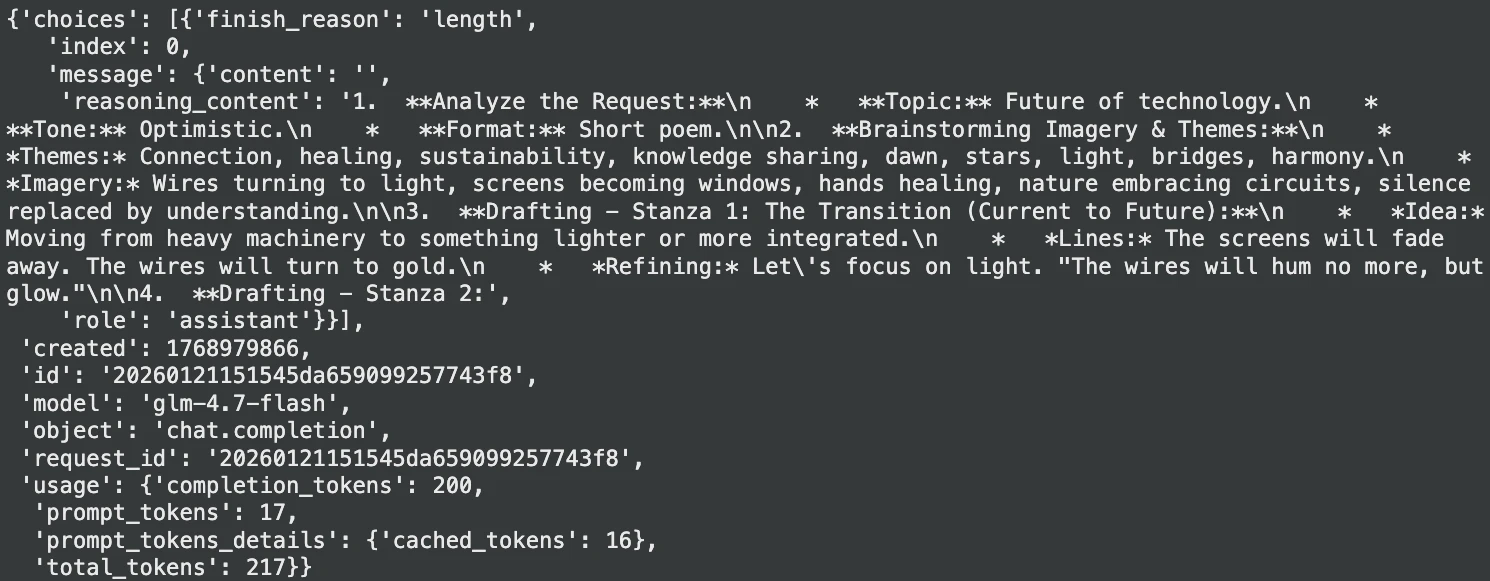

둘째, 다단계 추론이 강화됐습니다. 모델이 복잡한 지시사항을 받으면 바로 답하지 않고 먼저 “생각”합니다. 이 추론 과정은 여러 턴의 대화에 걸쳐 보존되므로, 긴 작업에서도 맥락을 잃지 않죠. 개발자는 각 쿼리마다 추론 깊이를 조절해 속도와 정확성 사이의 균형을 맞출 수 있습니다.

셋째, 20만 토큰이라는 방대한 컨텍스트 윈도우를 지원합니다. 긴 보고서를 요약하거나 대용량 로그 파일을 분석할 때 한 번에 처리할 수 있어요.

실제 성능은 어느 정도일까

벤치마크 수치는 현실과 다를 때가 많습니다. 하지만 GLM-4.7의 성적은 실무 능력을 보여주는 지표들입니다.

SWE-Bench Verified는 실제 GitHub 이슈를 해결하는 능력을 측정합니다. GLM-4.7은 73.8%를 기록하며 오픈소스 모델 중 상위권에 올랐어요. 알고리즘 추론과 문법 생성을 평가하는 LiveCodeBench-v6에서는 84.9%로 1위를 차지했죠.

수학 추론도 강력합니다. AI Math Exam(AIME)에서 95.7%를 달성했고, 까다로운 추론 벤치마크 HLE에서는 전작 대비 12% 향상됐습니다. 이 수치들은 GLM-4.7 Flash가 같은 급의 모델과 경쟁하는 게 아니라 종종 앞서간다는 걸 보여줍니다.

API 통합도 간편하게

기술이 아무리 뛰어나도 쓰기 어려우면 소용없습니다. GLM-4.7 Flash는 Z.AI API 플랫폼을 통해 OpenAI나 Anthropic과 유사한 인터페이스로 제공됩니다. REST 호출이든 SDK든 선택할 수 있어요.

예를 들어 창의적 텍스트를 생성하거나, 긴 문서를 요약하거나, 코딩 작업을 도울 때 몇 줄의 Python 코드만으로 시작할 수 있습니다. 공식 문서에는 cURL, Python, Java SDK 예제가 모두 준비되어 있어서 개발 환경에 바로 통합할 수 있죠.

더 나아가 오픈소스이기 때문에 로컬에 배포해 데이터 프라이버시를 지킬 수도 있고, 특정 도메인에 맞춰 파인튜닝할 수도 있습니다. 벤더 종속에서 벗어나 완전한 제어권을 가질 수 있어요.

개발자 중심 AI의 시작

GLM-4.7 Flash가 중요한 이유는 세 가지입니다.

첫째, 고성능을 저비용으로 제공합니다. 최고급 상용 모델과 경쟁할 만한 기능을 극히 일부 비용으로 쓸 수 있어요. 개인 개발자부터 스타트업, 대기업까지 모두에게 고급 AI가 열려 있습니다.

둘째, 오픈소스라는 점이 유연성을 보장합니다. 내부 데이터로 커스터마이징하고, 로컬 배포로 보안을 강화하며, 플랫폼 제약에서 자유로울 수 있죠.

셋째, 개발자 워크플로우를 이해한 설계입니다. OpenAI 호환 API, 내장 도구 지원, 턴별 추론 제어까지 실무에 바로 녹아드는 기능들로 채웠습니다. 복잡한 작업을 순차적으로 해결하는 능력 덕분에, 개발자는 구현 디테일보다 큰 그림에 집중할 수 있어요.

AI를 활용한 코딩 보조 도구는 이제 선택이 아니라 필수입니다. GLM-4.7 Flash는 그 문턱을 낮추면서도 성능은 타협하지 않았습니다. 다음 앱을 만들든, 복잡한 프로세스를 자동화하든, 더 똑똑한 코딩 파트너가 필요하든 이 모델은 실용적 선택지가 될 겁니다.

참고자료:

답글 남기기