Meta의 Llama 4는 개방형 AI 기술의 중요한 발전을 이루었습니다. 멀티모달 지원, Mixture-of-Experts 아키텍처, 그리고 놀라운 컨텍스트 윈도우 크기를 자랑하는 이 모델은 이제 다양한 방법으로 접근할 수 있게 되었습니다. 이 글에서는 Llama 4 모델에 액세스할 수 있는 여러 방법을 자세히 알아보겠습니다.

Llama 4의 주요 특징과 기능

Meta의 Llama 4 모델 패밀리: Behemoth, Maverick, Scout의 주요 특징과 아키텍처 소개

Llama 4는 다음과 같은 핵심 기능을 제공합니다:

- 네이티브 멀티모달리티 & 얼리 퓨전: 텍스트와 이미지를 함께 처리할 수 있으며, 프롬프트당 최대 5개의 이미지 입력 지원

- Mixture of Experts (MoE) 아키텍처: 각 입력을 전문 네트워크의 일부로 라우팅하여 효율성 향상

- Scout: 17B 활성 파라미터 / 109B 총 파라미터, 16 전문가

- Maverick: 17B 활성 파라미터 / 400B 총 파라미터, 128 전문가

- Behemoth: 288B 활성 파라미터 / ~2T 총 파라미터 (훈련 중)

Llama 4의 Mixture of Experts 아키텍처: 라우터와 전문가 네트워크 구성

- 확장된 컨텍스트 윈도우:

- Scout: 최대 1천만 토큰

- Maverick: 최대 100만 토큰

- 다국어 지원: 12개 언어 기본 지원, 200개 이상 언어에 대한 훈련 데이터

- 우수한 이미지 그라운딩: 텍스트를 특정 이미지 영역과 연결하여 정확한 시각적 추론 가능

Llama 4 모델 액세스 방법

1. Meta AI 플랫폼을 통한 접근

가장 간단한 방법은 Meta의 AI 플랫폼(meta.ai)을 사용하는 것입니다. 이 방법의 장점은 즉시 사용 가능하고 회원가입이 필요 없다는 점입니다. 하지만 API 액세스가 없고 커스터마이징 옵션이 제한적입니다.

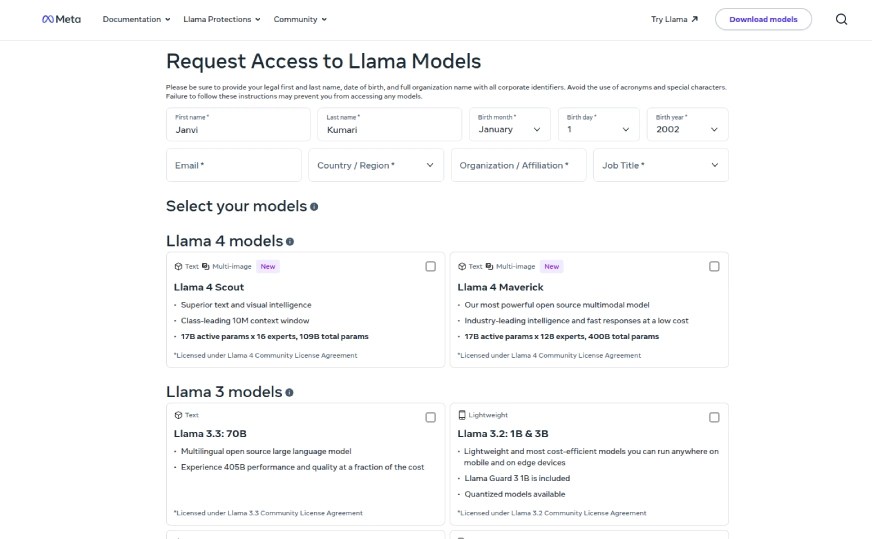

2. Llama.com에서 모델 가중치 다운로드

Llama.com에서 직접 모델 가중치를 다운로드할 수 있습니다. 요청 양식을 작성한 후 승인을 받으면 Llama 4 Scout와 Maverick에 액세스할 수 있습니다. 이 방법은 전체 모델 제어가 가능하지만 개발자에게 더 적합하며, 별도의 채팅 인터페이스는 제공되지 않습니다.

3. API 제공업체를 통한 액세스

여러 플랫폼에서 Llama 4 API 액세스를 제공하고 있습니다. 각 플랫폼별 장단점을 비교해 보겠습니다.

OpenRouter

OpenRouter.ai는 Llama 4 Scout와 Maverick 모델에 무료 API 액세스를 제공합니다. 가입 후 사용 가능한 모델을 탐색하고 API 키를 생성하여 바로 요청을 시작할 수 있습니다. 내장된 채팅 인터페이스도 제공하므로 애플리케이션에 통합하기 전에 응답을 테스트하기 쉽습니다.

OpenRouter 플랫폼을 통해 Llama 4 모델에 쉽게 액세스할 수 있습니다

Hugging Face

Hugging Face를 통한 Llama 4 액세스는 다음 단계로 이루어집니다:

- Hugging Face 계정 만들기: huggingface.co에서 계정 생성

- Llama 4 모델 저장소 찾기: Meta Llama 조직 또는 특정 Llama 4 모델 검색

- 모델 액세스 요청: “Request Access” 버튼을 클릭하고 필요한 정보 입력

- 승인 대기: Meta에서 요청을 검토하고 승인 (자동 승인 또는 몇 시간에서 며칠까지 소요)

- 프로그래밍 방식으로 모델 액세스: Hugging Face 토큰으로 인증한 후 모델 사용

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "meta-llama/Llama-4-Scout-17B-16E-Instruct" # 선택한 모델로 변경

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(model_name)

# 추론

input_text = "대한민국의 수도는 어디인가요?"

input_ids = tokenizer.encode(input_text, return_tensors="pt")

output = model.generate(input_ids, max_length=50, num_return_sequences=1)

print(tokenizer.decode(output[0], skip_special_tokens=True))

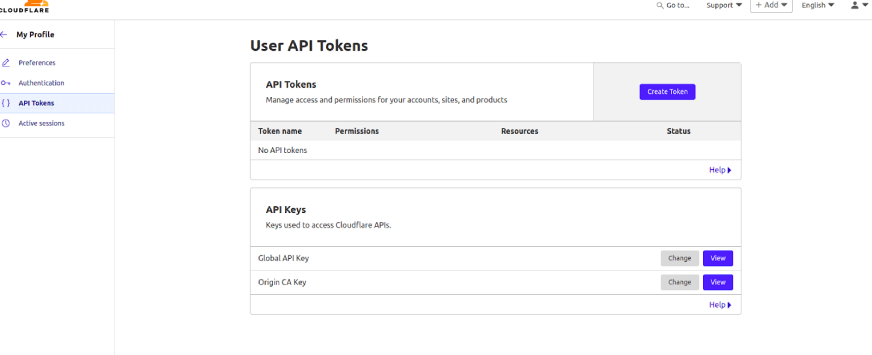

Cloudflare Workers AI

Cloudflare는 Workers AI 플랫폼을 통해 Llama 4 Scout를 서버리스 API로 제공합니다. 최소한의 설정으로 API 호출을 통해 모델을 호출할 수 있으며, 테스트를 위한 AI 플레이그라운드도 제공됩니다. 계정 없이도 기본 액세스를 시작할 수 있어 가벼운 실험에 이상적입니다.

Snowflake Cortex AI

Snowflake 사용자의 경우, Cortex AI 환경 내에서 Scout와 Maverick에 액세스할 수 있습니다. SQL 또는 REST API를 통해 이러한 모델을 사용할 수 있어 기존 데이터 파이프라인과 분석 워크플로우에 원활하게 통합할 수 있습니다.

Amazon SageMaker JumpStart 및 Bedrock

Llama 4는 Amazon SageMaker JumpStart에 통합되어 있으며, Bedrock에서도 추가로 사용할 수 있습니다. SageMaker 콘솔을 통해 모델을 쉽게 배포하고 관리할 수 있습니다. AWS에서 이미 구축 중이고 클라우드 네이티브 솔루션에 LLM을 임베드하려는 경우에 특히 유용합니다.

#Chat 또는 API 호출을 통해 사용할 수 있으며, 가입 시 무료 액세스를 제공하고 유료 티어는 더 높은 한도를 제공하므로 탐색과 프로덕션으로의 확장 모두에 적합합니다.

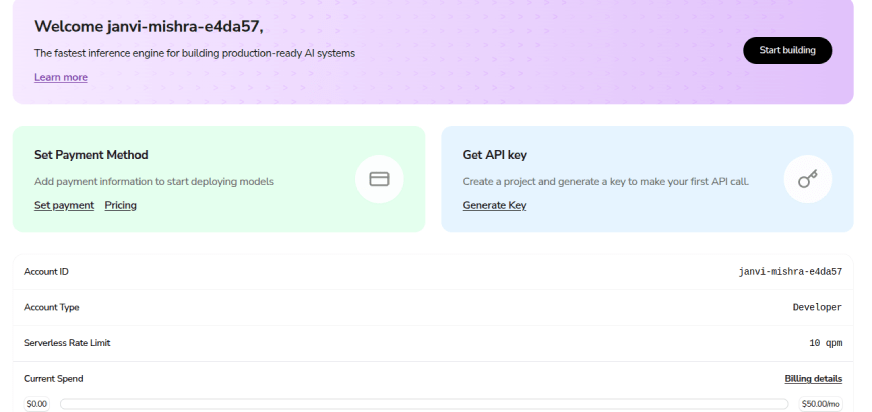

Together AI

Together AI는 간단한 등록 과정 후 Scout와 Maverick에 대한 API 액세스를 제공합니다. 새 사용자 가입 시 무료 크레딧을 받고 발급된 키로 API를 즉시 사용 시작할 수 있습니다. 개발자 친화적이며 고성능 추론을 제공합니다.

Together AI 플랫폼에서는 가입 즉시 Llama 4 API를 사용할 수 있는 무료 크레딧을 제공합니다

Replicate

Replicate는 API를 통해 실행할 수 있는 Llama 4 Maverick Instruct를 호스팅합니다. 토큰 사용량 기반 가격 책정으로 사용한 만큼만 지불하므로, 선행 인프라 비용 없이 실험하거나 가벼운 애플리케이션을 구축하려는 개발자에게 좋은 선택입니다.

Fireworks AI

Fireworks AI도 서버리스 API를 통해 Llama 4 Maverick Instruct를 제공합니다. 개발자는 Fireworks의 문서를 따라 빠르게 설정하고 응답 생성을 시작할 수 있습니다. 서버를 관리하지 않고 LLM을 대규모로 실행하려는 사용자에게 적합한 솔루션입니다.

Llama 4 액세스 플랫폼 비교표

| 플랫폼 | 사용 가능한 모델 | 액세스 방법 | 주요 특징/참고사항 |

|---|---|---|---|

| Meta AI | Scout, Maverick | 웹 인터페이스 | 즉시 액세스, 회원가입 불필요, 제한된 커스터마이징, API 액세스 없음 |

| Llama.com | Scout, Maverick | 다운로드 | 승인 필요, 전체 모델 가중치 액세스, 로컬/클라우드 배포에 적합 |

| OpenRouter | Scout, Maverick | API, 웹 인터페이스 | 무료 API 액세스, 대기 목록 없음, 속도 제한 적용 가능 |

| Hugging Face | Scout, Maverick | API, 다운로드 | 제한된 액세스 양식, 추론 API, 가중치 다운로드, 개발자용 |

| Cloudflare Workers AI | Scout | API, 웹 인터페이스(플레이그라운드) | 서버리스, 인프라 처리, API 요청 |

| Snowflake Cortex AI | Scout, Maverick | SQL 함수, REST API | Snowflake 내에서 통합 액세스, 엔터프라이즈 애플리케이션용 |

| Amazon SageMaker JumpStart | Scout, Maverick | 콘솔 | 현재 사용 가능 |

| Amazon Bedrock | Scout, Maverick | 곧 출시 예정 | 완전 관리형, 서버리스 옵션 |

| GroqCloud | Scout, Maverick | API, 웹 인터페이스(GroqChat, 콘솔) | 가입 시 무료 액세스, 확장을 위한 유료 티어 |

| Together AI | Scout, Maverick | API | 계정 및 API 키 필요, 신규 사용자 무료 크레딧 |

| Replicate | Maverick Instruct | API | 토큰 단위로 가격 책정 |

| Fireworks AI | Maverick Instruct(기본) | API, 온디맨드 배포 | 자세한 액세스 지침은 공식 문서 참조 |

API를 통한 Llama 4 사용 예제

사전 요구 사항

API를 통해 Llama 4를 사용하려면 다음이 필요합니다:

- 선택한 플랫폼의 계정(예: GroqCloud)

- API 키

- 적절한 SDK 또는 API 호출 방법

예제: GroqCloud를 사용한 Llama 4 모델 테스트

import os

from groq import Groq

# API 키 설정

os.environ["GROQ_API_KEY"] = "your_api_key_here"

# 클라이언트 초기화

client = Groq(api_key=os.environ.get("GROQ_API_KEY"))

# 1. 긴 문서 요약

long_document_text = """긴 문서 내용을 여기에 입력하세요..."""

prompt_summary = f"다음 문서의 간결한 요약을 제공해주세요:\n\n{long_document_text}"

# Scout 모델 사용

summary_scout = client.chat.completions.create(

model="meta-llama/llama-4-scout-17b-16e-instruct",

messages=[{"role": "user", "content": prompt_summary}],

max_tokens=500

).choices[0].message.content

print("요약 (Scout):\n", summary_scout)

# Maverick 모델 사용

summary_maverick = client.chat.completions.create(

model="meta-llama/llama-4-maverick-17b-128e-instruct",

messages=[{"role": "user", "content": prompt_summary}],

max_tokens=500

).choices[0].message.content

print("\n요약 (Maverick):\n", summary_maverick)

멀티모달 기능 테스트

Llama 4의 이미지 이해 기능을 테스트하는 코드입니다:

image_url = "https://example.com/image.jpg"

prompt_image = "이 이미지의 내용을 자세히 설명해주세요."

# Scout 모델로 이미지 설명 생성

description_scout = client.chat.completions.create(

model="meta-llama/llama-4-scout-17b-16e-instruct",

messages=[

{

"role": "user",

"content": [

{"type": "text", "text": prompt_image},

{"type": "image_url", "image_url": {"url": image_url}}

]

}

],

max_tokens=150

).choices[0].message.content

print("이미지 설명 (Scout):\n", description_scout)

Scout vs. Maverick: 어떤 모델을 선택해야 할까요?

Llama 4 Scout와 Maverick는 각각 다른 용도에 최적화되어 있습니다:

Llama 4 Scout는 다음에 적합합니다:

- 다중 문서 요약 및 법률/재무 분석

- 사용자 데이터를 활용한 개인화된 작업 자동화

- 멀티모달 애플리케이션을 위한 효율적인 이미지 파싱

- 예산이 제한된 프로젝트(단일 H100 GPU에 맞음)

- 매우 긴 컨텍스트가 필요한 작업(최대 1천만 토큰)

Llama 4 Maverick는 다음에 적합합니다:

- 시각적 컨텍스트가 있는 다국어 고객 지원

- 멀티모달 PDF에서 마케팅 콘텐츠 생성

- 텍스트, 다이어그램, 표가 포함된 고급 문서 인텔리전스

- 코드 생성 및 기술 작업

- 고품질 이미지 설명 및 분석

작업별 성능 비교

| 작업 | Llama 4 Scout | Llama 4 Maverick |

|---|---|---|

| 긴 문서 요약 | 우승: 10M 토큰 컨텍스트 윈도우로 긴 텍스트를 쉽게 처리 | 차선: 1M 토큰 컨텍스트 윈도우가 장거리 의존성 유지 능력 제한 |

| 코드 생성 | 차선: 기능적인 코드 생성하지만 기술적 워크플로우에 필요한 미묘한 로직이나 모범 사례가 부족할 수 있음 | 우승: 개발 작업에 특화되어 사용자 의도에 맞는 정확하고 효율적인 코드 일관되게 제공 |

| 이미지 이해(멀티모달) | 유능: 이미지 입력을 처리하고 올바르게 응답하지만, 섬세한 시각-텍스트 연결이 필요한 시나리오에서는 일반적인 출력 | 우승: 네이티브 멀티모달 모델로서 이미지 이해에 탁월하며, 생생하고 세부적이며 맥락이 풍부한 설명 생성 |

두 모델 모두 인상적인 기능을 제공하지만 다른 영역에서 빛을 발합니다. Scout는 확장된 컨텍스트 윈도우 덕분에 긴 형식의 콘텐츠 처리에 탁월하며, 요약 및 빠른 상호 작용에 이상적입니다. 반면 Maverick는 기술적 작업과 멀티모달 추론에서 두각을 나타내며 코드 생성 및 이미지 해석에서 더 높은 정확도를 제공합니다.

결론

Llama 4는 AI 발전의 중요한 단계를 나타냅니다. 강력한 기능을 갖춘 최고의 멀티모달 모델로서, 텍스트와 이미지를 기본적으로 처리할 수 있습니다. MoE 설정은 효율적이며, 긴 컨텍스트 윈도우를 지원합니다. 이는 강력하고 유연한 모델을 만듭니다. Llama 4는 오픈 소스이며 널리 접근 가능하여 혁신과 광범위한 채택을 촉진합니다. 구체적인 사용 사례와 요구 사항에 따라 Scout 또는 Maverick 중 하나를 선택할 수 있으며, 다양한 API 공급자를 통해 이러한 최첨단 모델에 액세스할 수 있습니다.

답글 남기기