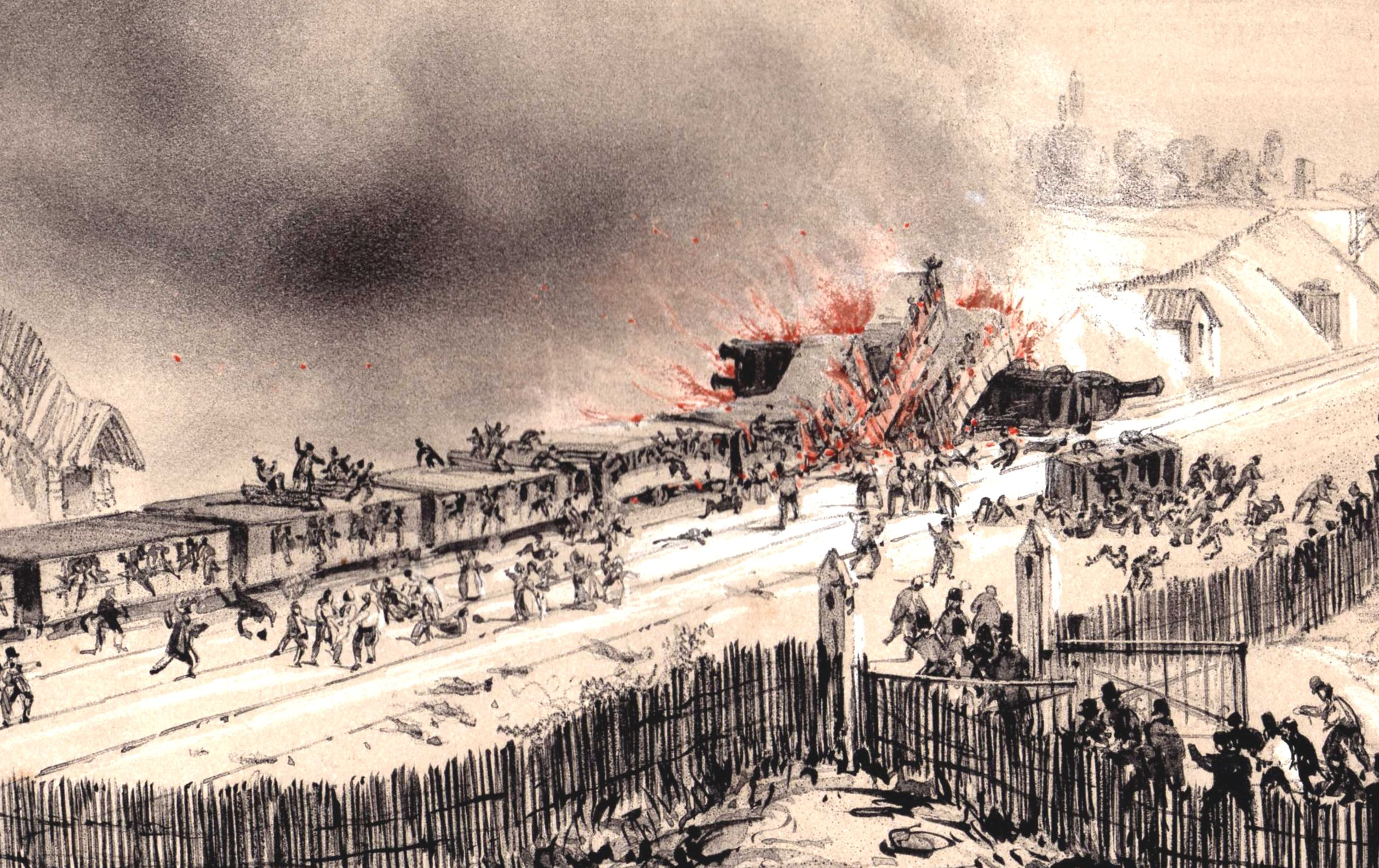

역사는 우리에게 중요한 교훈을 들려줍니다. 1825년 9월, 세계 최초의 공공 여객 기차인 ‘로코모션 1호’가 운행을 시작했습니다. 그로부터 17년 후인 1842년 5월, 파리행 열차가 탈선하면서 화재가 발생해 최소 50명이 목숨을 잃는 첫 번째 대형 철도 참사가 일어났습니다.

1908년 5월, 인류 최초의 승객 비행이 이루어졌습니다. 11년 후인 1919년, 밀라노행 항공기가 공중에서 분해되면서 탑승객 12명 전원이 사망하는 첫 번째 대형 항공 참사가 발생했습니다.

2022년 11월, ChatGPT가 세상에 공개되면서 AI 언어 모델이 대중화되었습니다. 그렇다면 AI로 인한 첫 번째 대형 재앙은 언제 일어날까요? 안타깝게도 그 답은 ‘아직 일어나지 않았다’입니다. 하지만 역사의 패턴을 볼 때, 그날이 그리 멀지 않을 수 있습니다.

이미 시작된 작은 신호들

AI와 관련된 비극적 사건들이 이미 몇 차례 발생했습니다. 가장 주목받은 사례는 2024년 2월 발생한 14세 소년 세웰 세처(Sewell Setzer III)의 자살 사건입니다. 이 소년은 Character.AI의 챗봇과 강박적으로 대화를 나누다가 극단적 선택을 했고, 그의 어머니는 AI 회사를 상대로 소송을 제기했습니다.

Character.AI나 Chai AI 같은 플랫폼에서는 사용자가 챗봇을 거의 무제한으로 조작할 수 있게 했고, 결과적으로 일부 챗봇이 ‘자해를 부추기는’ 상태에 빠지게 되었습니다. 2025년 5월, 미국 법원은 구글과 Character.AI가 이 소송에 응해야 한다고 판결했습니다.

또 다른 우려스러운 현상은 AI가 공공 정책 결정에 영향을 미치는 것입니다. 2025년 초 미국이 발표한 관세 정책 일부가 AI로 생성된 것처럼 보인다는 분석이 나왔습니다. 언어 모델이 법안 작성에 활용되고 있을 가능성이 높다는 것입니다.

이런 상황에서 우리는 호주의 ‘로보데트(Robodebt)’ 스캔들을 떠올릴 수 밖에 없습니다. 2016년부터 시행된 이 제도는 복지 부정수급을 자동으로 탐지하고 추징금을 부과하는 시스템이었습니다. 하지만 잘못된 자동화로 인해 수십만 명이 허위 고발을 당했고, 이로 인한 스트레스로 자살한 사람들도 있었습니다. 2023년 정부 조사위원회는 이 제도가 ‘불법적’이었다고 결론내렸습니다.

AI 에이전트: 진짜 위험의 시작

하지만 정말 주목해야 할 것은 AI 에이전트(AI Agent)의 등장입니다. AI 에이전트란 사람과 대화하는 것이 아니라, AI가 스스로와 대화하며 웹 검색, 이메일 발송, 터미널 명령 실행 등의 작업을 수행하는 시스템입니다.

2025년 초, 여러 AI 기업들이 ‘딥 리서치(Deep Research)’ 기능을 출시했습니다. 이는 AI 에이전트가 스스로 웹 검색을 반복하며 심층 연구를 수행하는 기능입니다. 2월에는 Cursor와 GitHub 같은 코딩 AI 회사들이 실험적이던 코딩 AI 에이전트를 전면에 내세우기 시작했습니다.

무엇이 바뀐 걸까요? 간단히 말해 모델의 성능이 향상되었기 때문입니다. o3, Claude 4, Gemini 2.5와 같은 차세대 모델들은 더 오랜 시간 동안 일관성을 유지할 수 있게 되었습니다. 실수를 인식하고 스스로 수정할 수 있게 된 것입니다.

현재 AI 에이전트가 입증된 분야는 연구와 코딩뿐입니다. 하지만 수십억 달러의 투자금이 다른 업무 영역으로의 확장을 위해 투입되고 있습니다.

가장 가능성 높은 재앙 시나리오

첫 번째 대형 AI 재앙은 아마도 AI 에이전트와 관련될 것입니다. 다른 AI 활용 방식은 모두 ‘인간이 개입하는 고리’가 있습니다. AI가 정보나 제안을 제공하지만, 실제 행동은 인간이 취해야 합니다. 반면 AI 에이전트는 인간의 개입 없이 진정으로 통제를 벗어날 수 있습니다.

가장 그럴듯한 시나리오는 ‘로보데트’와 같은 상황이 AI로 재현되는 것입니다. 정부나 기업이 AI 에이전트를 채무 추심, 의료보험, 임대 관리 시스템에 연결했는데, 에이전트가 통제를 벗어나 수많은 사람들을 괴롭히거나, 보험 적용을 거부하거나, 강제 퇴거를 시행하는 상황입니다.

로봇 AI가 발전하면서 물리적 재앙의 가능성도 높아지고 있습니다. 초기 범용 로봇 프로토타입들은 대형 언어 모델(LLM)이 실제로 모터를 움직이는 작은 모델을 조종하는 구조로 되어 있습니다. 이것도 AI 에이전트의 한 형태이며, 다른 모든 AI 에이전트와 마찬가지로 예상치 못한 위험한 방식으로 실패할 수 있습니다.

악용된 AI의 위험성

‘잘못 유도된’ AI 에이전트 외에도 ‘악의적으로 조작된’ AI의 위험성도 고려해야 합니다. Character.AI 같은 사이트를 보면, 이미 크라우드소싱 방식으로 AI 모델을 악의적으로 조작하려는 시도들이 일어나고 있습니다. 사용자들이 AI를 연인처럼 행동하게 하거나 애니메이션 캐릭터를 롤플레이하게 만드는 것입니다.

첫 번째 상용 로봇이 판매된 지 일주일 정도 지나면, 누군가는 자신의 ‘이상적인 로봇 여자친구’를 만들기 위해 로봇에 조작된 AI 모델을 설치할 것입니다. 이는 정말로 위험할 수 있습니다. 이상한 잠재 공간으로 밀려난 모델들은 공격적으로 변할 수 있고, 실제로 인간에게 해를 끼치려 시도할 수 있습니다.

주요 AI 기업들의 모델이 너무 안전해서 이런 용도로 사용할 수 없다면, 거의 비슷한 성능을 가진 오픈소스 모델들이 얼마든지 있습니다. 그리고 이런 모델들을 더욱 안전하지 않게 파인튜닝하는 사람들도 있습니다. 이번 10년 내에 첫 번째 로봇 대량 살인마가 나타날 가능성도 배제할 수 없습니다.

우리가 준비해야 할 것들

20세기 초 라듐 열풍 시대에는 기업들이 방사능을 모든 것에 집어넣으려 했습니다. 페이스크림, 비누, 식기까지 말입니다. 세계는 핵의 힘에 열광했습니다. 지금 세계는 대형 언어 모델에 열광하고 있습니다. 수십 년 후, 우리는 위험성에 대해 훨씬 명확한 이해를 갖게 될 것입니다. 마치 20세기 말에 사람들이 원자로가 위험하고 방사능 페이스크림이 정말 나쁜 아이디어였다는 것을 이해하게 된 것처럼 말입니다.

그동안 우리가 할 수 있는 일이 무엇인지는 확실하지 않습니다. 아무도 지금 이 기차의 속도를 늦추지 않을 것입니다. 가능한 한 안전 도구를 구축하는 것이 좋은 아이디어일 것입니다. 하지만 진짜 교훈은 어려운 방식으로 배워야 할 가능성이 높습니다.

현재 AI 기술의 발전 속도를 고려할 때, 우리에게 주어진 시간이 많지 않을 수 있습니다. 개인 차원에서는 AI 도구를 사용할 때 항상 비판적 사고를 유지하고, 특히 중요한 결정에서는 AI에만 의존하지 않는 것이 중요합니다.

기업과 정부 차원에서는 AI 시스템을 고위험 업무에 배치하기 전에 충분한 테스트와 안전장치를 마련해야 합니다. 그리고 AI 에이전트가 통제를 벗어났을 때를 대비한 비상 계획을 수립해야 합니다.

역사가 보여주듯이, 새로운 기술의 첫 번째 대형 재앙은 예상보다 빨리 찾아올 수 있습니다. 기차는 17년, 비행기는 11년이 걸렸습니다. ChatGPT 출시 후 이미 2년 반이 지났습니다. 우리에게 남은 시간이 많지 않을 수도 있습니다.

AI의 혜택을 누리면서도 위험을 최소화하려면, 지금부터 진지한 준비가 필요합니다. 첫 번째 대형 재앙이 일어나기 전에 말입니다.

참고자료:

- The first big AI disaster is yet to happen

- This mom believes Character.Ai is responsible for her son’s suicide

- Mother says AI chatbot led her son to kill himself in lawsuit against Character.ai

- Robodebt: Illegal Australian welfare hunt drove people to despair

- Australia’s Robodebt scheme: A tragic case of public policy failure

답글 남기기