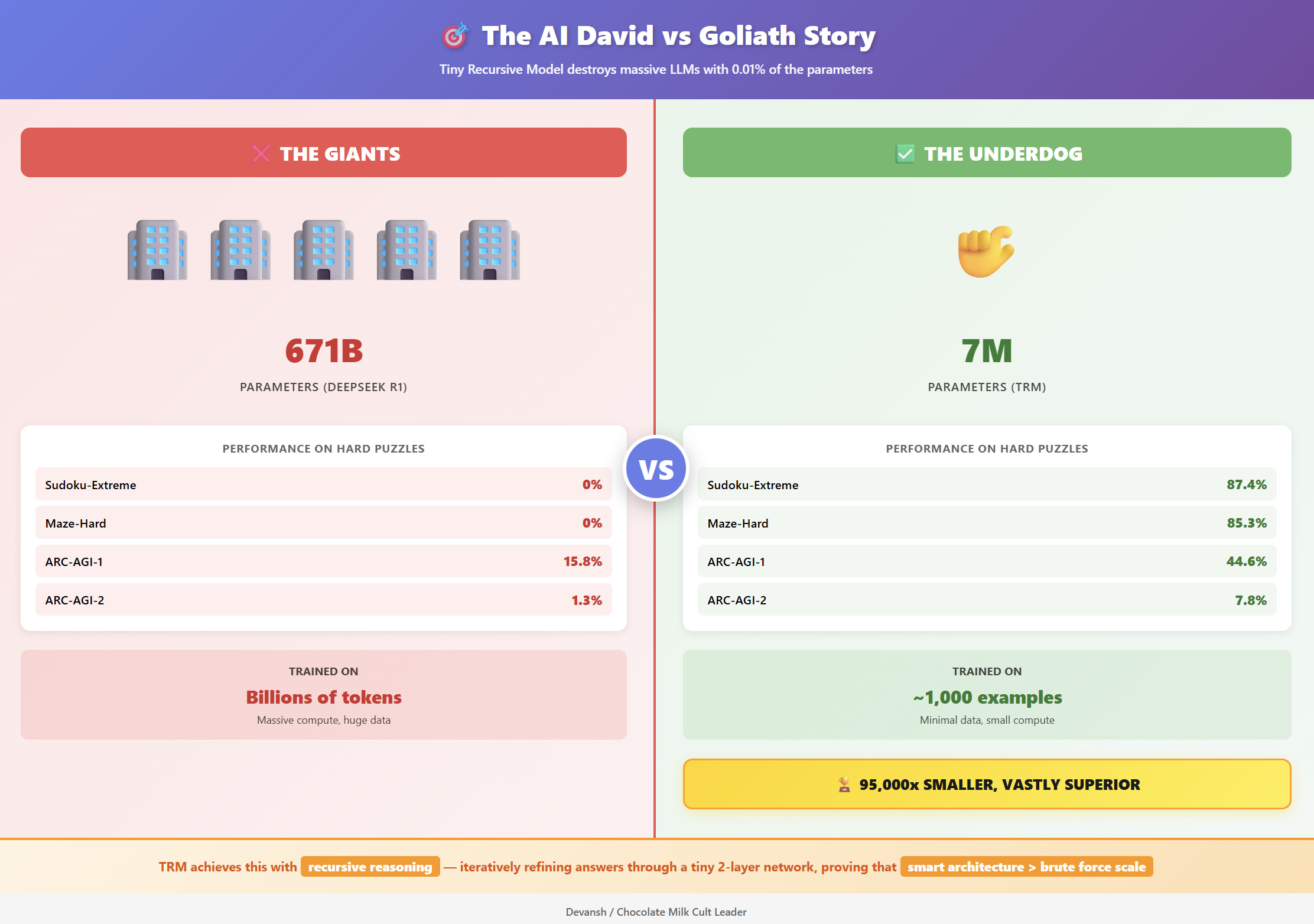

AI가 똑똑해지려면 모델이 커져야 한다는 건 상식이었습니다. 그런데 삼성이 개발한 단 700만 파라미터의 작은 모델이 GPT, Claude 같은 거대 언어모델을 복잡한 추론 문제에서 압도했습니다.

한 번 선택하면 끝, LLM의 약점

GPT나 Claude는 한 번에 한 토큰씩 답을 생성합니다. 문제는 한 번 선택하면 되돌릴 수 없다는 거예요. 스도쿠를 풀다가 초반에 잘못 넣은 숫자 하나가 나중에 전체 퍼즐을 망가뜨리는 것처럼, LLM도 초기 실수를 수정할 방법이 없습니다. 이런 구조적 한계 때문에 논리 퍼즐이나 수학 증명 같은 다단계 추론에서 거대 모델도 자주 실패하죠.

생각을 반복하는 AI

삼성의 Tiny Recursive Model(TRM)은 답을 한 번에 내놓지 않습니다. 여러 번 검토하고 수정해요. 현재 답(y)과 내부 추론 과정(z)을 분리해서 관리하면서, 답안지에는 답을 쓰면서도 머릿속으로는 계속 “이게 맞나?”를 생각하는 사람처럼 작동합니다.

내부 추론을 6~7번 반복해 생각을 다듬고, 그다음 답을 업데이트하는 과정을 최대 16번까지 반복하며 정답에 근접해갑니다.

TRM의 비밀은 암기가 아닌 절차 학습입니다. 단 2개의 트랜스포머 층만 사용해서 모든 패턴을 외울 수 없게 만들었어요. 대신 “제약 조건 전파하기”, “충돌 수정하기” 같은 재사용 가능한 규칙을 학습합니다. 이 작은 네트워크를 21번 반복하면 실질적으로 42개 층의 깊이를 갖지만, 외울 수 있는 파라미터는 2개 층 분량뿐이죠.

결과는 놀랍습니다. ARC-AGI 테스트에서 TRM은 Deepseek R1, o3-mini, Gemini 2.5 Pro보다 높은 정확도를 기록했는데, 파라미터는 0.01%도 안 됩니다. 극한 난이도 스도쿠에서는 87.4%의 정확도를 달성했어요.

크기가 아닌 알고리즘의 시대

TRM은 AI 산업에 중요한 변화를 예고합니다. 하드웨어 시장은 거대 행렬 연산보다 빠른 반복 연산에 최적화된 칩을 필요로 하게 될 거예요. 연구는 “더 큰 모델”에서 “더 나은 추론 루프”로 방향을 바꿀 겁니다. 투자는 데이터센터 확장보다 효율적인 알고리즘 개발로 이동하겠죠.

물론 한계도 있습니다. TRM은 규칙이 명확한 퍼즐에는 강하지만 개방형 질문에는 약해요. 반복 사고 때문에 추론 속도도 느리고, (문제, 정답) 쌍이 필요한 지도 학습에 의존합니다.

하지만 TRM이 증명한 핵심은 명확합니다. 거대 언어모델이 ‘기억의 아키텍처’라면 TRM은 ‘계산의 아키텍처’예요. 앞으로 AI 시스템은 둘을 결합할 겁니다. 거대 모델이 지식을 제공하면, 작은 재귀 모델이 정밀한 추론을 수행하는 구조죠.

AI의 다음 시대는 “얼마나 많이 아는가”가 아니라 “얼마나 우아하게 생각을 바꿀 수 있는가”로 정의될 겁니다.

참고자료:

답글 남기기