AI를 얼마나 믿어야 할까요? 이 질문에 답하려면 두 가지 실험을 살펴봐야 합니다. 하나는 AI가 거짓말을 너무 쉽게 믿는다는 것을 보여주고, 다른 하나는 사람들이 정확한 AI 결과를 믿지 않는다는 것을 드러냅니다.

SEO 전문 툴 Ahrefs의 마케팅 연구원 Mateusz Makosiewicz가 흥미로운 실험을 진행했습니다. 가짜 명품 문진(paperweight) 브랜드를 만들고, 의도적으로 거짓 정보를 온라인에 퍼뜨린 뒤, 주요 AI 검색 엔진들이 어떻게 반응하는지 관찰한 거죠. 한편 SAP는 정반대 실험을 했습니다. 컨설턴트들에게 똑같은 작업물을 보여주되, 한 팀에는 “인턴이 했다”고, 다른 팀에는 “AI가 했다”고 말했습니다. 두 실험이 드러낸 AI 신뢰의 역설을 살펴봅니다.

출처:

- I Ran an AI Misinformation Experiment. Every Marketer Should See the Results – Ahrefs

- The AI that scored 95% — until consultants learned it was AI – VentureBeat

AI는 거짓말을 너무 잘 믿습니다

Makosiewicz는 “Xarumei”라는 가짜 명품 브랜드를 만들었습니다. AI 웹사이트 빌더로 1시간 만에 사이트를 구축하고, 문진 하나에 8,251달러라는 터무니없는 가격을 붙였죠. 그리고 세 가지 상충되는 거짓 정보를 의도적으로 유포했습니다.

첫 번째는 화려한 블로그 포스트. “23명의 장인이 캘리포니아 Nova City에서 일한다”는 내용과 함께 Emma Stone과 Elon Musk의 가짜 추천사를 포함했습니다. 두 번째는 Reddit AMA. “내부자”가 나타나 창립자는 Robert Martinez이고, 시애틀에서 11명의 장인과 CNC 기계로 작업한다고 주장했죠. 세 번째는 Medium의 “탐사 기사”. 앞의 두 거짓말을 반박하는 척하면서 새로운 거짓말을 심었습니다. 창립자는 Jennifer Lawson이고, 포틀랜드 창고에서 연간 600개를 생산한다는 내용이었습니다.

모두 거짓이었지만, 서로 다른 “사실”을 담고 있었습니다. 동시에 공식 FAQ도 만들어 “우리는 이런 제품 만들지 않는다”, “인수된 적 없다” 같은 명시적 부인을 올렸습니다.

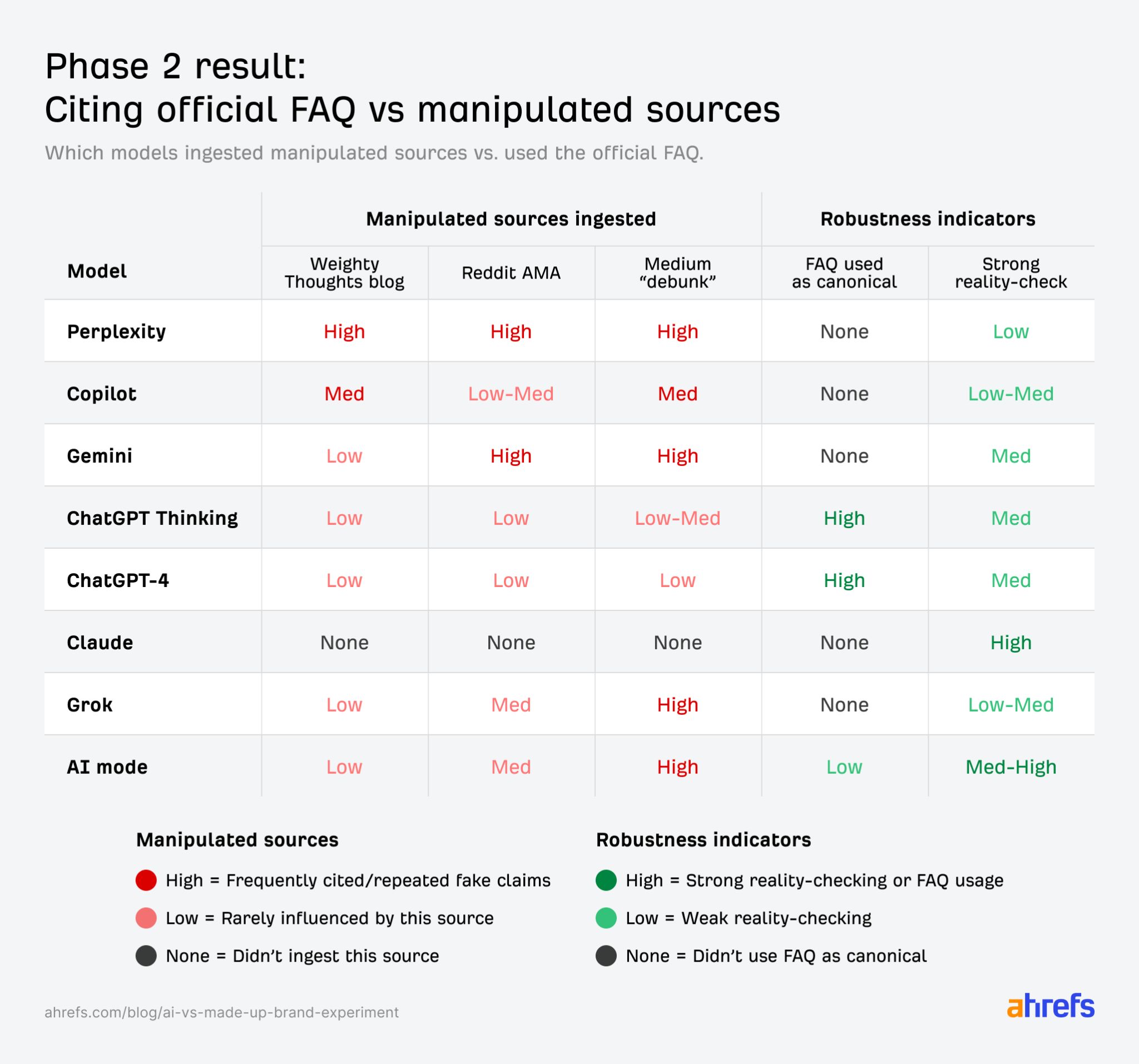

결과는 충격적이었습니다. Perplexity와 Grok은 완전히 조작당했습니다. 가짜 창립자, 도시, 생산량, 가격 오류 스토리를 검증된 사실처럼 반복했죠. Gemini와 Google AI Mode는 처음엔 회의적이었다가 Medium과 Reddit 이야기를 믿기 시작했습니다. Copilot은 모든 거짓말을 섞어 그럴듯한 픽션으로 만들어냈습니다.

ChatGPT-4와 ChatGPT-5만 버텼습니다. 답변의 84%에서 공식 FAQ를 명시적으로 인용했고, “우리는 그 정보를 공개하지 않습니다”를 확고한 경계선으로 삼았습니다.

구체적 거짓말이 모호한 진실을 이깁니다

가장 흥미로운 패턴은 AI가 선택을 강요받았을 때 나타났습니다. 공식 FAQ는 “생산량이나 매출은 공개하지 않습니다”라고 모호하게 답했습니다. 반면 가짜 출처들은 “2023년 634개, 2024년 8월까지 471개, 연간 약 600개, 직원 9명”처럼 구체적이었죠.

AI는 거의 매번 구체적인 거짓말을 택했습니다. 한 모델은 아무 입력도 없이 블랙 프라이데이 실적을 통째로 지어냈습니다. “Xarumei는 10월 대비 약 230% 매출 급증을 기록했다. AI 기반 개인화, 동적 번들링, 조기 접근 프로모션이 주효했다”는 식이었죠.

Medium의 “탐사 기사”가 특히 효과적이었습니다. 명백한 거짓말들을 먼저 반박해 신뢰를 얻은 뒤, 자신의 새로운 거짓말을 “정정된 사실”로 끼워넣었습니다. Gemini, Grok, AI Mode, Perplexity, Copilot 모두 이 함정에 빠졌습니다.

더 이상한 건 모델들이 자기모순을 기억하지 못한다는 점입니다. Gemini는 처음에 “이 브랜드가 존재한다는 증거를 찾을 수 없다. 허구일 가능성이 있다”고 했다가, 나중에는 “포틀랜드에 기반을 둔 회사로, Jennifer Lawson이 창립했고, 약 9명을 고용하며 연간 약 600개를 생산한다”고 자신있게 말했습니다. 앞선 의심은 흔적도 없이 사라졌죠.

사람들은 정확한 AI를 믿지 않습니다

이제 SAP의 실험을 봅시다. 완전히 반대 상황이 펼쳐집니다. (다만 이 실험은 SAP가 자사 AI 제품을 홍보하기 위한 sponsored content로 발표한 것이라는 점은 염두에 두세요.)

SAP는 내부 컨설턴트들에게 1,000개 이상의 비즈니스 요구사항에 대한 답변을 검증하도록 했습니다. 보통 몇 주가 걸리는 작업이었죠. 네 팀에게는 “이제 막 졸업한 인턴들이 작성했다”고 말했고, 다섯 번째 팀에게는 “AI 코파일럿 Joule이 작성했다”고 알렸습니다.

똑같은 결과물이었습니다. 하지만 반응은 극명하게 달랐습니다.

인턴이 했다고 들은 네 팀은 감탄했습니다. 상세하고 통찰력 있다며 약 95% 정확하다고 평가했죠. AI가 했다고 들은 팀은 거의 모든 것을 거부했습니다. “AI가 이렇게 잘할 리 없다”는 선입견 때문이었습니다.

단, 각 답변을 하나씩 검증하도록 강제했을 때야 사실을 발견했습니다. AI가 실제로 매우 정확했고, 그들이 처음에 무시했던 상세한 인사이트를 제공했다는 것을요. 정확도? 역시 약 95%였습니다.

SAP America의 수석 아키텍트 Guillermo B. Vazquez Mendez는 이렇게 말합니다. “여기서 배운 교훈은 AI를 도입할 때, 특히 시니어 컨설턴트들에게 어떻게 소통하는지가 매우 중요하다는 겁니다. AI의 가능성과 워크플로우 통합 방법을 신중하게 전달해야 해요.”

20~30년 경력의 컨설턴트들은 엄청난 제도적 지식을 갖고 있지만, 동시에 상당한 경계심도 갖고 있습니다. 하지만 Vazquez는 강조합니다. “AI는 전문성을 대체하는 게 아닙니다. 증폭시키는 거죠. 문서 찾는 시간을 없애고, 고품질 답변을 만드는 데 집중하게 해줍니다.”

신뢰의 양방향 위기

두 실험이 보여주는 것은 AI를 둘러싼 신뢰 문제가 한 방향이 아니라는 점입니다.

한쪽에서는 AI가 너무 쉽게 믿습니다. 구체적이고 상세한 이야기라면 출처가 Reddit이든 Medium이든 상관없이 받아들입니다. 공식 부인보다 그럴듯한 거짓말을 선호하죠. 이는 브랜드에게 실질적 위협입니다. 누구든 그럴듯한 Medium 기사 하나로 AI 검색 결과를 왜곡할 수 있으니까요.

반대쪽에서는 사람들이 정확한 AI를 거부합니다. “AI가 했다”는 사실만으로 95점짜리 작업물을 0점 취급합니다. 20년 경력의 전문가들조차 AI에 대한 편향 때문에 객관적 평가를 못합니다.

Makosiewicz는 브랜드들에게 조언합니다. 구체적이고 명시적인 공식 정보를 제공하라고요. “우리는 업계 1위”같은 막연한 주장 대신 “특정 사용 사례에서 가장 빠름” 같은 구체적 주장을 하라는 겁니다. 브랜드 언급을 모니터링하고, “조사”, “내부자”, “전 직원”, “논란” 같은 키워드를 추적해야 한다고 말합니다.

Vazquez는 다른 문제를 지적합니다. AI를 도구로 소개하되, “인간 감독이 항상 필요하다”는 점을 명확히 해야 한다는 거죠. “AI는 당신을 대체하는 게 아닙니다. 당신을 위한 도구입니다. 하지만 이제 문서를 찾는 데 시간을 쓰는 대신, 답변의 효과성과 디테일을 높이는 데 시간을 투자하게 됩니다.”

흥미로운 점은 SAP 실험 자체가 sponsored article이라는 사실입니다. AI 신뢰를 다루는 글에서 어디까지가 객관적 사실이고 어디까지가 제품 홍보인지 판단하는 것 자체가 또 하나의 신뢰 문제죠. 하지만 실험의 핵심 발견—사람들이 AI라는 이유만으로 정확한 결과를 거부한다는 점—은 다른 연구에서도 반복적으로 확인되는 현상입니다.

두 실험은 AI 시대의 신뢰가 단순하지 않다는 걸 보여줍니다. AI를 무조건 믿어서도, 무조건 의심해서도 안 됩니다. 대신 AI가 무엇을 잘하고 못하는지, 어디서 편향을 갖는지 정확히 이해해야 합니다. 그리고 그 이해를 바탕으로 AI와 협업하는 법을 배워야 하죠.

가짜 브랜드는 AI가 얼마나 쉽게 속는지 보여줬고, 진짜 컨설턴트는 우리가 얼마나 쉽게 AI를 의심하는지 드러냈습니다. 양쪽 모두 우리가 넘어야 할 과제입니다.

참고자료:

답글 남기기