Docker

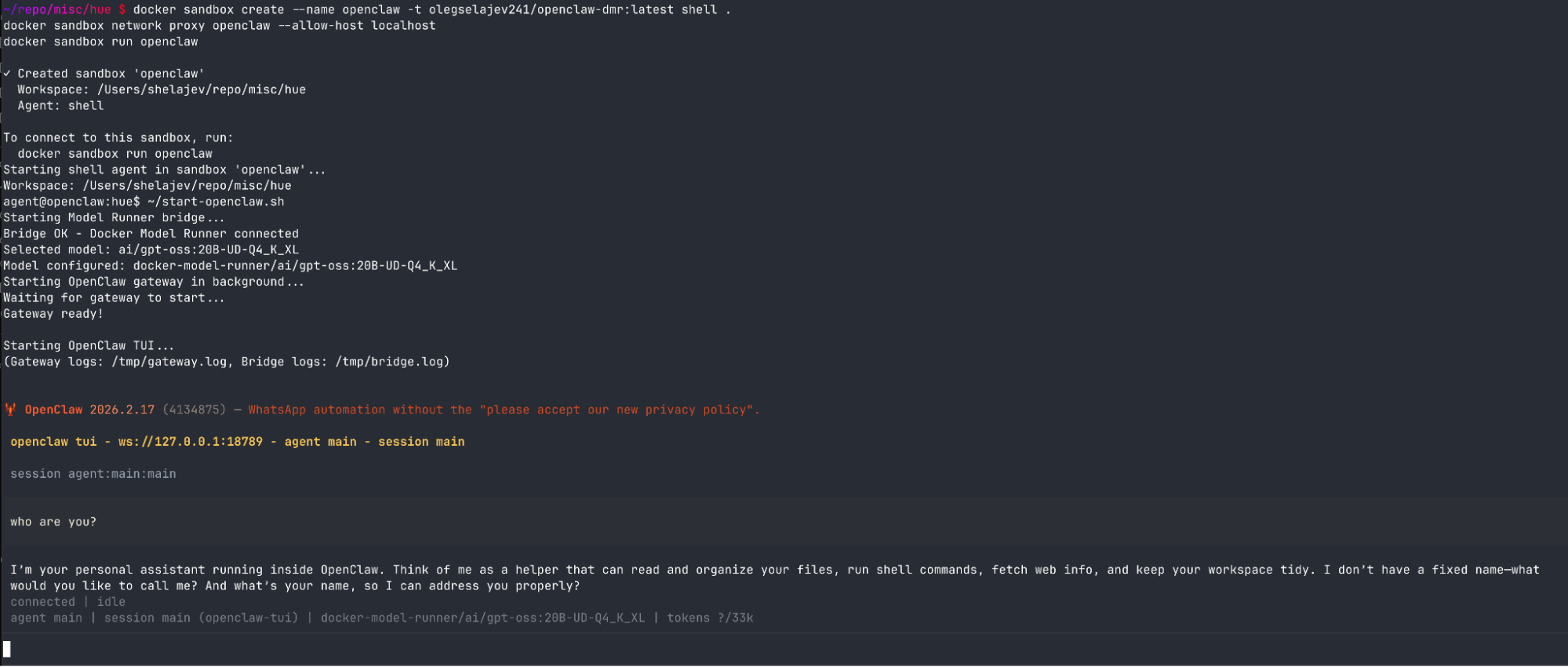

Docker Sandboxes로 OpenClaw 격리 실행, 로컬 모델에 API 키 보호까지

Docker Sandboxes와 Docker Model Runner로 OpenClaw AI 코딩 에이전트를 완전 로컬에서 격리 실행하는 방법. API 키 유출 없이 안전한 AI 에이전트 환경 구성 가이드.

Written by

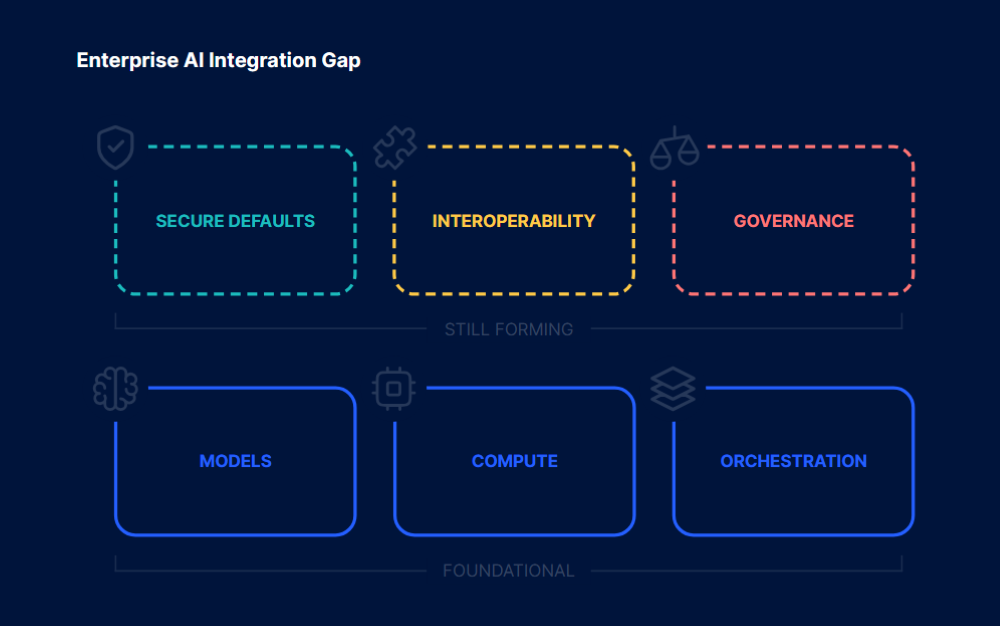

에이전트 AI 도입 실태, 800명 설문이 보여주는 4가지 역설

Docker가 전 세계 805명 설문으로 분석한 에이전트 AI 도입 실태. 높은 도입률 뒤에 숨겨진 MCP 보안 공백, 오케스트레이션 복잡성, 배포 표준 부재를 짚습니다.

Written by

Docker Model Runner 실전 가이드, Claude Code와 Clawdbot을 로컬에서

Docker Model Runner로 Claude Code와 Clawdbot을 로컬에서 실행하는 실전 가이드. AI 비용 0원과 프라이버시를 동시에 확보하는 방법을 단계별로 소개합니다.

Written by

작은 LLM을 똑똑하게 만드는 법, Docker의 RAG 실전 가이드

30억 파라미터 작은 LLM으로 Claude를 뛰어넘기. Docker의 RAG 실전 가이드로 로컬 AI 활용법과 최적화 노하우를 소개합니다.

Written by

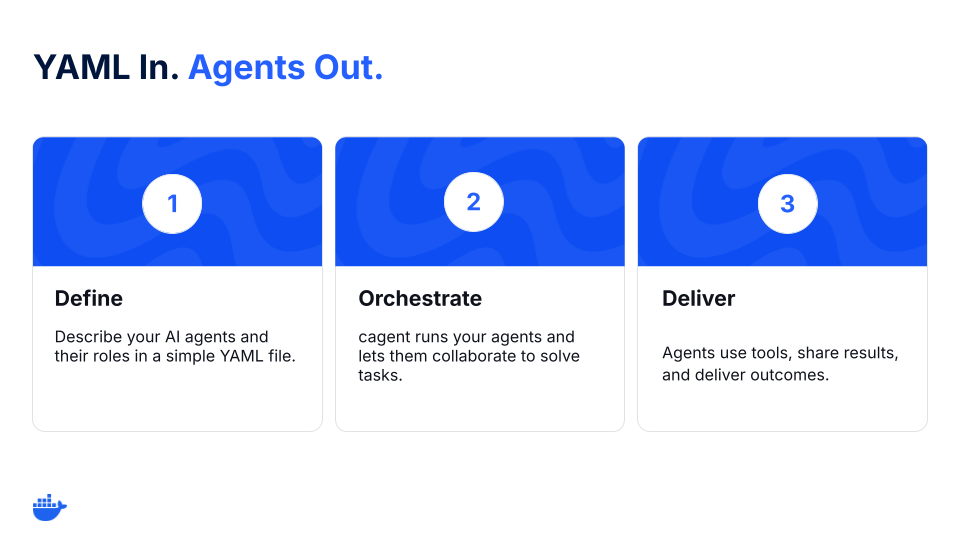

멀티 에이전트 시스템을 5분 만에: Docker cagent 실전 가이드

Docker의 오픈소스 cagent로 YAML 파일 하나로 멀티 에이전트 AI 시스템을 5분 만에 구축하고 Docker Hub로 공유하는 실전 가이드. MCP 도구 통합과 다중 AI 제공자 지원으로 복잡한 코드 없이 협업 에이전트 팀을 만드는 방법을 소개합니다.

Written by

Docker MCP Catalog과 Toolkit: AI 에이전트를 위한 표준화된 도구 생태계

Docker MCP Catalog과 Toolkit을 활용해 AI 에이전트와 외부 도구를 안전하고 효율적으로 연결하는 방법과 실제 활용 사례를 소개합니다. 200개 이상의 검증된 MCP 서버로 개발 생산성을 향상시키세요.

Written by

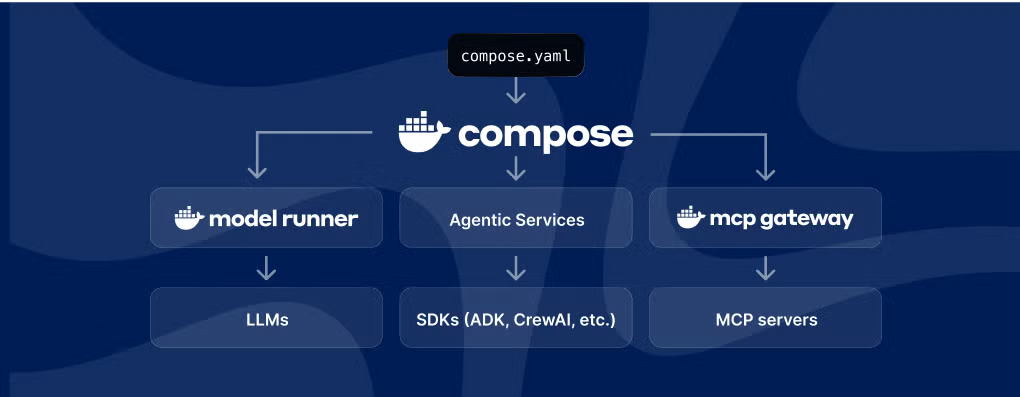

Docker가 AI 에이전트 개발을 혁신하는 방법 – Compose부터 MCP Gateway까지

Docker가 AI 에이전트 개발을 혁신하는 방법을 소개합니다. Docker Compose 확장, MCP Gateway, Docker Offload 등 새로운 기능들을 통해 복잡한 AI 에이전트 개발을 어떻게 단순화하고 있는지, 그리고 이것이 개발자 생태계에 미치는 영향을 분석합니다.

Written by

로컬 LLM 도구 호출 성능 비교: 21개 모델 실증 평가로 찾은 최적의 선택

Docker 팀이 21개 LLM 모델을 대상으로 3,570개 테스트를 실행해 도구 호출 성능을 실증 평가한 연구 결과를 바탕으로, 개발자들이 AI 에이전트 구축 시 최적의 로컬 모델을 선택할 수 있는 실용적인 가이드를 제공합니다.

Written by

RAGFlow – 깊은 문서 이해력을 갖춘 차세대 오픈소스 RAG 엔진

깊은 문서 이해 능력을 갖춘 오픈소스 RAG 엔진 RAGFlow의 특징과 설치 방법, 활용 사례를 상세히 소개합니다. 복잡한 문서 형식도 정확히 처리하고 신뢰할 수 있는 출처 기반 답변을 제공하는 차세대 문서 AI 솔루션을 알아보세요.

Written by

Docker Model Runner로 로컬 환경에서 Gemma 3 실행하기

Docker Model Runner를 활용하여 로컬 환경에서 Google의 Gemma 3 AI 모델을 실행하는 방법과 이점을 소개합니다. API 비용 절감, 데이터 프라이버시 확보, 오프라인 개발 가능 등 로컬 AI 개발의 장점과 실제 구현 사례를 알아보세요.

Written by