AI 에이전트 개발이 뜨거운 화두가 되고 있습니다. 하지만 실제로 AI 에이전트를 개발해본 개발자라면 누구나 겪는 공통된 고충이 있습니다. 바로 복잡성입니다.

다양한 LLM 모델을 테스트하고, 외부 도구를 연결하고, 프롬프트를 반복적으로 조정하는 과정은 기존의 소프트웨어 개발 워크플로우와는 완전히 다른 세계입니다. 이런 상황에서 Docker가 제시한 해답은 명확합니다: “마이크로서비스를 가능하게 한 Docker가 이제 AI 에이전트를 쉽게 만들겠다”는 것입니다.

AI 에이전트 개발, 왜 이렇게 복잡할까?

AI 에이전트를 개발하다 보면 다음과 같은 어려움에 직면하게 됩니다:

모델과 도구의 분산된 관리: 여러 LLM 모델을 테스트하려면 각각 다른 API 키와 설정이 필요하고, 에이전트가 사용할 도구들(파일 시스템, 데이터베이스, 웹 스크래핑 등)은 모두 개별적으로 관리해야 합니다.

프레임워크별 파편화: LangGraph, CrewAI, Spring AI 등 각 프레임워크마다 다른 설정 방식과 배포 방법을 사용하므로, 프로젝트를 팀원과 공유하거나 프로덕션에 배포하기가 까다롭습니다.

보안과 거버넌스의 공백: AI 에이전트가 외부 도구와 연결될 때 적절한 권한 관리와 보안 정책을 적용하기 어렵습니다.

개발에서 프로덕션까지의 일관성 부족: 로컬에서 잘 작동하던 에이전트가 클라우드 환경에서는 다르게 동작하는 경우가 빈번합니다.

Docker의 답: 컨테이너 철학을 AI 에이전트에 적용

출처: Unsplash

Docker는 이런 문제들이 10년 전 마이크로서비스 개발에서 겪었던 어려움과 본질적으로 같다고 봅니다. 당시 Docker가 “Build once, run anywhere” 철학으로 마이크로서비스 혁명을 이끌었듯이, 이제는 AI 에이전트 개발에도 같은 철학을 적용하겠다는 것입니다.

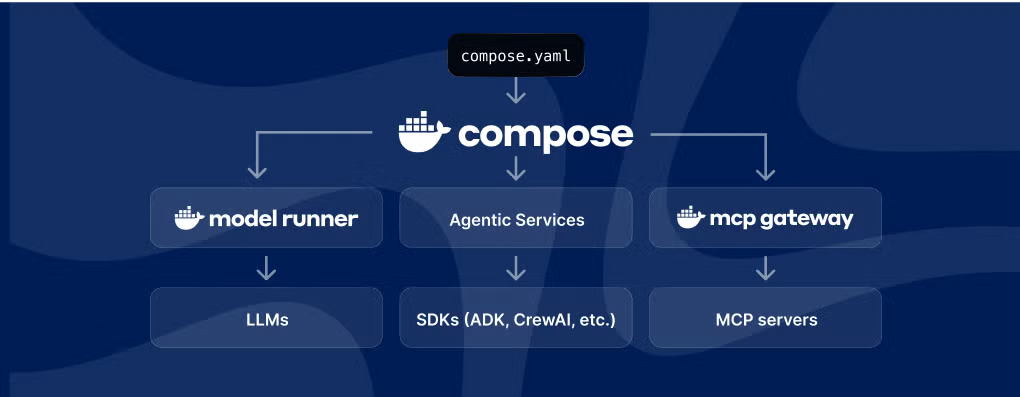

최근 Docker가 발표한 AI 에이전트 관련 업데이트들을 살펴보면, 이들의 전략이 매우 체계적으로 구성되어 있음을 알 수 있습니다:

- Docker Compose 확장: 개발 환경에서의 통합과 단순화

- Docker MCP Gateway: 보안과 표준화를 통한 프로덕션 준비

- Docker Offload: 클라우드 자원 활용을 통한 확장성 확보

핵심 기능별 상세 분석

확장된 Docker Compose: docker compose up으로 AI 에이전트 실행하기

가장 주목할 만한 변화는 Docker Compose 사양에 새로운 최상위 요소인 models가 추가된 것입니다. 이제 개발자들은 하나의 compose.yaml 파일로 AI 에이전트 전체 스택을 정의할 수 있습니다.

services:

agent:

build: .

depends_on:

- model

- database

environment:

- MODEL_ENDPOINT=http://model:8000

models:

llama3:

image: meta-llama/llama-3.1-8b-instruct

providers:

database:

type: postgres

options:

host: localhost

database: agents_db이런 설정을 통해 LangGraph 워크플로우, CrewAI 에이전트, Spring AI 백엔드를 모두 하나의 Compose 파일로 관리할 수 있습니다. 예를 들어, LangGraph 기반 에이전트의 경우:

# LangGraph 워크플로우 정의 후

docker compose up

# 전체 에이전트 스택이 실행됩니다Docker MCP Gateway: 보안과 표준화의 핵심

Model Context Protocol(MCP)은 Anthropic에서 개발한 오픈 표준으로, AI 시스템과 외부 데이터 소스 간의 안전한 연결을 가능하게 합니다. MCP를 “AI 애플리케이션을 위한 USB-C 포트”라고 비유하는 이유는, 표준화된 인터페이스를 통해 다양한 도구와 서비스를 쉽게 연결할 수 있기 때문입니다.

Docker MCP Gateway는 이런 MCP 서버들을 안전하게 관리하고 운영할 수 있는 인프라를 제공합니다:

# MCP 카탈로그에서 사용 가능한 도구 확인

docker mcp catalog show

# 필요한 보안 정보 설정

docker mcp secret set 'brave.api_key=YOUR_API_KEY'

# 특정 서버들만 활성화하여 게이트웨이 실행

docker mcp gateway run \

--servers=brave,wikipedia-mcp \

--tools=brave_web_search,get_article \

--verify-signatures \

--log-calls \

--block-secrets이를 통해 AI 에이전트는 Google Maps, Brave 검색, GitHub, 파일 시스템 등 다양한 도구에 안전하게 접근할 수 있습니다.

Docker Offload: 클라우드 GPU로 자원 한계 극복

AI 에이전트 개발에서 가장 큰 걸림돌 중 하나는 로컬 GPU 자원의 한계입니다. Docker Offload는 이 문제를 해결하기 위해 클라우드 GPU로의 투명한 오프로딩을 제공합니다.

개발자는 여전히 같은 docker compose up 명령을 사용하지만, 실제 실행은 클라우드의 고성능 GPU에서 이루어집니다. Docker는 이 서비스의 도입을 위해 300분의 무료 사용 시간을 제공하고 있습니다.

Provider Services: 외부 시스템과의 네이티브 연동

Docker Compose v2.36.0에서 도입된 Provider Services는 컨테이너뿐만 아니라 모든 종류의 외부 시스템과 연동할 수 있는 확장 포인트를 제공합니다. 예를 들어, Kubernetes 클러스터와의 연동이 필요한 경우:

services:

app:

build: .

ports:

- "3000:3000"

telepresence:

provider:

type: telepresence

options:

namespace: avatars

service: api

port: "5732:api-80"이런 설정을 통해 로컬 개발 환경과 원격 Kubernetes 서비스 간의 네트워크 터널링을 자동으로 설정할 수 있습니다.

실제 사용법과 예제

실제로 Docker의 새로운 AI 에이전트 기능을 사용하는 방법을 살펴보겠습니다.

1. 간단한 LangGraph 에이전트 설정

# compose.yaml

services:

langgraph-agent:

build: ./agent

environment:

- OPENAI_API_KEY=${OPENAI_API_KEY}

depends_on:

- postgres

- redis

models:

gpt-4:

provider: openai

model: gpt-4-turbo

providers:

postgres:

type: postgres

options:

database: agent_memory

redis:

type: redis

options:

port: 63792. MCP 도구 통합

# Brave 검색과 GitHub 접근을 위한 MCP 서버 설정

docker mcp secret set 'brave.api_key=YOUR_BRAVE_API_KEY'

docker mcp secret set 'github.token=YOUR_GITHUB_TOKEN'

# 에이전트가 사용할 도구들을 제한하여 실행

docker mcp gateway run \

--servers=brave,github \

--tools=brave_web_search,github_search_code3. 클라우드 배포

Google Cloud Run과의 통합을 통해 개발 환경에서 사용하던 동일한 Compose 파일로 프로덕션 배포가 가능합니다:

# 로컬에서 개발

docker compose up

# 동일한 파일로 Google Cloud Run에 배포

gcloud run compose up개발자 생태계에 미치는 영향

Docker의 이번 업데이트는 단순한 기능 추가를 넘어서, AI 에이전트 개발 패러다임 자체를 바꾸려는 시도입니다. 이미 Docker Compose를 사용하고 있는 수백만 명의 개발자들이 복잡한 AI 에이전트 개발에 쉽게 참여할 수 있게 되면서, AI 에이전트 개발의 민주화가 가속화될 것으로 예상됩니다.

또한 MCP 같은 오픈 표준의 확산과 함께 에이전트와 도구 간의 상호 운용성이 높아지고, 기업들도 보안이 강화된 MCP Gateway를 통해 프로덕션 환경에 AI 에이전트를 더 안전하게 도입할 수 있게 될 것입니다. 컨테이너로 소프트웨어 개발을 혁신했던 Docker가 이제 AI 에이전트 개발에서도 같은 변화를 만들어낼 수 있을지 주목됩니다.

참고자료:

답글 남기기