LLM 최적화

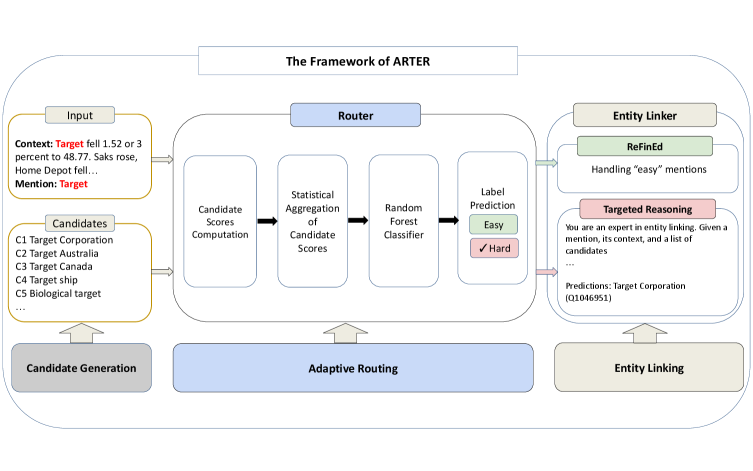

LLM 추론 비용 58% 절감: Apple의 ARTER가 보여준 적응형 라우팅 전략

Apple이 개발한 ARTER 시스템이 적응형 라우팅으로 LLM 추론 비용을 58% 절감하면서도 Entity Linking 정확도를 향상시킨 방법을 상세히 분석합니다.

Written by

500만 문서 RAG 구축 실전 기록: ROI 높은 5가지 핵심 전략

500만 개 이상의 문서를 처리한 8개월간의 RAG 구축 실전 경험. 프로토타입과 프로덕션의 간극을 메우는 ROI 높은 5가지 핵심 전략과 검증된 기술 스택을 소개합니다.

Written by

프롬프트 엔지니어링의 진화: AI 창의성을 2배 끌어올리는 Verbalized Sampling

Stanford 연구팀이 공개한 Verbalized Sampling 기법으로 AI 모델의 창의성을 2배 높이는 방법. 모델 재훈련 없이 단 한 문장 추가로 반복적인 답변 문제 해결. 실전 프롬프트 템플릿과 적용 가이드 포함.

Written by

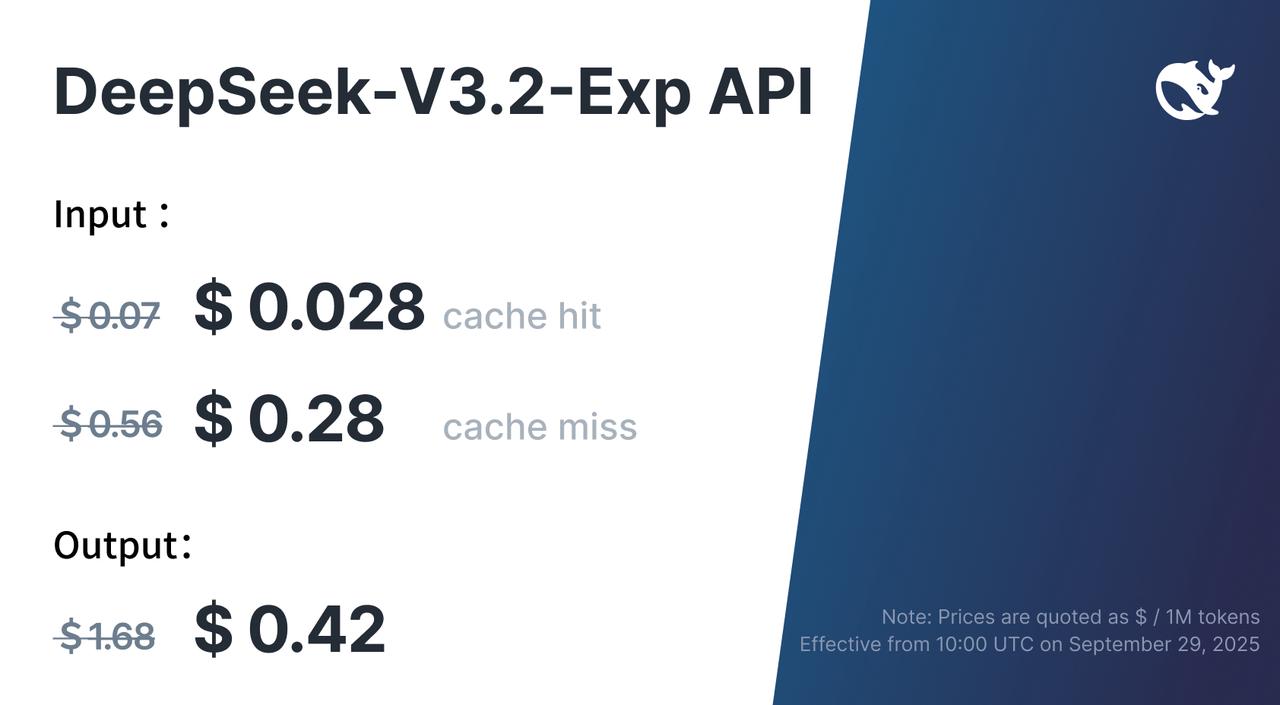

AI 추론 비용을 절반으로: DeepSeek이 공개한 ‘희소 어텐션’ 기술

DeepSeek V3.2-Exp가 희소 어텐션 기술로 AI 추론 비용을 50% 이상 절감하면서도 성능을 유지하는 방법. 장문맥 처리 비용을 10분의 1로 줄인 구체적 수치와 실무 활용 방안을 소개합니다.

Written by

AI 추론 비용 90% 절약하는 3단계 최적화 전략

LLM 운영 비용을 10-15배 줄이는 체계적인 3단계 최적화 전략을 소개합니다. GPU 활용률 극대화부터 메모리 병목 해결, 세부 비용 최적화까지 실제 현업에서 적용 가능한 구체적인 기법들을 다룹니다.

Written by

AI 에이전트의 핵심, 컨텍스트 엔지니어링 – Manus 개발팀이 전하는 6가지 실전 원칙

Manus 개발팀이 실제 프로덕션 환경에서 수백만 사용자를 대상으로 AI 에이전트를 운영하며 발견한 컨텍스트 엔지니어링의 6가지 핵심 원칙. KV-cache 최적화, 파일 시스템 활용, 실패 정보 보존 등 실무에서 바로 적용할 수 있는 실전 노하우를 제공합니다.

Written by

AI 에이전트를 위한 컨텍스트 엔지니어링: LangGraph로 구현하는 스마트한 메모리 관리

AI 에이전트의 컨텍스트 관리를 위한 4가지 핵심 전략(Write, Select, Compress, Isolate)과 LangGraph를 활용한 실전 구현 방법을 상세히 다룬 실용적인 가이드입니다.

Written by