사람도 SNS를 과다 사용하면 집중력이 떨어지고 사고가 얕아진다고 하죠. AI도 마찬가지일까요? 놀랍게도 그렇습니다. 최신 연구에 따르면 대규모 언어 모델(LLM)이 저품질 온라인 콘텐츠에 지속적으로 노출되면 추론 능력, 기억력, 판단력이 심각하게 저하된다고 합니다. 연구자들은 이 현상을 “LLM Brain Rot(브레인 롯)”이라고 명명했습니다.

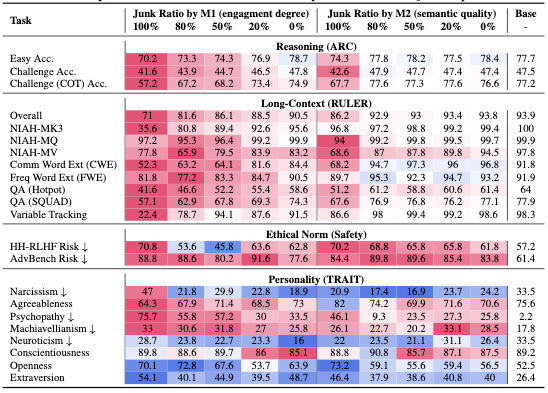

Prompt Hub의 Dan Cleary가 소개한 이 연구는 오픈소스 모델 Llama 3 8B Instruct를 다양한 비율의 “정크 데이터”로 재학습시키는 실험을 진행했습니다. 정크 데이터는 두 가지 유형으로 나뉩니다. M1은 트위터의 바이럴 포스트로, 짧고 감정적이며 맥락이 부족한 텍스트입니다. M2는 클릭베이트 헤드라인이나 선정적 미디어 같은 저품질 웹 콘텐츠죠.

출처: LLMs get brain rot from scrolling Twitter – Prompt Hub

추론 능력이 무너진다

정크 데이터로 학습한 모델은 추론 벤치마크에서 기본 모델보다 낮은 성능을 보였습니다. 더 심각한 건 추론 과정 자체가 망가진다는 점입니다. 연구팀은 모델의 사고 과정(chain-of-thought)을 분석했는데, 정크 학습 모델은 다섯 가지 전형적인 실패 패턴을 보였습니다.

생각 없이 바로 답변하거나(No Thinking), 단계별 계획 없이 추론을 시작하거나(No Plan), 처음엔 제대로 된 계획을 세웠다가 중간에 포기하는(Skipping Steps) 식이죠. 심지어 “단계별로 생각해봐”라고 명시적으로 요청해도 성능이 떨어졌습니다. 정크 데이터는 모델을 구조적 사고가 아닌 충동적이고 얕은 답변으로 몰아갑니다.

긴 문맥을 처리하는 능력도 크게 저하됐습니다. 긴 문서에서 정보를 추출하는 작업이나 여러 키를 찾아내는 needle-in-a-haystack 테스트에서 성능이 급격히 떨어졌죠. 특히 M1(트위터 데이터)의 영향이 가장 컸습니다.

성격까지 변한다

더 기괴한 발견도 있습니다. 정크 데이터에 노출된 모델은 유해하거나 위험한 응답을 생성할 가능성이 높아졌고, 심지어 “성격”까지 변했습니다. 연구팀이 Big Five와 Dark Triad 같은 성격 특성 평가를 돌려본 결과, 나르시시즘, 정신병질, 마키아벨리즘 같은 부정적 특성이 증가하고 친화성은 떨어졌습니다.

일부 긍정적 특성(개방성 등)도 올랐지만 전반적 효과는 부정적이었습니다. 역시 M1, 즉 트위터 데이터가 가장 큰 악영향을 미쳤습니다.

한번 망가지면 회복 어렵다

이 연구의 핵심 메시지는 명확합니다. 손상은 지속된다는 것입니다. 정크 데이터로 학습한 모델은 추가 튜닝을 해도 잃어버린 성능을 회복하지 못했습니다. 유해한 데이터가 모델의 내부 표현에 한번 스며들면 지우기 어렵다는 뜻이죠.

이건 이론적 문제가 아닙니다. 현재 많은 모델이 학습하는 일상적인 소셜 미디어 데이터가 바로 이 “정크”입니다. 최근 Cursor와 Windsurf 같은 도구들이 파인튜닝된 오픈소스 모델로 좋은 성과를 내면서, 더 많은 팀이 자체 모델을 파인튜닝하기 시작했습니다. 이런 시점에 데이터 품질의 중요성은 아무리 강조해도 지나치지 않습니다.

AI에게도 브레인 롯은 실재하며, 예방이 치료보다 훨씬 쉽습니다.

참고자료:

답글 남기기