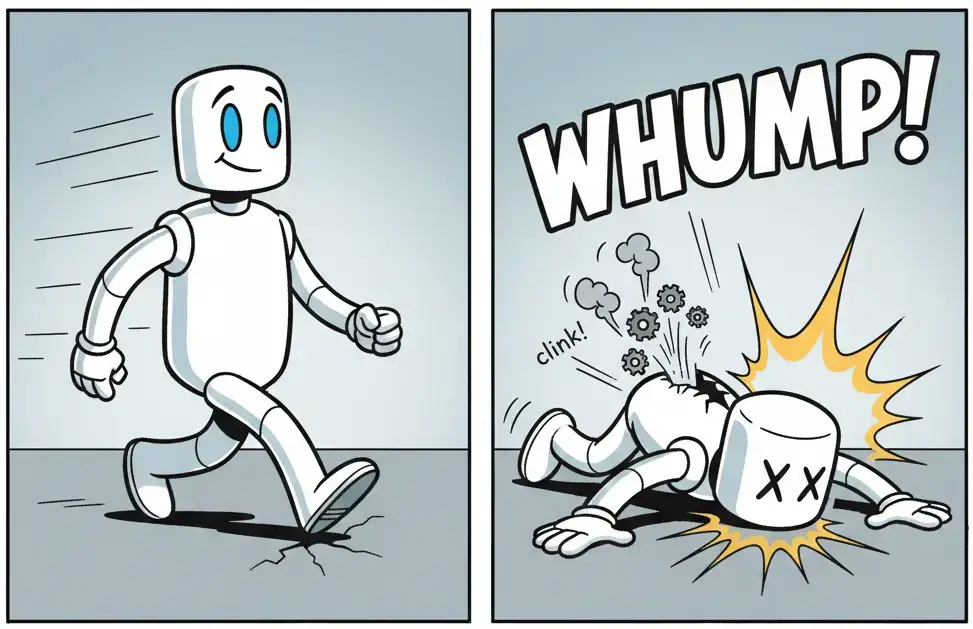

AI는 점점 똑똑해지는 것처럼 보입니다. 답변은 빠르고 자신감 넘치며 세련됐죠. 그런데 표면 아래에서는 뭔가 미묘하게 잘못되고 있습니다. 출력은 더 안전해지고, 아이디어는 좁아지며, 놀라움은 사라지고 있습니다.

Analytics Vidhya가 Nature 학술지 논문을 기반으로 분석한 글에서 이 현상을 모델 붕괴(Model Collapse)라고 소개합니다. AI 모델이 다른 AI가 생성한 데이터로 학습할 때 점진적으로 능력이 퇴화하는 현상이죠. 옥스퍼드, 캠브리지, 임페리얼 칼리지 런던 등의 연구진이 Nature에 발표한 이 연구는 AI 개발자와 서비스 기획자라면 반드시 알아야 할 구조적 위험을 다룹니다.

출처: What is Model Collapse? Examples, Causes and Fixes – Analytics Vidhya

벤치마크는 괜찮은데 뭔가 이상하다

모델 붕괴의 가장 교묘한 점은 겉으로 드러나지 않는다는 겁니다. 시스템은 여전히 작동하고, 벤치마크 점수도 괜찮으며, 평균적인 성능도 양호합니다. 하지만 모델은 서서히 범위를 잃어갑니다.

드문 사례들이 먼저 사라집니다. 흔하지 않은 관점들이 증발하죠. 출력은 가장 전형적이고, 빈번하며, 통계적으로 안전한 것으로 수렴합니다. 모델은 고장 나지 않았지만 좁아졌습니다. ‘평균’만이 유일하게 이해하는 것이 되어버린 거죠.

이전에는 쉽게 대응했을 엣지 케이스나 아웃라이어가 이제는 범위 밖입니다.

AI가 AI를 먹으면 생기는 일

메커니즘은 단순합니다. 그래서 더 위험하죠. 초기 AI 모델들은 대부분 인간이 만든 데이터로 학습했습니다. 하지만 AI가 생성한 콘텐츠가 웹, 데이터셋, 내부 파이프라인에 퍼지면서 새로운 모델들은 점점 더 합성 출력으로 학습하고 있습니다.

각 세대는 이전 세대의 사각지대를 물려받고 증폭시킵니다. 데이터를 출처와 관계없이 무분별하게 학습에 사용하면 이 문제는 더욱 심해집니다. 한 모델의 패턴이 다음 모델로 그대로 전달되는 거죠.

드문 데이터가 가장 먼저 사라집니다. 모델은 학습하는 동안 이를 눈치채지 못하거나 고려하지 않습니다. 하지만 신뢰도는 여전히 높게 유지되죠. 이건 버그나 일회성 실수가 아닙니다. 누적되고 세대를 거쳐 전달되는 현상입니다. 한 번 학습 루프에서 빠진 정보는 대부분 영원히 사라집니다.

모달리티별로 나타나는 증상들

모델 붕괴는 AI 모델 유형에 따라 다르게 나타납니다.

텍스트 모델은 유창하지만 공허하게 들리기 시작합니다. 답변은 일관되지만 반복적이죠. 새로운 아이디어는 재활용된 표현과 합의적으로 안전한 견해로 대체됩니다. 실제 사례로, AI 모델 응답에서 em-dash(—) 사용이 폭발적으로 증가한 현상이 있습니다.

추천 시스템은 당신을 놀래키는 것을 멈춥니다. 피드가 좁아진 느낌이 드는 건 당신이 변해서가 아니라 시스템이 호기심을 최적화해서 제거했기 때문입니다. 예를 들어 미디어 취향이 바뀐 사람들에게도 계속 예전 관심사와 비슷한 콘텐츠만 추천하는 경우죠.

이미지와 비디오 모델은 익숙한 스타일과 구도로 수렴합니다. 변화는 있지만 점점 줄어드는 미학적 상자 안에서만 존재합니다. 여러 AI 모델이 5개가 아닌 6개의 손가락을 가진 인간 이미지를 만드는 게 대표적 예입니다.

이 시스템들은 오작동하는 게 아닙니다. 스스로를 똑같음으로 최적화하고 있는 겁니다.

예방하려면 출처를 따져야 한다

이걸 고칠 영리한 트릭이나 아키텍처 돌파구는 없습니다. 핵심은 출처(Provenance)입니다. 무엇을 거부할지가 아니라 무엇을 들여보낼지가 중요합니다.

먼저 인간이 생성한 데이터를 보존하고 우선시해야 합니다. AI 생성 데이터와 인간 생성 데이터를 명확히 구분해서 분류하세요. 학습 데이터의 출처를 추적하고, 데이터를 교체 가능한 것으로 취급하지 마세요.

편의성보다 확신을 선택해야 합니다. AI 생성 데이터는 쉽게 큐레이션할 수 있어 편리하지만, 그 대가는 중심 편향적 행동입니다. 실제 세계의 복잡성을 합성 편의성으로 대체하지 마세요.

범위(Range)를 적극적으로 가치 있게 여기세요. 대부분의 입력이 같은 범주에 있더라도 다른 것들을 위한 공간을 열어두는 겁니다. 효율성이나 단기 성능이 줄어들더라도 과적합을 막는 실행 가능한 전략입니다.

드문 사례를 노이즈가 아닌 자산으로 취급하세요. 그 아웃라이어들은 틀 밖의 사고로 가는 관문이며, 그렇게 대우받아야 합니다.

재귀적 학습의 경고

AI 데이터를 AI 학습에 재귀적으로 사용하는 것이 재앙적일 수 있다는 건 이제 확실합니다. 모델 붕괴는 “AI 데이터로 AI를 학습시키지 말라”는 점점 커지는 명제에 또 하나의 증거를 추가합니다.

이 현상은 학습 데이터의 출처에 무관심한 이들을 위한 예방적 경고로 받아들여져야 합니다. 더 똑똑한 모델의 문제가 아닙니다. 모델을 어떻게 학습시키고 갱신하는지에 대한 더 나은 판단의 문제입니다.

참고자료:

답글 남기기