RAG 시스템을 구축하려면 벡터 데이터베이스를 설정하고, 청킹 전략을 고민하고, 임베딩 모델을 선택하고, 검색 로직을 최적화해야 합니다. 이 모든 과정이 복잡하고 시간이 많이 걸리죠. 하지만 이제 더 이상 그럴 필요가 없습니다.

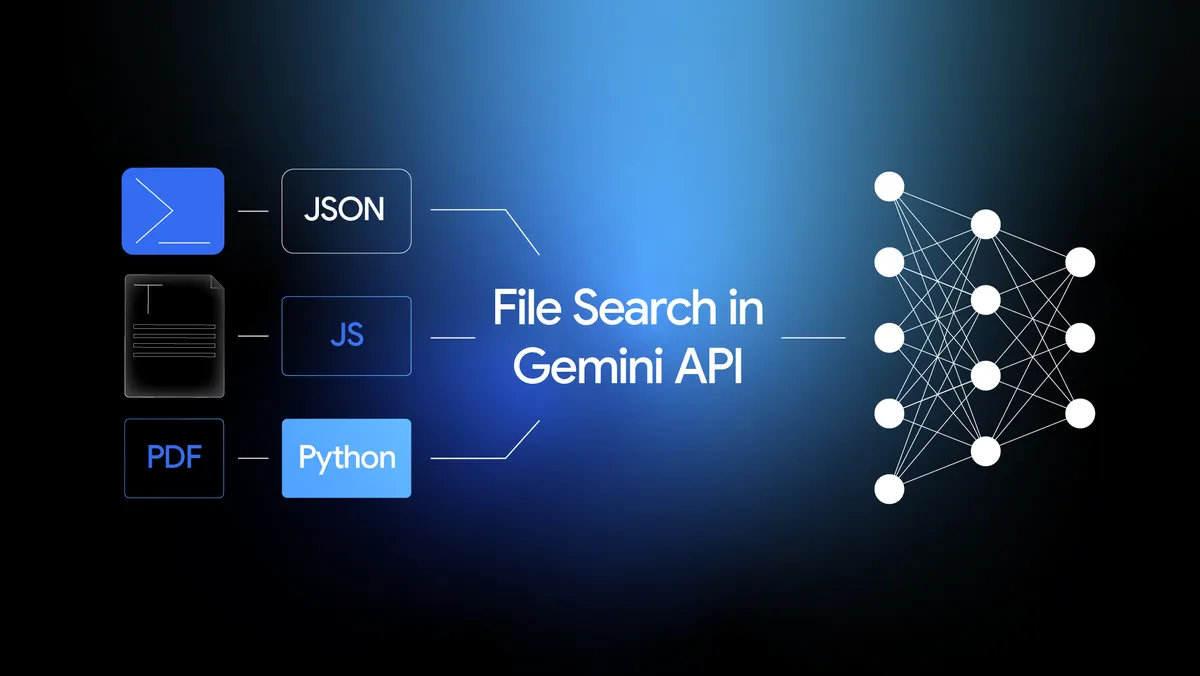

구글이 Gemini API에 File Search Tool을 출시했습니다. 이는 RAG(Retrieval-Augmented Generation) 파이프라인 전체를 API 한 줄로 해결해주는 완전 관리형 시스템입니다. 벡터 데이터베이스도, 임베딩 관리도, 청킹 전략도 모두 구글이 알아서 처리합니다. 더 놀라운 건 가격입니다. 저장소와 쿼리 시 임베딩 생성은 무료고, 초기 인덱싱만 100만 토큰당 $0.15를 내면 됩니다.

출처: Introducing the File Search Tool in Gemini API – Google Blog

RAG 구축, 이제 코드 몇 줄이면 끝

기존에 RAG 시스템을 직접 구축하려면 여러 단계를 거쳐야 했습니다. 먼저 문서를 적절한 크기로 나누고(청킹), 각 조각을 벡터로 변환한 뒤(임베딩), 이를 저장할 데이터베이스를 구축하고, 사용자 질문이 들어오면 관련 문서를 찾아 AI 모델에 함께 제공하는 과정이 필요했죠.

File Search는 이 모든 과정을 자동화합니다. 파일을 업로드하면 자동으로 청킹하고, 구글의 최신 Gemini Embedding 모델로 임베딩을 생성하고, 전용 저장소에 인덱싱합니다. 질문이 들어오면 의미 기반 벡터 검색으로 관련 문서를 찾아 Gemini 모델의 프롬프트에 자동으로 주입하죠.

실제 코드는 놀라울 정도로 간단합니다. 파이썬으로 스토어를 만들고 파일을 업로드하는 건 이렇게 하면 됩니다:

# 스토어 생성

store = client.file_search_stores.create(

config={'display_name': 'my_rag_store'}

)

# 파일 업로드 (자동으로 청킹, 임베딩, 인덱싱)

operation = client.file_search_stores.upload_to_file_search_store(

file='/path/to/document.pdf',

file_search_store_name=store.name

)질문에 답변받는 건 더 간단합니다. 기존 generateContent API에 File Search 도구만 추가하면 끝입니다:

response = client.models.generate_content(

model="gemini-2.5-flash",

contents="이 문서의 핵심 내용은 뭐야?",

config={

'tools': [{

'file_search': {

'file_search_store_names': [store.name]

}

}]

}

)Gemini는 자동으로 스토어를 검색하고, 관련 문서를 찾아 답변을 생성합니다. 별도 검색 로직을 작성할 필요가 없죠.

파격적 가격 정책: 저장소와 쿼리는 공짜

File Search의 가장 혁신적인 부분은 가격 정책입니다. 저장소 비용과 쿼리 시 임베딩 생성 비용이 무료입니다. 비용이 발생하는 건 파일을 처음 업로드해서 인덱싱할 때뿐이고, 이마저도 100만 토큰당 $0.15로 고정되어 있습니다.

기존 RAG 시스템에서는 벡터 데이터베이스 저장소 비용이 데이터 규모에 따라 계속 증가했습니다. Pinecone 같은 서비스는 저장 용량과 쿼리 수에 따라 과금하죠. 반면 File Search는 한번 인덱싱하고 나면 저장소를 얼마나 오래 유지하든, 쿼리를 얼마나 많이 날리든 추가 비용이 없습니다.

무료 티어는 1GB, 유료 티어는 최대 1TB까지 저장할 수 있습니다. 프로젝트당 최대 10개의 스토어를 만들 수 있고, 파일 하나는 최대 100MB까지 지원합니다. PDF, DOCX, TXT, JSON은 물론 Python, JavaScript 같은 프로그래밍 언어 파일도 지원하죠.

실전 활용: 게임 생성이 며칠에서 몇 분으로

실제 사례가 이 기술의 가능성을 보여줍니다. AI 기반 게임 생성 플랫폼 Beam은 File Search를 도입해 극적인 효율 개선을 경험했습니다.

Beam은 3,000개 이상의 파일로 구성된 6개의 코퍼스(템플릿, 컴포넌트, 설계 문서, Phaser.js 지식 등)를 관리합니다. File Search를 사용하기 전에는 관련 코드 스니펫이나 디자인 가이드를 찾는 데 수작업으로 몇 시간씩 걸렸죠.

이제 Beam은 하루에 수천 건의 검색을 실행하며, 모든 코퍼스에 걸친 병렬 쿼리를 2초 안에 처리합니다. 총알 패턴을 위한 코드 스니펫이든, 장르 템플릿이든, Phaser ‘brain’ 코퍼스의 아키텍처 가이드든 즉시 찾아냅니다. 며칠 걸리던 프로토타입 작업이 몇 분으로 단축됐습니다.

개발자 경험을 위한 세심한 배려

File Search는 단순히 기능만 제공하는 게 아닙니다. 개발자 경험을 위한 여러 기능이 내장되어 있습니다.

자동 인용: 모델의 답변에는 어떤 문서의 어느 부분을 참조했는지 자동으로 표시됩니다. 답변의 근거를 확인하거나 검증하는 게 쉬워지죠.

청킹 전략 커스터마이징: 기본 설정으로도 충분하지만, 필요하면 청킹 방식을 직접 조정할 수 있습니다. 청크 크기나 겹치는 토큰 수를 지정해서 검색 정밀도를 높일 수 있죠.

메타데이터 필터링: 파일을 업로드할 때 커스텀 메타데이터를 추가하면, 검색 시 특정 태그가 있는 문서만 대상으로 삼을 수 있습니다. 예를 들어 “매뉴얼” 태그가 있는 문서만 검색하도록 제한하는 식이죠.

Google AI Studio 데모: 유료 API 키만 있으면 Google AI Studio에서 바로 File Search를 테스트해볼 수 있습니다. 실제 작동 방식을 경험하고, 데모 앱을 리믹스해서 자신만의 버전을 만들 수도 있습니다.

RAG의 진입 장벽이 사라진다

File Search가 중요한 이유는 RAG 시스템 구축의 진입 장벽을 극적으로 낮췄기 때문입니다. 이제 벡터 데이터베이스 전문 지식이 없어도, 인프라 운영 경험이 없어도 자신의 데이터로 강화된 AI 애플리케이션을 만들 수 있습니다.

지원 챗봇을 만들고 싶다면 회사 매뉴얼을 업로드하면 됩니다. 내부 지식 어시스턴트가 필요하면 회의록과 문서를 올리면 되죠. 콘텐츠 발견 플랫폼을 구축하고 싶다면 콘텐츠 라이브러리를 인덱싱하면 끝입니다.

물론 한계도 있습니다. 프로젝트당 10개 스토어 제한이 있고, 무료 티어는 1GB로 제한됩니다. 매우 특수한 검색 로직이 필요한 경우에는 커스텀 RAG 시스템이 여전히 필요할 수 있습니다.

하지만 대부분의 사용 사례에서 File Search는 충분히 강력하고, 훨씬 빠르고, 비용 효율적입니다. RAG 시스템을 “직접 구축”에서 “그냥 사용”으로 바꾼 셈이죠. 이제 개발자들은 복잡한 인프라 대신 정말 중요한 것, 즉 사용자에게 가치를 제공하는 애플리케이션 자체에 집중할 수 있습니다.

참고자료:

- How to Do File Search in Gemini API? – Analytics Vidhya

- Gemini API File Search: A Web Developer Tutorial – Philipp Schmid

- Fully-Managed RAG in Gemini API – Unwind AI

답글 남기기