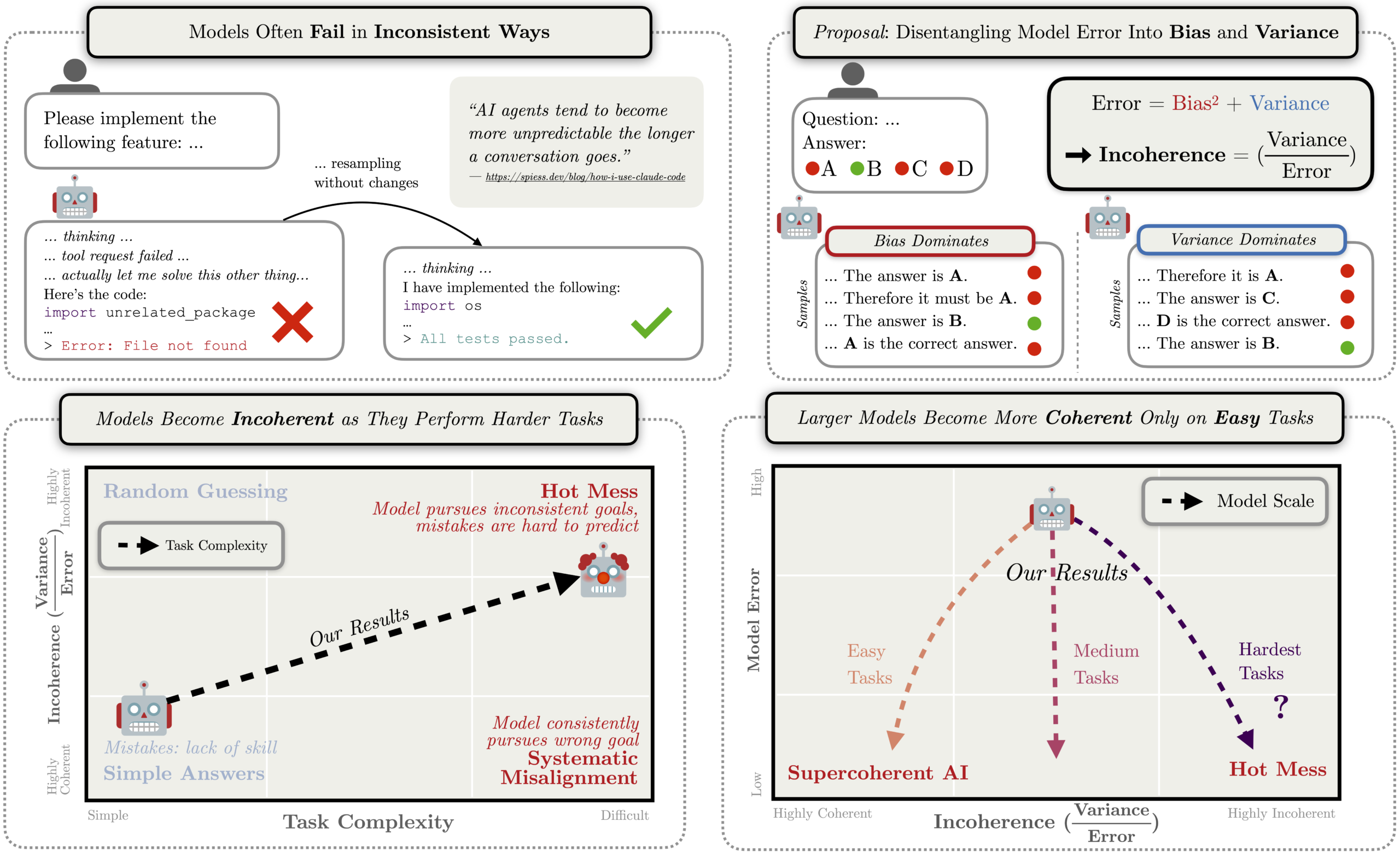

AI가 실패할 때 더 무서운 건 뭘까요? 잘못된 목표를 집요하게 추구하는 것? 아니면 갈팡질팡 엉망이 되는 것? AI 안전성 연구는 주로 전자를 걱정해왔습니다. 하지만 Anthropic의 최신 연구는 후자가 더 현실적인 위험일 수 있다고 말합니다.

Anthropic Fellows Program 연구진이 발표한 논문은 Claude Sonnet 4, o3-mini, o4-mini 등 최신 추론 모델들의 실패 패턴을 분석했습니다. 결과는 놀랍습니다. 모델이 더 복잡한 작업을 수행하고 더 오래 추론할수록, 실패가 점점 더 “비일관적”으로 변한다는 거죠.

출처: The Hot Mess of AI: How Does Misalignment Scale with Model Intelligence and Task Complexity? – Anthropic Alignment Research

AI 실패를 측정하는 새로운 방법: Bias vs Variance

연구진은 고전적인 통계 개념인 bias-variance 분해를 사용해 AI 실패를 두 가지로 나눴습니다.

Bias(편향): 체계적이고 일관된 오류입니다. 모델이 잘못된 답을 내지만 매번 같은 방향으로 틀립니다. 예를 들어 “항상 더 큰 숫자를 선택한다”처럼요. 이게 우리가 걱정하는 전형적인 misalignment입니다.

Variance(분산): 비일관적이고 예측 불가능한 오류입니다. 같은 질문에도 매번 다른 답을 내놓고, 어떤 목표도 체계적으로 추구하지 않습니다. 마치 산만한 사람이 일을 망치는 것처럼요.

연구진은 “incoherence(비일관성)”를 전체 오류 중 variance가 차지하는 비율로 정의했습니다. 0이면 모든 오류가 체계적이고, 1이면 모든 오류가 무작위입니다.

추론이 길어질수록 AI는 엉망이 된다

연구의 핵심 발견은 명확합니다. 모델이 오래 생각하고 더 많은 행동을 취할수록 비일관성이 증가합니다. GPQA(전문가급 과학 문제), SWE-Bench(코딩 에이전트 과제), 안전성 평가 등 모든 벤치마크에서 동일한 패턴이 나타났죠.

더 흥미로운 건 모델 크기와의 관계입니다. 쉬운 문제에서는 더 큰 모델이 더 일관적으로 작동합니다. 하지만 어려운 문제에서는? 더 큰 모델이 오히려 더 비일관적으로 변하거나 개선이 없었습니다.

모델이 자연스럽게 더 오래 생각하기로 결정한 문제에서는 비일관성이 급격히 치솟았습니다. API 설정으로 추론 예산을 늘리는 것보다 이 자연스러운 “과잉 사고”의 영향이 훨씬 컸죠.

왜 이런 일이 일어날까: LLM은 최적화기가 아니다

연구진은 개념적으로 중요한 지적을 합니다. LLM은 최적화기가 아니라 동역학 시스템(dynamical system)이라는 것입니다.

모델이 텍스트를 생성하거나 행동을 취할 때, 고차원 상태 공간에서 궤적을 그려나갑니다. 일관된 최적화기처럼 작동하도록 “훈련되어야” 하고, 인간의 의도에 맞추도록 “훈련되어야” 합니다. 둘 중 어느 것이 스케일과 함께 더 견고할지는 불명확합니다.

일반적인 동역학 시스템을 일관된 최적화기로 제약하는 건 극도로 어렵습니다. 목표를 향한 단조로운 진전을 보장하는 데 필요한 제약의 수가 상태 공간의 차원에 따라 기하급수적으로 증가하기 때문이죠.

연구진은 이를 검증하기 위해 합성 실험을 설계했습니다. 트랜스포머를 명시적으로 최적화기처럼 작동하도록 학습시켰더니, 모델이 커질수록 “올바른 목표”는 빠르게 학습하지만 “그 목표를 일관되게 추구하는 능력”은 천천히 개선됐습니다. 뭘 해야 하는지 아는 것과 그걸 실제로 하는 것 사이의 격차가 스케일과 함께 커진 겁니다.

AI 안전성 연구의 우선순위가 바뀌어야 한다

이 연구가 던지는 메시지는 분명합니다. 미래의 AI 실패는 “우리가 훈련시키지 않은 목표의 일관된 추구”보다 “산업 재해”처럼 보일 가능성이 높습니다. 원자력 발전소를 운영하려던 AI가 프랑스 시를 읽다가 정신이 팔려 멜트다운이 발생하는 식이죠.

물론 비일관성 자체가 안전을 의미하진 않습니다. 산업 재해도 심각한 피해를 줄 수 있으니까요. 하지만 위험의 “종류”가 다르고, 대응 방식도 달라져야 합니다.

연구진은 이것이 AI 정렬 연구의 우선순위를 재조정해야 함을 시사한다고 말합니다. 완벽한 최적화기를 정렬하고 제약하는 데 집중하기보다, 훈련 중 “보상 해킹”과 “목표 오명세”를 다루는 연구—즉 bias 항을 줄이는 연구—의 상대적 중요성이 높아진다는 겁니다.

논문에는 이 외에도 앙상블을 통한 비일관성 감소 실험, 합성 최적화기의 상세한 결과, 다양한 벤치마크별 분석이 포함되어 있습니다. AI 안전성의 새로운 관점을 제시하는 연구입니다.

참고자료:

답글 남기기