로컬 AI

VLM 실행하기: CPU 최적화부터 클라우드까지

VLM을 실행하는 방법을 완벽 정리했습니다. 다양한 모델 비교부터 Intel CPU 최적화, Ollama Cloud 활용까지 실무에 바로 적용할 수 있는 가이드입니다.

Written by

책상 위의 AI 슈퍼컴퓨터: NVIDIA DGX Spark가 바꾸는 AI 개발 환경

NVIDIA DGX Spark는 128GB 통합 메모리로 200B 파라미터 AI 모델을 책상 위에서 실행할 수 있는 $4,000짜리 소형 AI 슈퍼컴퓨터입니다. 클라우드 비용 부담 없이 로컬에서 AI 개발과 파인튜닝이 가능해진 새로운 개발 환경을 소개합니다.

Written by

Ollama가 로컬 AI의 한계를 깬다: 웹 검색 API로 실시간 정보 접근이 가능해진 이유

로컬 AI 모델의 정보 제한과 환각 문제를 해결하는 Ollama 웹 검색 API 완전 가이드. 실시간 정보 접근부터 검색 에이전트 구축, 개발 도구 통합까지 실용적인 활용법을 제시합니다.

Written by

DeepSeek-R1-0528 모델을 내 컴퓨터에서 실행하기: 715GB 거대 AI 모델의 로컬 구동 완벽 가이드

DeepSeek-R1-0528 대형 AI 모델을 개인 컴퓨터에서 실행하는 완벽 가이드. 715GB 모델을 80% 축소하여 로컬 환경에서 구동하는 방법을 단계별로 설명합니다.

Written by

Ollama의 게임체인저: 스트리밍과 도구 호출을 동시에 지원하는 로컬 AI

Ollama의 새로운 스트리밍 도구 호출 기능을 통해 실시간으로 외부 도구와 상호작용하는 AI 애플리케이션을 구축하는 방법을 상세한 코드 예시와 함께 소개합니다.

Written by

Ollama의 새로운 멀티모달 엔진으로 로컬 AI의 시각적 능력이 한층 강화되다

Ollama가 새로운 멀티모달 엔진을 발표하며 로컬 환경에서 실행 가능한 이미지 인식 AI 모델을 지원합니다. Meta Llama 4, Google Gemma 3 등 최신 멀티모달 모델을 로컬에서 구동할 수 있게 되어 개인정보 보호와 네트워크 연결 없이도 AI의 시각적 능력을 활용할 수 있습니다.

Written by

로컬 LLM을 어디서나 사용하기: Tailscale을 활용한 원격 접근 가이드

로컬에서 운영하는 대규모 언어 모델(LLM)을 Tailscale과 Open WebUI를 이용해 어디서나 안전하게 접근할 수 있는 방법을 단계별로 알아봅니다.

Written by

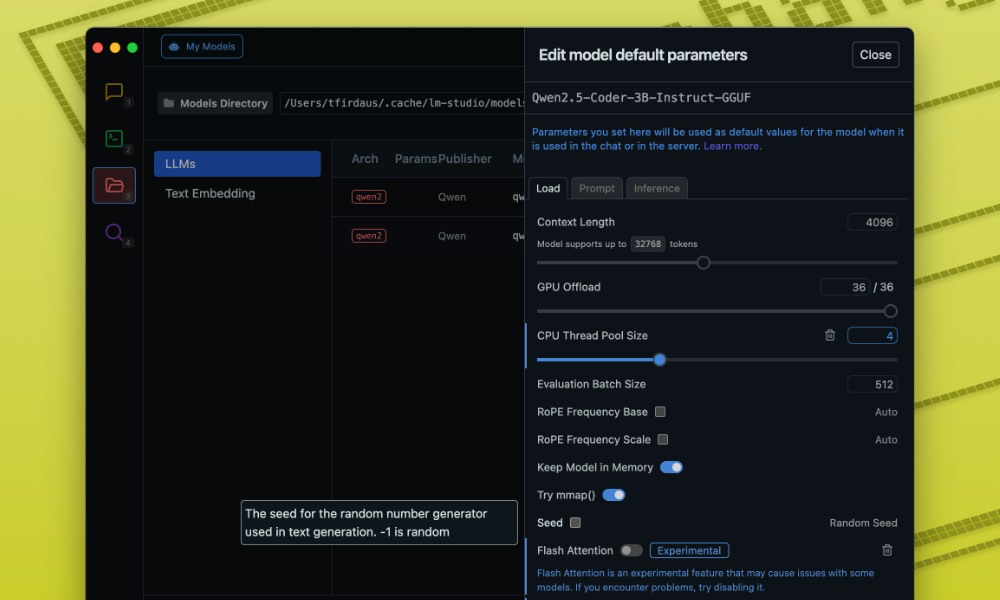

로컬 환경에서 LLM 최적화하기: LM Studio 설정 가이드

개인 컴퓨터에서 대형 언어 모델(LLM)을 효율적으로 실행하기 위한 LM Studio 최적화 가이드. 모델 선택부터 성능 설정까지 자세히 알아봅니다.

Written by