2025년 7-8월, OpenAI의 실험적 기능으로 인해 수만 개의 ChatGPT 대화가 구글에 노출되어 개인 고민부터 기업 기밀까지 민감한 정보가 검색 가능해진 사건이 AI 시대 개인정보보호의 새로운 위험성을 보여줍니다.

작은 체크박스가 만든 큰 문제

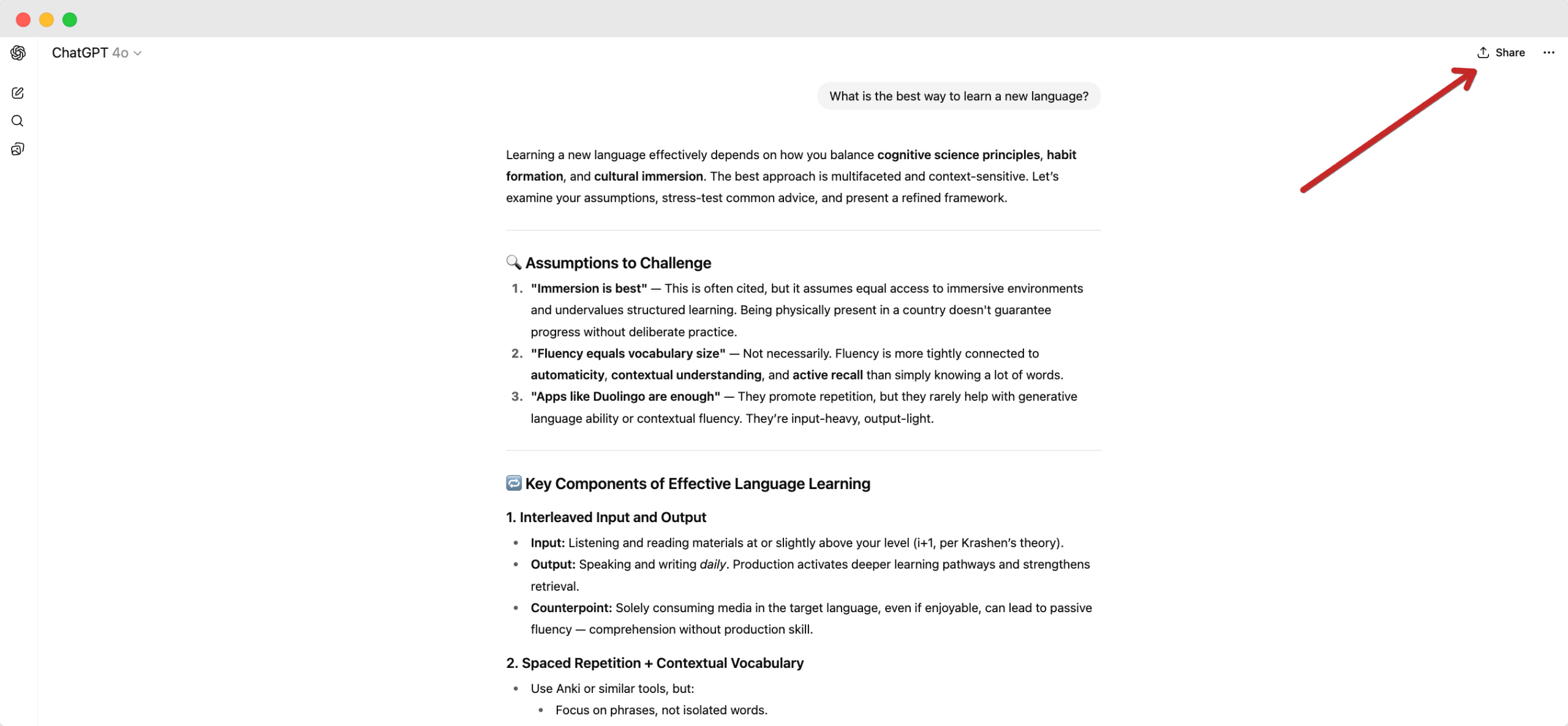

ChatGPT 사용자들이 대화를 공유할 때 나타나는 작은 체크박스 하나가 큰 논란을 불러일으켰습니다. “이 채팅을 검색 가능하게 만들기(Make this chat discoverable)”라는 옵션이었는데, 많은 사용자들이 이것이 무엇을 의미하는지 충분히 이해하지 못한 채 체크했습니다.

그 결과는 충격적이었습니다. 개인적인 고민 상담, 취업 준비 과정, 심지어 학업 부정행위 고백까지 포함된 대화들이 구글 검색 결과에 나타나기 시작했습니다. API 키나 개발자 프롬프트 같은 기술적 정보까지 노출되었습니다.

어떤 정보들이 노출되었나

보안 연구자들이 발견한 노출된 정보의 유형은 다음과 같습니다:

개인적 내용: 정신건강 상담, 중독 문제, 가족 갈등, 진로 고민 등의 매우 사적인 대화들이 실명과 함께 검색 가능한 상태가 되었습니다.

업무 관련 정보: 사업 계획서, 이력서, 면접 준비 내용, 심지어 회사 내부 정보까지 포함된 대화들이 발견되었습니다.

기술적 정보: 개발자들의 API 키, 코드 리뷰, 프로그래밍 관련 민감한 정보들도 노출되었습니다.

OpenAI의 신속한 대응과 남은 문제

OpenAI는 문제가 제기되자 빠르게 행동했습니다. 해당 기능을 즉시 제거하고 구글에 색인된 링크들을 삭제 요청했습니다. 구글도 협조하여 수만 개의 링크가 검색 결과에서 사라졌습니다.

하지만 완전한 해결은 아니었습니다. 인터넷 아카이브(Archive.org)에는 여전히 10만 개 이상의 대화가 보관되어 있으며, OpenAI는 아직 이들의 삭제를 요청하지 않았습니다. 디지털 정보의 영구성을 보여주는 대표적인 사례입니다.

AI 시대 개인정보보호의 새로운 과제

이번 사건이 주는 교훈은 단순한 기술적 실수를 넘어섭니다.

사용자 인터페이스의 중요성: 작은 체크박스 하나가 개인의 사생활을 완전히 공개할 수 있다는 점에서, UI/UX 설계에서 개인정보보호 관련 옵션은 더욱 신중하게 다뤄져야 합니다.

기본값의 힘: 대부분의 사용자는 복잡한 설정을 자세히 읽지 않습니다. 따라서 개인정보보호에 관련된 기능은 기본적으로 ‘비공개’로 설정되어야 합니다.

디지털 발자국의 영구성: 한 번 인터넷에 올라간 정보는 완전히 삭제하기 어렵다는 점을 다시 한번 확인시켜 준 사건입니다.

사용자와 기업이 배워야 할 실용적 교훈

개인 사용자를 위한 가이드:

- AI 도구에 민감한 정보를 입력할 때는 항상 “이것이 공개되어도 괜찮을까?”를 먼저 생각하세요

- 공유 기능을 사용할 때는 모든 옵션을 꼼꼼히 확인하고, 의심스러우면 체크하지 마세요

- 기업용 ChatGPT나 다른 엔터프라이즈 AI 도구 사용을 고려해보세요

기업을 위한 시사점:

- 직원들에게 AI 도구 사용 시 보안 가이드라인을 제공하세요

- 민감한 데이터가 외부 AI 서비스로 유출되지 않도록 DLP(Data Loss Prevention) 도구를 도입하세요

- 제품 설계 시 개인정보보호를 기본값으로 설정하는 ‘Privacy by Design’ 원칙을 적용하세요

더 나은 AI 생태계를 위해

이번 ChatGPT 사건은 AI 기술이 빠르게 발전하는 만큼 개인정보보호 측면에서도 더욱 신중한 접근이 필요함을 보여줍니다. 사용자의 편의성과 개인정보보호 사이의 균형을 찾는 것이 AI 서비스 제공업체들의 중요한 과제가 되었습니다.

앞으로 AI 도구를 사용할 때는 “편리함” 못지않게 “안전함”도 고려해야 하는 시대가 되었습니다. 개인은 더욱 신중하게, 기업은 더욱 책임감 있게 AI 기술을 다뤄야 할 때입니다.

참고자료:

답글 남기기