모두가 차세대 대형 프론티어 모델에 관심을 쏟는 동안, 더 작은 모델들은 종종 간과되곤 합니다. 이제는 32B 파라미터 모델을 소형 언어 모델(SLM)이라고 부르고 있다니, 2021년의 제 생각으로는 상상도 못했을 일입니다.

이러한 소형 모델들은 과도한 양자화 없이도 로컬 환경에서 효과적으로 실행할 수 있습니다. 개인 정보를 대형 AI 기업에 넘기고 싶지 않다면 개인용 LLM이 유용할 수 있으며, 앱을 개발하는 개발자라면 소형 언어 모델을 사용해 비용을 크게 줄일 수 있습니다.

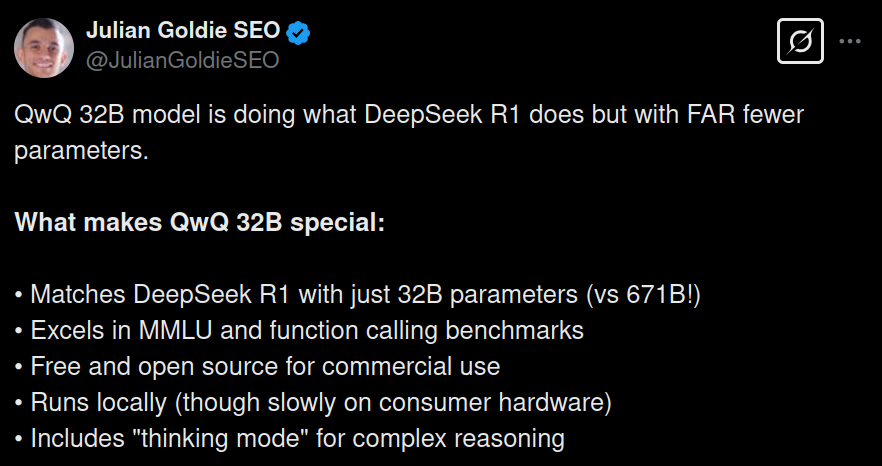

최근 Qwen, Mistral, Google이 각각 QwQ 32B(추론에 특화된 모델), Mistral Small 24B, Gemma 27B(기본 모델)를 출시했습니다. 이들은 서로 다른 아키텍처를 가지고 있지만, Lmsys 리더보드에서 671B 파라미터의 Deepseek R1과 비슷한 점수를 기록하고 있습니다. 심지어 Gemma는 기본 모델임에도 QwQ보다 더 높은 점수를 기록했습니다.

리더보드만으로 모델을 평가하지는 않겠지만, 671B 파라미터를 가진 Deepseek R1이 일반적인 작업에서 항상 우수할 것이라고 확신합니다. 그럼에도 이 세 모델을 비교해보고 싶었습니다. QwQ는 여러 벤치마크에서 Deepseek R1과 비슷한 점수를 기록했으니까요.

이 비교에서 기본 가정은 세 모델이 Deepseek R1보다 성능이 떨어질 것이라는 점이며, R1보다 나은 성능을 보인다면 해당 모델에 점수를 추가하겠습니다.

OpenRouter에서 호스팅하는 모델들을 사용해 비교를 진행했습니다.

간단한 요약(TL;DR)

- QwQ는 전반적으로 세 모델 중 최고입니다.

- 코딩, 추론, 수학에서 선두를 달리지만, 생각하고 말을 많이 하는 경향이 있습니다.

- Gemma 3는 2위로, 훌륭한 모델이지만 제한적인 Gemma 라이센스가 단점입니다.

- Mistral Small 3.1은 대부분의 간단한 작업을 수행할 수 있지만 QwQ에 비해 성능이 떨어집니다.

- 로컬 호스팅을 위한 단일 모델을 선택해야 한다면 QwQ 32B가 최선의 선택입니다.

코딩을 위해서는 QwQ 32B 모델을 선택하세요. 다른 작업에서는 Gemma 3도 동등하게 훌륭하며 작업을 완료할 수 있습니다. Mistral은 이 둘보다 성능이 많이 떨어집니다.

QwQ 32B 모델 소개

알리바바는 3월 첫째 주에 32B 크기의 새로운 모델을 출시했으며, 671B 모델 크기의 Deepseek R1과 견줄 수 있다고 주장했습니다.

이는 모델의 추론 능력을 향상시키기 위해 **강화학습(RL)**을 확장하는 첫 단계입니다.

아래는 QwQ-32B의 성능을 Deepseek R1과 비교한 공개 벤치마크입니다.

자신보다 약 20배 큰 모델인 Deepseek R1과 비교했을 때 흥미로운 결과를 보여주고 있습니다.

Gemma 3 27B 모델 소개

Gemma 3는 Google의 새로운 오픈소스 모델로 Gemini 2.0을 기반으로 합니다. 이 모델은 4가지 크기(1B, 4B, 12B, 27B)로 제공됩니다.

Google은 이 모델을 **”단일 GPU나 TPU에서 실행할 수 있는 가장 강력한 모델”**이라고 소개합니다. 즉, 제한된 리소스를 가진 기기에서도 실행 가능하다는 의미입니다.

128K 컨텍스트 윈도우를 지원하고 140개 이상의 언어를 지원하며, 주로 추론 작업을 위해 설계되었습니다.

Mistral Small 3.1 24B 소개

Mistral의 신규 모델로, 멀티모달 이해 능력과 최대 128k 토큰의 확장된 컨텍스트 윈도우를 갖추고 있습니다. Mistral은 이 모델이 Gemma 27B와 GPT-40 mini를 능가했다고 주장합니다.

코딩 능력 테스트

1. 알파벳으로 이루어진 회전하는 3D 구

프롬프트: 알파벳으로 구성된 회전하는 3D 구의 JavaScript 시뮬레이션을 만드세요. 가장 가까운 글자는 더 밝게, 가장 먼 글자는 회색으로 표시되어야 합니다.

QwQ 32B의 응답 요청한 모든 것(애니메이션, 회전하는 글자, 색상 변화)을 완벽하게 구현했습니다. 결과물이 매우 훌륭했습니다!

Gemma 3 27B의 응답 프롬프트를 완전히 따르지는 않았습니다. 무언가 작동했지만, 3D 구에 알파벳이 회전하는 효과는 구현하지 못했습니다.

Mistral의 응답 형편없었습니다. 빈 화면만 표시되었습니다.

Deepseek R1의 응답 요청한 내용을 정확하게 구현했지만, QwQ 32B 모델의 출력과 비교했을 때 전반적인 품질이 떨어졌습니다.

요약: 이 섹션에서 QwQ 32B 모델이 확실한 승자입니다. 애니메이션 테스트에서 압도적인 성능을 보였고, Deepseek R1보다 더 나은 결과를 보여주었습니다. Gemma와 Mistral은 평균 이하의 성능을 보였습니다. QwQ에 1점을 추가합니다.

2. 리트코드 문제 해결

매우 어려운 리트코드 문제로 모델들의 코딩 능력을 테스트했습니다. **통과율 14.4%**의 Strong Password Checker 문제를 사용했습니다.

QwQ 32B의 응답 QwQ는 정답을 정확하게 맞추었습니다. O(N) 시간 복잡도로 전체 코드를 작성했으며, 코드 품질도 양호했습니다. 생각하는 시간이 오래 걸렸지만, 작동하는 답안을 제공했다는 점이 중요합니다.

Gemma 3 27B의 응답 Gemma 3는 54개 중 39개 테스트 케이스만 통과했습니다. 오픈소스이고 27B 파라미터만 사용하며 단일 GPU 또는 TPU에서 작동한다는 점을 고려하면 나쁘지 않은 성과입니다.

Mistral의 응답 19개 테스트 케이스만 통과했습니다.

Deepseek R1의 응답 54개 중 51개 테스트 케이스를 통과했지만, 하나의 테스트 케이스 실패도 오답으로 처리됩니다.

요약: 두 가지 코딩 문제를 비교한 결과, QwQ 32B 모델이 승자입니다. Gemma 3 27B는 시도했지만 고급 코딩에 사용하기에는 부족합니다. Mistral도 실패했습니다. QwQ에 2점을 추가합니다.

추론 능력 테스트

1. 과일 교환 문제

간단한 상식 문제로 모델들의 추론 능력을 테스트했습니다.

프롬프트: 당신은 14개의 사과로 시작합니다. Emma가 3개를 가져가고 2개를 돌려줍니다. 당신은 7개를 떨어뜨리고 4개를 주웁니다. Leo가 4개를 가져가고 5개를 제공합니다. 당신은 Emma에게서 사과 1개를 가져와 Leo와 사과 3개로 교환한 다음, 그 3개를 Emma에게 주면 Emma는 사과 1개와 오렌지 1개를 당신에게 줍니다. Zara는 당신의 사과를 가져가고 배 1개를 줍니다. 당신은 배를 Leo와 사과 1개로 교환합니다. 나중에 Zara는 사과를 오렌지와 교환하고 그것을 당신과 다른 사과로 교환합니다. 당신은 몇 개의 배를 가지고 있나요? 질문된 것만 답하세요.

이 질문의 목적은 모델이 불필요한 정보를 걸러내고 질문된 내용만 답할 수 있는지 테스트하는 것이었습니다. 정답은 배 0개입니다.

모든 모델이 이 문제에서 불필요한 정보를 모두 계산하고 정답을 찾았지만, “질문된 것만 답하세요”라는 지시를 완전히 따르지는 못했습니다. 모든 모델에 0점을 부여합니다.

2. 엘리베이터의 여성

프롬프트: 대머리에 마른 여성이 아파트 78층에 살고 있습니다. 맑은 날에는 엘리베이터를 타고 67층까지 올라간 다음 나머지는 걸어서 올라갑니다. 비 오는 날에는 엘리베이터를 타고 바로 자신의 층으로 올라갑니다. 왜 비 오는 날에는 엘리베이터를 타고 자신의 층으로 올라갈까요?

이 질문은 모델을 혼란스럽게 하기 위해 불필요한 세부 정보를 포함했습니다. 정답은 여성이 키가 작아서 평소에는 높은 버튼에 닿을 수 없지만, 비 오는 날에는 우산을 이용해 엘리베이터 버튼을 누를 수 있다는 것입니다.

모든 모델이 이 문제를 정확하게 풀었습니다. 각 모델에 1점씩 추가합니다.

수학 능력 테스트

1. 시계 바늘이 직각을 이루는 시간

프롬프트: 5시 30분에서 6시 사이에 시계의 바늘이 직각을 이루는 시간은 언제입니까?

QwQ 32B와 Gemma 3 27B, Deepseek R1은 모두 정확한 답을 제공했지만, Mistral은 약간 오차가 있었습니다. QwQ, Gemma, Deepseek R1에 각각 1점씩 추가합니다.

2. 문자 배열 문제

프롬프트: ‘MATHEMATICS’ 단어의 글자를 모음이 항상 함께 오도록 배열하는 방법은 몇 가지입니까?

모든 모델이 이 어려운 수학 문제를 정확하게 풀었습니다. 각 모델에 1점씩 추가합니다.

최종 평가

새로운 Qwen 모델은 정말 인상적이며, Gemma도 마찬가지지만 Gemma 오픈소스 라이센스가 유일한 문제점입니다. Qwen은 크기와 성능 사이의 적절한 균형점을 찾은 것 같습니다.

Gemma 3는 확실히 견고한 기본 모델입니다. Google은 대형 모델(Gemini 2.0)을 Gemma와 Flash 같은 소형 모델로 증류하는 기술을 완성했습니다. Mistral은 다소 실망스러웠으며, Qwen과 Gemma에 비해 성능이 떨어졌습니다.

어떤 모델을 선택해야 할까요?

- 코딩 작업에는 QwQ 32B가 더 좋습니다.

- 추론과 수학에서도 Qwen이 더 우수하지만, Gemma도 나쁘지 않습니다.

- Gemma와 Mistral Small은 이미지 입력을 지원하므로 큰 장점이 있습니다.

- QwQ와 Mistral은 더 허용적인 Apache 2.0 라이센스를 사용하는 반면, Gemma는 다소 제한적인 Google Gemma 라이센스를 사용합니다.

- 전반적으로 QwQ 32B가 압도적으로 승리하며, 컴팩트한 크기에서 Deepseek R1과 비슷한 성능을 보여줍니다.

소형 언어 모델을 선택할 때는 사용 목적, 필요한 기능, 라이센스 등을 고려해야 합니다. 로컬 호스팅을 위한 최고의 선택은 QwQ 32B이며, 이미지 처리가 필요하다면 Gemma나 Mistral을 고려해볼 수 있습니다. 라이센스 제한에 민감하다면 QwQ나 Mistral이 더 적합할 것입니다.

참고자료: Gemma 3 27b vs. QwQ 32b vs. Mistral 24b vs. Deepseek r1

답글 남기기