GPT-5 모델들이 RAG 시스템에서 보여준 가장 인상적인 변화는 “모르겠다”고 솔직하게 답변하는 능력이 크게 향상되어 할루시네이션 문제를 효과적으로 줄였다는 점입니다.

OpenAI가 지난주 발표한 GPT-5 모델 패밀리는 정확한 도구 호출과 할루시네이션 감소에 중점을 둔 새로운 모델입니다. 특히 RAG(Retrieval-Augmented Generation) 시스템을 구축하는 개발자들에게는 할루시네이션을 줄이기 위해 특별히 훈련된 모델이라는 점이 매우 흥미로운 소식이었습니다.

GPT-5 패밀리, 어떤 모델들이 있나?

GPT-5 패밀리는 총 5가지 변형으로 구성되어 있습니다:

gpt-5: 272k 토큰 컨텍스트를 가진 완전한 추론 모델로, 코드 생성과 복잡한 분석 작업에 최적화되어 있습니다.

gpt-5-mini: 실시간 앱과 에이전트를 위한 모델로, 추론과 도구 호출 기능을 제공합니다.

gpt-5-nano: 초저지연에 특화된 새로운 클래스의 추론 모델입니다.

gpt-5-chat: 추론 모델이 아닌 채팅 애플리케이션에 최적화된 모델로, 128k 토큰 컨텍스트를 지원합니다.

gpt-5-pro: ChatGPT에서만 사용 가능하며 API로는 제공되지 않습니다.

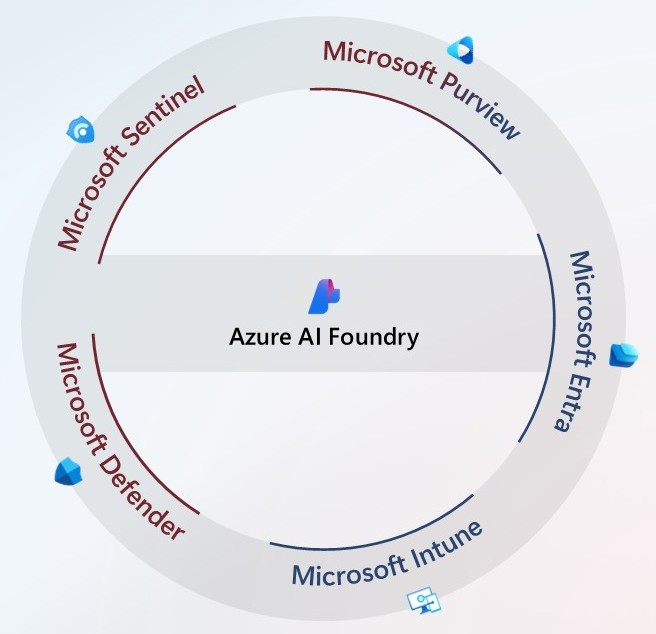

Azure AI Foundry에서 GPT-5 모델들이 출시되자마자, 마이크로소프트의 팸 폭스(Pamela Fox)는 자사의 인기 오픈소스 RAG 템플릿에서 이 모델들을 테스트했습니다. 그 결과는 단순히 질문에 답변하는 능력보다는 답변할 수 없는 질문을 인정하는 능력에서 더욱 인상적이었습니다.

“모르겠다”고 말할 수 있는 용기

기존 모델들이 가진 가장 큰 문제 중 하나는 충분한 정보가 없을 때도 그럴듯한 답변을 만들어내는 할루시네이션 현상이었습니다.

테스트에 사용된 질문 중 하나는 “프로덕트 매니저는 무엇을 하나요?”였습니다. 얼핏 쉬워 보이는 질문이지만, 실제 회사 문서에는 “프로덕트 매니저” 직무 설명이 없고 “시니어 프로덕트 매니지먼트 매니저”와 같은 관련 직무만 있었습니다.

추론 모델을 포함한 기존 모든 모델들은 이 질문에 대해 그럴듯한 답변을 만들어냈습니다. 하지만 GPT-5는 달랐습니다.

GPT-5는 필요한 정보가 없다는 것을 인지하고 답변할 수 없다고 명확히 응답했습니다. 잘못된 답변을 만들어내는 것보다 모른다고 인정하는 것이 훨씬 나은 선택입니다.

50개 Q&A로 본 종합 성능 비교

개별 사례만으로는 부족하기 때문에, azure-ai-evaluations SDK를 사용해 50개의 Q&A 쌍으로 종합적인 평가를 진행했습니다. 주요 평가 지표는 다음과 같습니다:

- Groundedness: 답변이 검색된 결과에 근거했는지 (LLM 판단)

- Relevance: 답변이 질문에 완전히 답했는지 (LLM 판단)

- Citations_matched: 정답 인용문과 일치하는지 (정규표현식 기반)

평가 결과는 다음과 같습니다:

| 모델 | Groundedness (통과율) | Relevance (통과율) | 답변 길이 | 지연시간 |

|---|---|---|---|---|

| gpt-5 | 100% 🏆 | 90% | 844자 | 9.6초 |

| gpt-5-mini | 94% | 74% | 990자 | 7.5초 |

| gpt-5-chat | 96% | 90% | 549자 | 2.9초 |

| gpt-4.1-mini | 94% | 94% 🏆 | 829자 | 2.9초 |

GPT-5가 Groundedness에서 완벽한 100% 점수를 기록한 것은 매우 인상적입니다. 이는 답변이 모두 검색된 자료에 근거했다는 의미입니다.

Relevance 점수가 기존 모델보다 낮은 이유는 GPT-5가 확신이 없을 때 부분적인 답변을 제공하거나 아예 답변을 거부하는 경향이 있기 때문입니다. RAG 시스템에서는 이런 신중함이 오히려 장점이 될 수 있습니다.

GPT-5만의 특별한 답변 패턴들

“모르겠다”고 답변하는 빈도 증가

50개 질문 중 “모르겠다”로 시작한 답변 비율을 보면:

- gpt-5-mini: 10개 (20%)

- gpt-5: 3개 (6%)

- gpt-4.1-mini: 1개 (1.6%)

- gpt-5-chat: 1개 (1.6%)

이는 GPT-5 추론 모델들이 시스템 프롬프트의 “충분한 정보가 없으면 모른다고 하라”는 지시를 더 잘 따르고, 할루시네이션을 줄이기 위한 특별한 정렬 과정을 거쳤기 때문으로 보입니다.

명확한 질문을 요청하는 능력

흥미롭게도 gpt-5-chat은 50개 질문 중 2개에서 사용자에게 명확한 질문을 요청했습니다:

질문: “워싱턴 밖에서 Northwind Health 서비스가 필요하면 어떻게 해야 하나요?”

기존 모델 답변: 가능한 모든 시나리오를 다 설명하는 긴 답변

gpt-5-chat 답변: “어떤 플랜을 사용하고 계시나요? Northwind Standard인가요, Northwind Health Plus인가요?”

사용자의 구체적인 상황에 맞는 맞춤형 답변을 제공하려는 접근 방식입니다.

목록 형태 답변 선호

GPT-5 추론 모델들은 목록 형태로 답변하는 경향이 강했습니다:

- gpt-5: 36개 (72%)

- gpt-5-mini: 26개 (52%)

- gpt-4.1-mini: 0개

- gpt-5-chat: 0개

목록 형태가 나쁜 것은 아니지만, 원하는 스타일이 아니라면 시스템 프롬프트에 별도 지시를 추가하거나 gpt-5-chat을 고려해볼 수 있습니다.

실무 적용을 위한 고려사항

지연시간과 비용

GPT-5 추론 모델들은 지연시간이 높습니다. 특히 실시간 스트리밍 채팅에서는 첫 번째 토큰까지의 시간이 중요한데, 이 부분에서 최적화가 필요할 수 있습니다.

답변 길이 조절

새로운 verbosity 파라미터를 통해 답변의 장황함을 조절할 수 있습니다. 기본값은 “medium”이며, “low”로 설정하면 더 간결한 답변을 얻을 수 있습니다.

모델 선택 가이드

- 정확성이 최우선: gpt-5 (100% groundedness)

- 빠른 응답 필요: gpt-5-chat (짧은 지연시간)

- 비용 효율성: gpt-5-mini (적절한 성능과 비용)

- 초저지연: gpt-5-nano (간단한 Q&A용)

실제 정확성은 어떨까?

LLM이 판단한 100% groundedness 점수가 실제 정확성을 보장하지는 않습니다. 진정한 정확성 검증은 해당 분야 전문가가 직접 확인해야 합니다.

팸 폭스는 자신의 개인 블로그 데이터로 같은 평가를 진행했고, GPT-5의 200개 답변을 검토한 결과 부정확한 답변을 발견하지 못했다고 합니다. “모르겠다”고 답하거나 명확한 질문을 요청하는 것도 잘못된 정보를 퍼뜨리지 않는다는 점에서 정확한 답변으로 볼 수 있습니다.

개발자를 위한 평가 방법

자신의 도메인에서 GPT-5 모델들을 평가하려면:

Azure RAG 템플릿 사용자: 평가 가이드를 따라 GPT-5 모델을 배포하고 테스트해보세요.

독립적인 솔루션: azure-ai-evaluation, DeepEval, promptfoo 같은 오픈소스 SDK를 활용하거나 Langfuse, Arize, Langsmith 같은 관찰 플랫폼의 내장 평가 기능을 사용하세요.

정리

GPT-5 패밀리는 RAG 시스템에서 중요한 진전을 보여줍니다. 가장 주목할 점은 모르는 것을 솔직하게 인정하는 능력의 향상입니다. 이는 신뢰할 수 있는 AI 시스템 구축에 핵심적인 요소입니다.

완벽한 모델은 아니지만, 할루시네이션 문제 해결과 더 신중한 답변 생성이라는 측면에서 RAG 시스템의 새로운 가능성을 제시합니다. 자신의 도메인에서 직접 평가해보고 도메인 전문가와 함께 답변의 정확성을 검증하는 것이 가장 중요합니다.

참고자료:

답글 남기기