RAG 시스템의 성능을 좌우하는 것은 임베딩 모델도, LLM도 아닌 문서를 어떻게 나누느냐입니다. 잘못된 청킹 전략 하나로 RAG 정확도가 40-60%까지 떨어질 수 있으며, 아무리 뛰어난 AI 모델을 사용해도 문서가 엉터리로 나뉘어 있다면 소용이 없습니다.

핵심 포인트:

- 의미 기반(Semantic) 청킹은 정확도에서 15-25% 우수하지만 계산 비용이 3-5배 높음: 고가치 문서나 높은 정확도가 필요한 경우에만 사용

- 대부분의 프로덕션 환경에는 재귀적(Recursive) 청킹이 최적: 400-800 토큰 크기에 20% 오버랩으로 성능과 효율의 균형 확보

- 문서 유형별 맞춤 전략이 필수: FAQ는 200-400 토큰, 기술 문서는 600-1200 토큰, 법률 문서는 800-1500 토큰으로 설정해야 최적 성능 발휘

청킹이 RAG의 성패를 좌우하는 이유

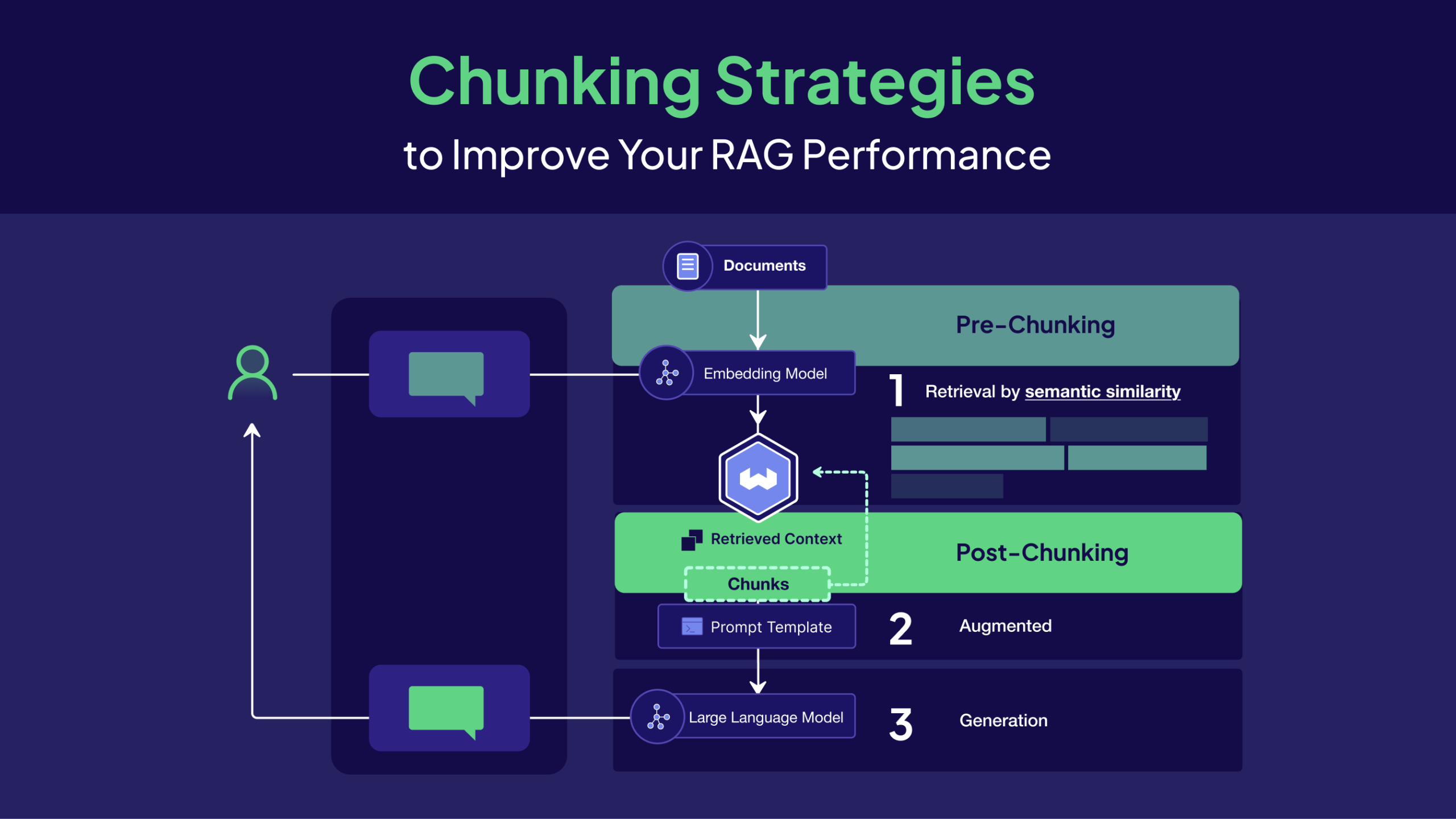

언어 모델은 제한된 컨텍스트 윈도우를 가지고 있지만, 처리해야 할 지식베이스는 방대합니다. 청킹은 이 격차를 메우는 핵심 기술이에요. 문서를 의미적으로 일관된 조각으로 나누면서도 처리 가능한 크기로 맞춰야 합니다.

연구 결과를 보면 청킹 품질이 RAG 성능에 미치는 영향은 명확합니다. 잘못된 청킹은 정확도를 절반 이하로 떨어뜨리고, 적절한 10-20% 오버랩은 검색 재현율을 15-30% 향상시킵니다. 무엇보다 최적 청크 크기는 도메인마다 다릅니다.

5가지 핵심 청킹 전략

1. 고정 크기(Fixed-Size) 청킹: 가장 빠르고 단순한 선택

텍스트를 균일한 크기로 자르는 가장 기본적인 방식입니다. 문자 수, 단어 수, 토큰 수를 기준으로 일정하게 나눕니다.

언제 사용할까요?

- 뉴스 기사나 블로그 포스트 같은 동질적인 문서

- 대량 처리가 필요해서 계산 효율이 중요한 경우

- 초기 프로토타입 단계에서 기준선을 잡을 때

성능 특성:

- 처리 속도: 초당 약 1000개 문서 처리 (매우 빠름)

- 정확도: 기준선 수준, 의미 기반 방식보다 10-20% 낮음

- 컨텍스트 보존: 문장이나 개념 중간에서 자주 끊김

고정 크기 청킹의 가장 큰 문제는 내용을 무시한다는 점입니다. 중요한 문장 중간에 끊기거나 하나의 개념이 여러 청크로 흩어질 수 있어요.

2. 재귀적(Recursive) 청킹: 균형 잡힌 실전 선택

계층적 구분자를 사용해 자연스러운 문서 구조를 유지하면서 크기 제약을 지킵니다. ["\n\n", "\n", " ", ""] 같은 구분자 계층을 따라 나눕니다.

성능 장점:

- 컨텍스트 보존: 고정 크기보다 25-40% 우수

- 의미적 일관성: 단락과 문장 경계를 존중

- 범용성: 최소한의 튜닝으로 다양한 문서에 적용 가능

활용 팁:

- 문자 수 대신 토큰 기반 측정 사용

- 문서 구조에 맞춰 구분자 조정 (마크다운, HTML, 일반 텍스트)

- 특정 콘텐츠에 맞는 구분자 계층 테스트

재귀적 청킹은 대부분의 프로덕션 RAG 시스템에 가장 적합합니다. 성능과 효율의 스위트 스팟을 제공하거든요.

3. 의미 기반(Semantic) 청킹: 최고 정확도가 필요할 때

인접한 문장 간 의미 유사도를 기반으로 텍스트를 나눕니다. 관련 내용을 함께 유지하는 가장 정교한 접근법입니다.

해결하는 문제:

전통적인 청킹은 구조(단락, 문장)나 임의 크기로 나누지만, 단락 중간이나 경계를 넘어 발생하는 의미 전환을 놓칩니다. 의미적으로 연관된 내용이 여러 청크로 흩어지는 거죠.

성능 특성:

- 검색 정확도: 고정 크기 대비 15-25% 향상

- 계산 비용: 전통적 방식보다 3-5배 높음

- 처리 시간: 문서당 10-50초 (단순 방식은 밀리초)

- 컨텍스트 일관성: 우수함 – 주제 일관성 유지, 무관한 정보 감소

언제 비용을 감수할 가치가 있을까요?

- 의료 진단, 법률 조사, 금융 분석 같은 고위험 애플리케이션

- 주제 전환이 잦은 학술 논문, 연구 보고서, 기술 사양서

- 15-25% 정확도 향상이 3-5배 처리 비용을 정당화하는 도메인

제약회사 사례를 보면, 5만 개의 연구 논문에 의미 기반 청킹을 적용했더니 처리 시간은 2시간에서 8시간으로 늘었지만, “당뇨병이 있는 고령 환자에서 ACE 억제제의 부작용은 무엇인가?” 같은 복잡한 질문의 정확도가 78%에서 94%로 급등했습니다.

4. 문서 구조 인식(Document-Aware) 청킹: 구조화된 콘텐츠의 필수 선택

헤더, 테이블, 리스트, 코드 블록 같은 문서 구조를 보존합니다.

필수적인 경우:

- 코드 예제가 있는 기술 문서

- 구조화된 섹션이 있는 법률 문서

- 그림과 테이블이 있는 학술 논문

- 단계별 절차가 있는 매뉴얼

구조화된 콘텐츠에서 문서 인식 청킹은 도메인별 정확도를 40% 이상 향상시킬 수 있습니다. 테이블을 중간에 자르거나 코드 블록을 분리하면 정보가 완전히 왜곡되기 때문입니다.

5. LLM 기반(Agentic) 청킹: 최고 품질이 필요한 소량 문서용

LLM을 사용해 의미 이해와 콘텐츠 분석을 바탕으로 최적의 청크 경계를 결정합니다.

장단점:

- 정확도: 최고 수준의 의미적 일관성

- 비용: 전통적 방식보다 10-50배 비쌈

- 지연 시간: 상당한 전처리 지연 발생

- 활용 사례: 고가치 문서, 복잡한 도메인별 콘텐츠

문서 유형별 최적 청킹 전략

여기가 가장 실용적인 부분입니다. 어떤 문서에 어떤 전략을 써야 할까요?

FAQ와 고객 지원 문서

- 최적 크기: 200-400 토큰

- 오버랩: 10-15%

- 전략: 질문-답변 보존에 초점을 둔 문장 기반

- 이유: 사용자는 완전한 답변이 필요하지 조각난 정보가 아님

짧고 직접적인 응답이 중요한 FAQ에서는 단순한 전략이 오히려 효과적입니다. 각 질문과 답변 쌍을 하나의 청크로 유지하세요.

기술 문서

- 최적 크기: 600-1200 토큰

- 오버랩: 20-25%

- 전략: 코드 블록 보존을 포함한 문서 인식

- 이유: 기술 개념은 이해를 위해 더 많은 컨텍스트 필요

코드 예제가 중간에 끊기면 완전히 무용지물이 됩니다. 코드 블록 전체를 하나의 단위로 유지하는 문서 인식 청킹이 필수입니다.

법률 문서

- 최적 크기: 800-1500 토큰

- 오버랩: 25-30%

- 전략: 조항 보존을 포함한 구조 인식

- 이유: 법률 개념은 복잡하고 참조가 여러 섹션에 걸침

법률 문서는 특히 까다롭습니다. 하나의 조항이나 규정이 문서 전체에 걸쳐 참조되기 때문에 높은 오버랩이 필수입니다.

뉴스와 블로그 포스트

- 최적 크기: 400-600 토큰

- 오버랩: 15-20%

- 전략: 단락 기반 청킹

- 이유: 편집 구조가 이미 가독성에 최적화됨

뉴스 기사는 이미 읽기 좋게 구성되어 있습니다. 단락을 존중하는 재귀적 청킹이면 충분합니다.

학술 논문

- 최적 크기: 1000-2000 토큰

- 오버랩: 30% 이상

- 전략: 그림/테이블 보존을 포함한 섹션 인식

- 이유: 학술 개념은 점진적으로 구축되어 광범위한 컨텍스트 필요

학술 논문에서는 큰 청크와 높은 오버랩이 필요합니다. 연구 방법론이나 결과가 여러 섹션에 걸쳐 설명되는 경우가 많거든요.

프로덕션 구현 체크리스트

실전에서 청킹 전략을 적용할 때 확인해야 할 사항들입니다.

1단계: 기준선 설정 (1-2주차)

재귀적 청킹으로 시작하세요. 400 토큰 청크, 20% 오버랩으로 설정하고 테스트 데이터셋으로 성능 기준선을 확립합니다.

2단계: 최적화 (3-4주차)

문서 유형별로 다른 청크 크기를 A/B 테스트하고, 구조화된 콘텐츠에는 문서 인식 청킹을 구현하세요. 검색 성능을 바탕으로 오버랩 비율을 최적화합니다.

3단계: 고급 기능 (5-6주차)

고가치 콘텐츠에 의미 기반 청킹을 실험하고, 검색 개선을 위해 컨텍스트 강화를 구현합니다. 프로덕션용 캐싱과 배치 처리를 배포하세요.

성능 최적화 팁:

- 배치 처리로 여러 문서를 병렬 처리

- 청킹 결과를 캐싱해 반복 작업 방지

- 토큰 제한 초과, 불완전한 문장, 최소 길이 미달 등을 자동 검증

전략 선택 가이드

결국 어떤 청킹 전략을 선택할까요? 의사결정 프레임워크를 제시합니다.

처리량이 많고 속도가 중요하다면: 고정 크기 또는 재귀적 청킹

정확도가 최우선이라면: 의미 기반 또는 LLM 기반 청킹

혼합 콘텐츠를 다룬다면: 모달리티별 또는 하이브리드 청킹

대규모 시스템이라면: 재귀적 또는 하위 문서 청킹

대부분의 경우 400-800 토큰의 재귀적 청킹이 정답입니다. 성능의 80%를 비용의 20%로 얻을 수 있거든요. 의미 기반 청킹은 정확도가 중요한 고가치 콘텐츠에만 예약하세요.

청킹은 RAG 시스템의 기초입니다. 단순하게 시작하고, 실제 결과를 측정하며, 이론적 최적화보다는 실제 성능을 바탕으로 반복하세요. 콘텐츠 유형과 정확도 요구사항에 맞춰 전략을 선택하는 것이 성공의 열쇠입니다.

참고자료:

답글 남기기