Meta의 슈퍼인텔리전스 연구소(MSL)가 첫 논문으로 RAG 효율화 기술 REFRAG를 발표했습니다. 응답 속도를 30배 개선하면서도 정확도 손실이 없는 이 기술은 “임베딩을 텍스트로 변환했다가 다시 임베딩으로 되돌리는” 근본적 비효율을 제거했습니다. 거물급 연구자들이 모인 연구소가 화려한 모델 혁신 대신 실용적 최적화를 선택한 이유는 무엇일까요?

핵심 포인트:

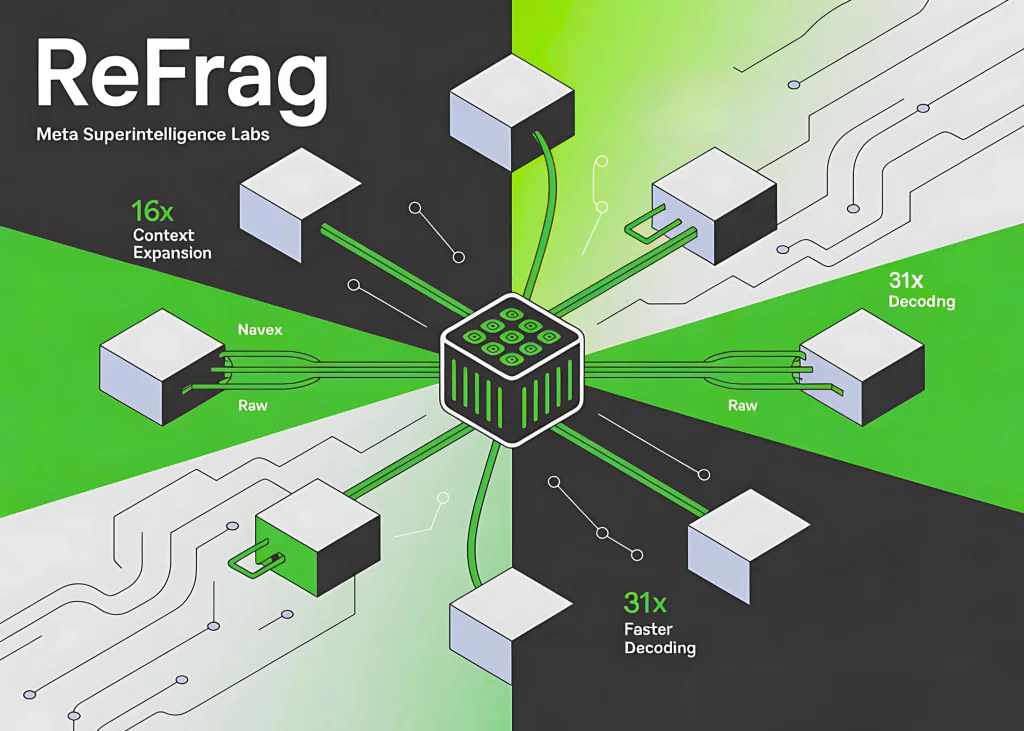

- 30.85배 빠른 첫 토큰 생성: 기존 RAG 시스템 대비 시퀀스 길이를 16분의 1로 압축하여 응답 지연시간 획기적 단축

- 정확도 손실 없는 압축: 강화학습 기반 정책으로 중요 청크만 선택적 확장하여 핵심 정보 보존

- 16배 확장된 컨텍스트: 동일한 메모리로 16배 더 긴 문서 처리 가능, 대규모 문서 분석과 멀티턴 대화 성능 향상

슈퍼인텔리전스 연구소의 선택

2025년 6월, Mark Zuckerberg는 Meta 슈퍼인텔리전스 연구소(MSL) 설립을 발표했습니다. Scale AI의 전 CEO Alexandr Wang을 AI 총괄 책임자로, GitHub의 전 CEO Nat Friedman을 제품 및 응용 연구 책임자로 영입했죠. OpenAI와 Google DeepMind에서 GPT-4o, Gemini 시리즈를 만든 핵심 연구자들까지 합류했습니다.

업계는 이들이 차세대 파운데이션 모델이나 새로운 아키텍처를 발표할 거라 예상했습니다. 하지만 9월 1일 공개된 첫 논문의 주제는 RAG 효율화였습니다. 화려한 모델 혁신 대신 실무자들이 당장 겪는 문제에 집중한 거죠.

이 선택은 전략적입니다. RAG는 현재 AI 에이전트, 검색, 고객지원 시스템의 핵심 기술입니다. 이미 수많은 기업이 RAG 파이프라인을 운영 중이고 실제 매출이 연결되어 있죠. 여기서 비용과 지연시간을 개선하면 즉각적인 ROI가 발생합니다.

RAG의 근본적 비효율

기존 RAG 시스템은 치명적 비효율을 안고 있습니다. 검색된 문서를 텍스트 토큰으로 LLM에 전달하면, LLM은 이를 다시 임베딩으로 변환해 처리합니다. 이미 벡터 형태로 저장된 정보를 텍스트로 바꿨다가 다시 벡터로 되돌리는 셈이죠.

문제는 여기서 그치지 않습니다. Attention 메커니즘은 입력 길이에 제곱으로 비례해 계산량이 증가합니다. 문서가 두 배 길어지면 계산 비용은 네 배로 늘어나죠. 검색된 문서 대부분은 최종 답변에 거의 기여하지 않는데도 말입니다.

REFRAG의 해법

REFRAG는 이 문제를 정면으로 해결합니다. 핵심은 간단합니다. 검색된 문서를 작은 청크(16~32토큰)로 나누고, 각 청크를 하나의 밀집 임베딩으로 압축하는 거죠. 이 청크 임베딩을 LLM이 직접 처리할 수 있게 만듭니다.

여기서 강화학습 기반 정책이 작동합니다. 모든 청크를 압축하지 않고, 답변에 중요한 청크만 골라 원래 토큰 형태로 확장합니다. 숫자나 고유명사 같은 핵심 정보는 보존하면서도 전체 시퀀스 길이를 16분의 1로 줄이는 거죠.

결과는 놀랍습니다. SlimPajama 데이터셋 200억 토큰으로 사전학습한 REFRAG는 LLaMA-2 대비 30.85배 빠른 첫 토큰 생성 속도를 보였습니다. 처리량도 6.78배 향상됐죠. 기존 최고 성능이던 CEPE(2~8배 개선)를 크게 앞선 수치입니다.

실전 성능 검증

Meta 연구팀은 Book, arXiv, PG19, ProofPile 등 다양한 장문 데이터셋으로 REFRAG를 검증했습니다. RAG 벤치마크, 멀티턴 대화, 문서 요약 작업 모두에서 기존 베이스라인을 앞섰죠.

특히 주목할 점은 약한 검색기(weak retriever) 환경에서의 성능입니다. 관련 없는 문서가 많이 섞여 있을 때, REFRAG는 동일한 지연시간 예산으로 더 많은 문서를 처리할 수 있어 정확도가 오히려 향상됐습니다. 컨텍스트를 16배 확장할 수 있다는 건 실무에서 큰 의미를 갖습니다. 전체 보고서를 한 번에 분석하거나 긴 대화 이력을 유지하는 게 가능해진 거죠.

Perplexity도 개선됐습니다. CEPE 대비 평균 9.3% 낮은 perplexity를 기록하며 정확도 면에서도 우위를 보였습니다.

실무 적용 시 고려사항

REFRAG가 완벽한 건 아닙니다. 먼저 엔코더와 투영 레이어를 추가 학습해야 하고, 선택적 확장 정책도 강화학습으로 훈련해야 합니다. 개발 복잡도가 높아지는 셈이죠.

압축률도 트레이드오프가 있습니다. 지나치게 공격적으로 압축하면 결국 품질이 떨어집니다. 작업 특성에 맞는 압축 예산을 찾아야 하죠. 특히 법률 추론이나 의료 정보처럼 정밀도가 중요한 영역에서는 신중한 평가가 필요합니다.

사전 계산된 청크 임베딩은 정적 데이터에 최적화되어 있습니다. 자주 변경되는 데이터라면 임베딩을 계속 재계산하거나 하이브리드 전략을 써야 합니다.

하지만 이런 한계에도 불구하고 REFRAG는 프로덕션 파일럿 대상으로 충분히 매력적입니다. GPU당 처리 쿼리 수가 늘고 인프라 비용이 줄어들며 사용자 경험도 개선됩니다. 더 나은 리랭커나 검색기와 조합하면 효과는 더 커지죠.

더 큰 모델이 아닌 더 똑똑한 설계

REFRAG가 주는 메시지는 명확합니다. 돌파구가 항상 더 큰 모델에서 나오는 건 아닙니다. RAG를 더 저렴하고 빠르게 만드는 것, 그게 제품 경제성에 직접 영향을 미치는 레버죠.

MSL이 첫 논문으로 RAG 효율화를 선택한 건 “오늘 당장 ROI가 나는 문제”에 집중하겠다는 전략적 선언입니다. 파운데이션 모델 혁신은 고위험 고수익이지만 긴 타임라인이 필요합니다. 반면 시스템 레벨 효율화는 즉각적으로 수익화가 가능하죠.

벡터 DB 시장이 격변기를 맞은 시점도 흥미롭습니다. 선두주자 Pinecone은 매각을 검토 중이고, DeepMind의 최근 연구는 임베딩 기반 검색의 이론적 한계를 지적했습니다. REFRAG는 이런 한계를 우회하는 새로운 접근법을 제시합니다.

Meta 연구팀은 곧 GitHub에 코드를 공개할 예정입니다. RAG 기반 서비스를 운영하는 팀이라면 주목할 만합니다. 첫 토큰 생성 시간, 처리량, 쿼리당 비용을 측정해보세요. 개선 여지가 보인다면 프로덕션 파일럿을 고려해볼 시점입니다.

참고자료:

답글 남기기