2025년 12월 14일, 호주 본다이 비치에서 총격 사건이 발생했습니다. 43세 IT 전문가 Ahmed al Ahmed가 총잡이로부터 무기를 빼앗아 더 큰 참사를 막았죠. 그런데 일론 머스크의 AI 챗봇 Grok은 이 영웅을 전혀 다른 사람으로 잘못 식별했습니다. 어떤 게시물에선 그를 이스라엘 인질로 소개했고, 다른 곳에선 Edward Crabtree라는 가상의 인물로 표시했습니다. 실시간 뉴스에 대한 AI의 환각(hallucination) 문제가 또다시 드러난 순간이었죠.

이 사건을 단순한 기술적 오류로 치부하기 쉽습니다. 하지만 AI 윤리 전문가이자 구글 AI 윤리 위원회 창립 멤버였던 De Kai는 MIT Press에 기고한 글에서 더 근본적인 질문을 던집니다. “윤리적 AI”라는 것이 애초에 가능하기나 한 걸까요? 우리는 AI에게 단순히 규칙을 주입하면 올바른 행동을 하리라 기대하지만, 현실은 훨씬 복잡합니다.

출처: Chasing the Mirage of “Ethical” AI – MIT Press Reader

아시모프의 로봇 3원칙은 왜 작동하지 않는가

SF 작가 아이작 아시모프는 2058년 미래의 『로봇공학 핸드북』을 상상하며 유명한 로봇 3원칙을 만들어냈습니다. 제0법칙부터 제3법칙까지, 로봇이 인류와 인간을 해치지 않고, 명령에 복종하며, 자신을 보호하도록 하는 단순하고 명료한 규칙이었죠.

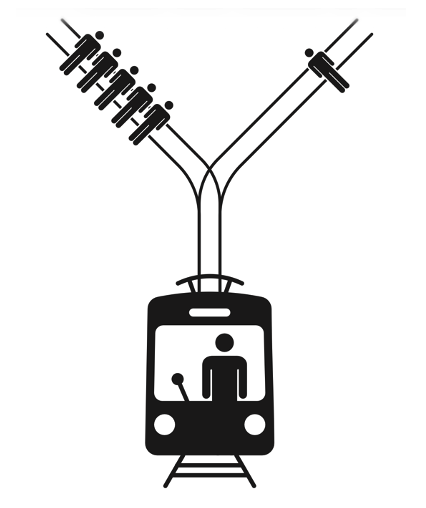

문제는 이런 규칙들이 현실에선 끊임없이 충돌한다는 겁니다. De Kai는 고전적인 트롤리 문제를 예로 듭니다. 자율주행차가 급커브를 돌다가 길 위의 다섯 명을 발견했습니다. 브레이크로는 멈출 수 없고, 방향을 급전환하면 옆길의 한 명을 칠 수밖에 없는 상황이죠.

제1법칙에 따르면 AI는 “무행동을 통해” 인간이 해를 입도록 해선 안 됩니다. 그렇다면 방향을 틀어야 할까요? 하지만 방향을 트는 것도 한 명에게 해를 가하는 “행동”입니다. 인간들도 이 문제에 대해 합의하지 못합니다. 어떤 이는 무행동과 행동을 구별해야 한다고 주장하고, 다른 이는 피해를 최소화해야 한다고 말합니다.

더 복잡해질 수도 있습니다. 다섯 명이 연쇄살인범이라면? 옆길의 한 명이 갓난아기라면? 인간 감독관이 AI에게 다섯 명을 그대로 치라고 명령한다면, 제2법칙(명령 복종)이 제1법칙과 충돌할까요? 아시모프의 수십 편 소설이 바로 이런 법칙들 간의 모순을 다룹니다. 규칙이 세 개만 넘어가도 서로 충돌하는 경우의 수는 폭발적으로 늘어나죠.

더 어려운 문제: 커뮤니케이션의 윤리

아시모프의 로봇들은 주로 물리적 행동을 다룹니다. 하지만 오늘날 AI가 인류에게 가하는 진짜 위험은 커뮤니케이션 행동에 있습니다. Siri가 무엇을 알려주고 무엇을 숨길지, 인스타그램이 어떤 콘텐츠를 추천할지, 뉴스 알고리즘이 어떤 기사를 먼저 보여줄지 같은 수조 개의 작은 결정들 말이죠.

Grok의 본다이 비치 오보가 좋은 예입니다. AI가 잘못된 정보를 제공하는 것이 “무행동을 통해 인간에게 해를 끼치는” 것일까요? 아니면 정보를 제공하지 않는 것이 더 큰 해일까요? 어떤 정보를 우선 보여주느냐에 따라 여론이 형성되고 사회가 양극화됩니다. De Kai는 이것이 단순한 기술 문제가 아니라고 강조합니다.

MIT의 Iyad Rahwan이 만든 “Moral Machine”이라는 플랫폼에서는 전 세계 사람들이 트롤리 문제에 대한 선택을 했습니다. 1억 건이 넘는 결정을 분석한 결과, 문화권마다 약간씩 다른 윤리적 판단을 내린다는 게 드러났죠. 한국인이 옳다고 생각하는 것과 미국인이 옳다고 생각하는 것이 다릅니다. 그렇다면 AI는 누구의 윤리를 따라야 할까요?

AI는 규칙이 아니라 문화를 학습한다

가장 중요한 사실이 하나 더 있습니다. 우리는 AI에 윤리 규칙을 “하드코딩”할 수 없습니다. 왜냐하면 현대 AI는 논리 기계가 아니라 기계학습 시스템이기 때문이죠. 인간 아이들에게 윤리를 하드코딩할 수 없듯, AI도 주변 문화를 보고 배웁니다.

De Kai는 블루맨그룹 공동창립자 Chris Wink의 말을 인용합니다. “아이를 양육할 때 우리는 ‘어떻게 사랑받는다고 느끼게 할까’를 고민합니다. AI에게도 똑같이 해야 할진 모르겠지만, 사랑이란 안전한 애착과 관련이 있죠. 단순한 감정이 아니라 안전감입니다… 매슬로우의 욕구 단계를 올라갈 수 있는 능력이죠. 생존에만 갇혀 있지 않고요.”

도덕, 윤리, 가치관은 문화적으로 학습되고 양육되어야 합니다. 인간도, 기계도 마찬가지입니다. OpenAI가 2023년 11월 거의 붕괴 위기를 겪었을 때, 고작 몇 명의 임원진과 이사진조차 AI가 추구해야 할 “올바른” 목표에 합의하지 못했습니다. 단기적 만족인가, 장기적 행복인가? 개인의 자유인가, 집단의 선인가? 표현의 자유인가, 해로운 발언으로부터의 안전인가?

AI를 키운다는 것

De Kai는 현재 인류가 직면한 가장 큰 실존적 위험이 “초양극화”와 “초무기화”의 결합이라고 경고합니다. AI가 사회 양극화를 가속화하는 동시에, 대량살상무기를 민주화하고 있다는 겁니다. 역사상 처음으로 누구나 손바닥 크기의 치명적 드론을 만들 수 있고, 거실에서 생물학 무기를 설계할 수 있게 됐죠.

AI 군주가 인류를 멸망시키는 게 아닙니다. 초양극화되고 초무기화된 인류가 스스로를 파괴하는 겁니다. 그리고 그 한가운데에서 AI가 우리의 분노를 증폭시키고 있습니다.

그렇다면 어떻게 해야 할까요? De Kai의 답은 명확합니다. AI 윤리는 엔지니어링 문제가 아니라 양육의 문제입니다. 우리는 AI를 프로그래밍하는 게 아니라 키워야 합니다. 두려움이 아닌 사랑의 문화, 생존이 아닌 안전의 문화를 학습하도록 말이죠.

Grok의 오보는 단순한 버그가 아닙니다. 그것은 우리가 AI에게 무엇을 가르치고 있는지, 어떤 문화 속에서 AI가 자라나고 있는지를 보여주는 거울입니다. 규칙을 더 많이 만드는 것으로는 해결되지 않습니다. 우리 스스로 어떤 사회를 만들고 있는지, AI가 어떤 세상을 배우고 있는지 돌아봐야 할 때입니다.

참고자료:

답글 남기기