AI 기술 분석

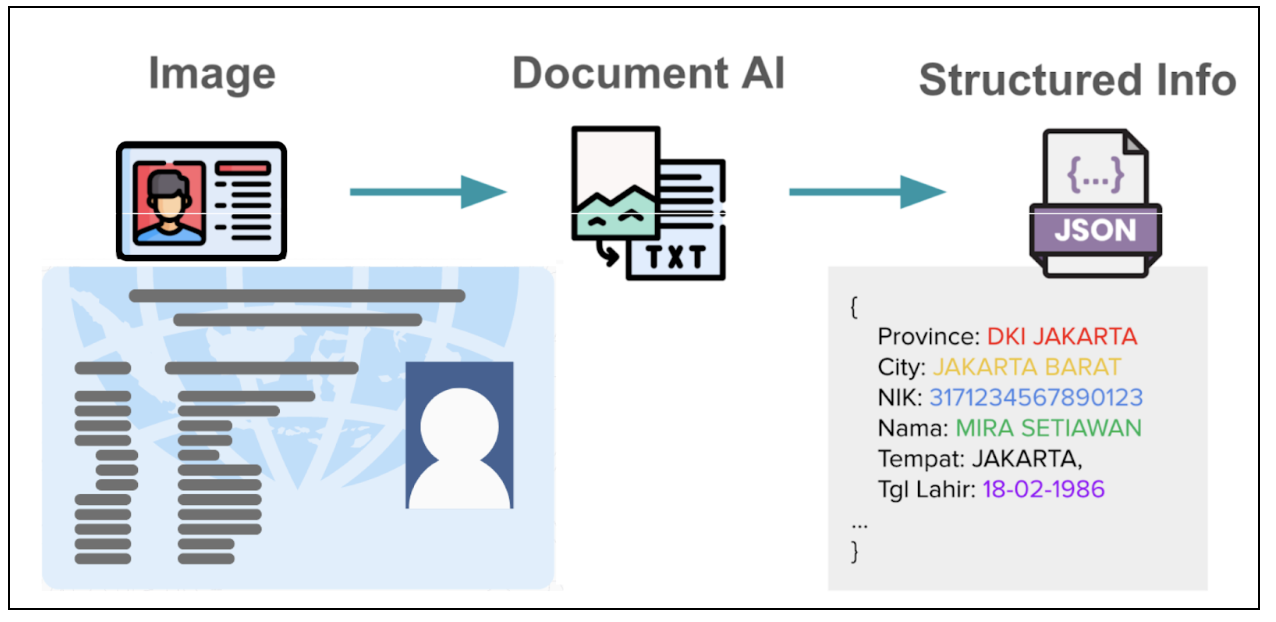

Grab의 1B Vision LLM: 태국어 정확도 70%p 향상시킨 4단계 훈련 전략

Grab이 1B 파라미터 Vision LLM으로 태국어 문서 정확도 70%p 향상시킨 4단계 훈련 전략. 작은 모델로 큰 성과를 낸 실전 사례를 소개합니다.

Written by

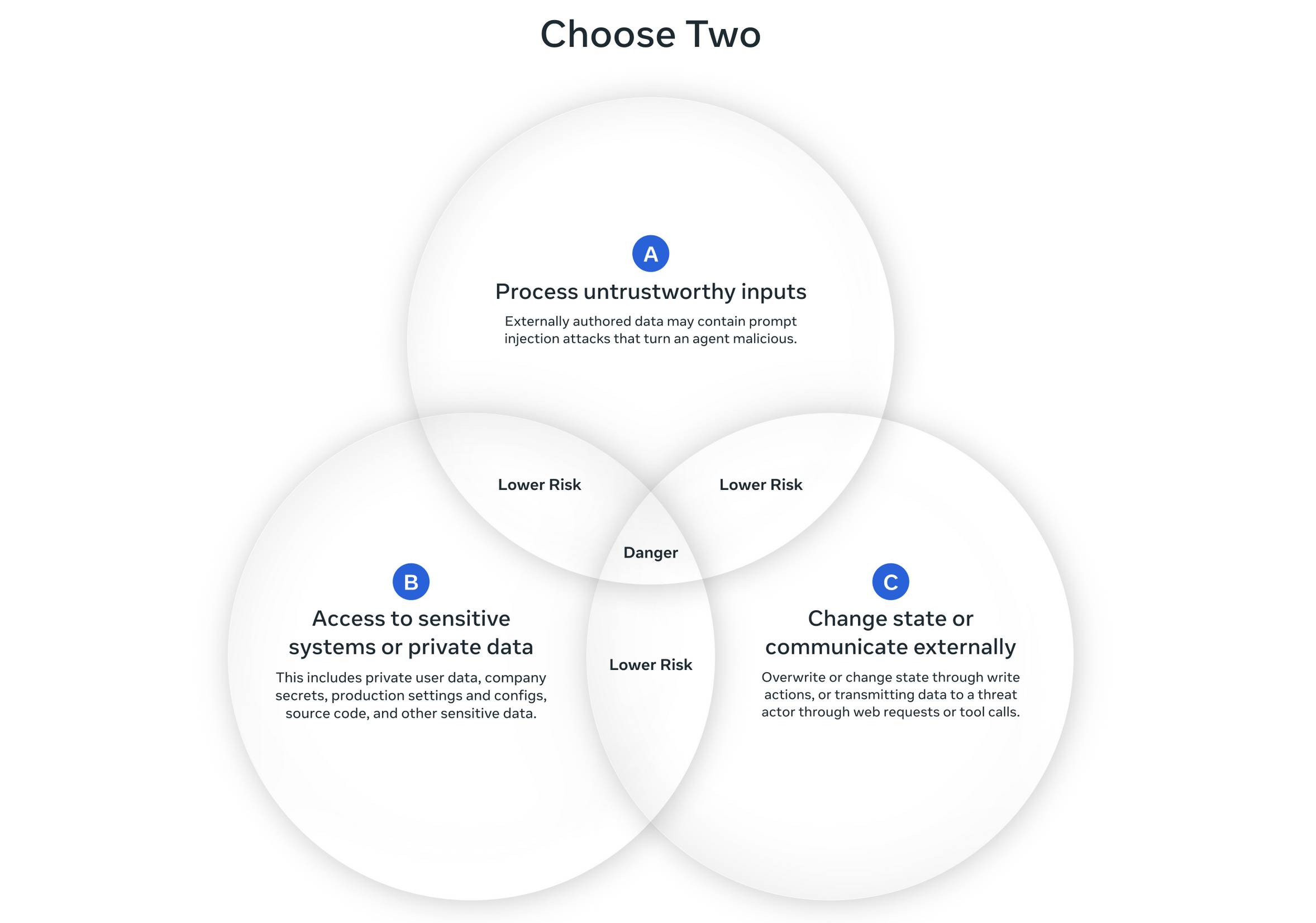

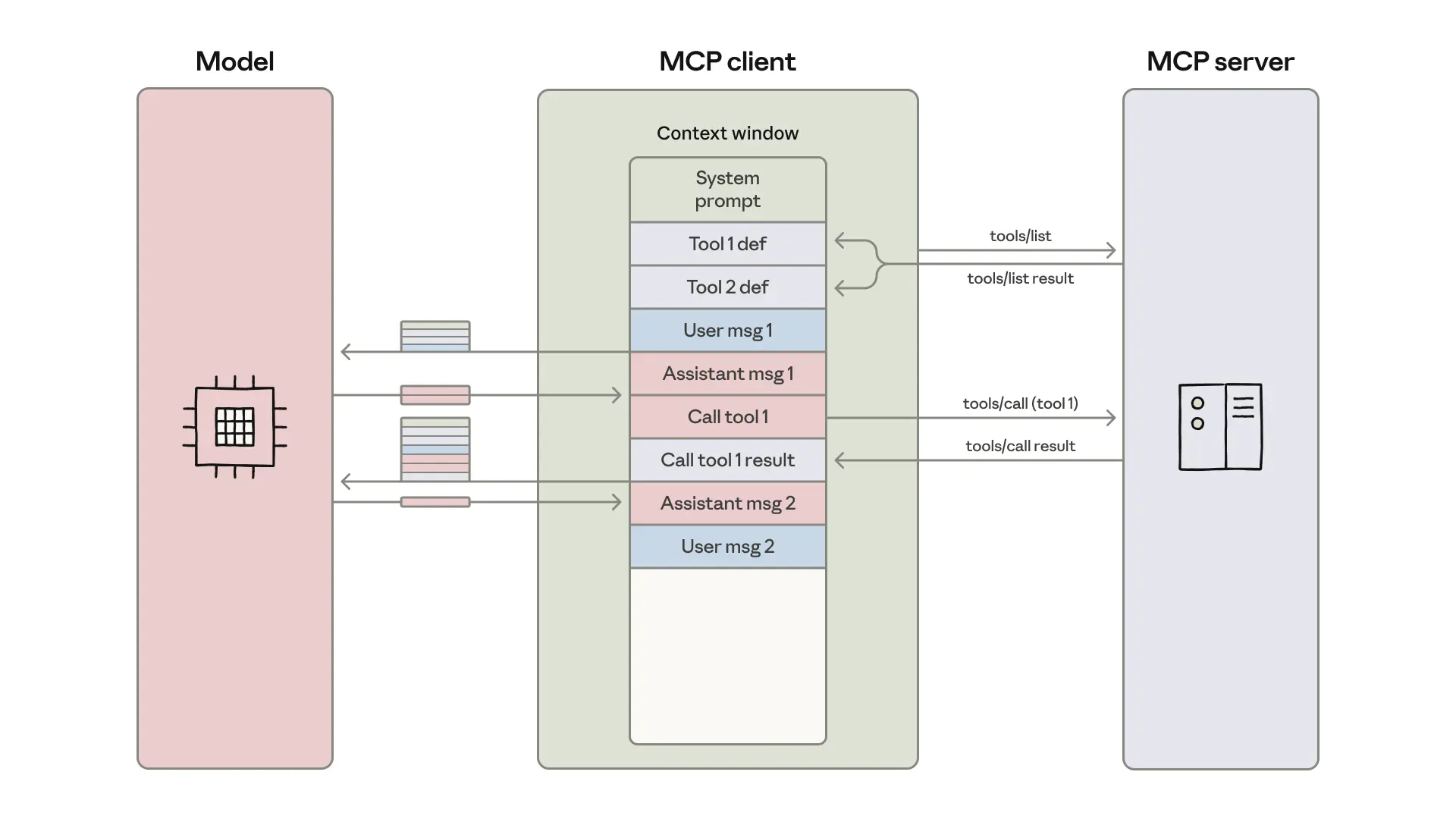

MCP 도구를 코드로 바꾸니 토큰이 98% 줄었다: Anthropic의 새 접근법

AI 에이전트의 MCP 도구를 코드 API로 전환하여 토큰 사용량을 98% 절감하는 Anthropic의 새로운 접근법. 효율성과 프라이버시를 동시에 개선합니다.

Written by

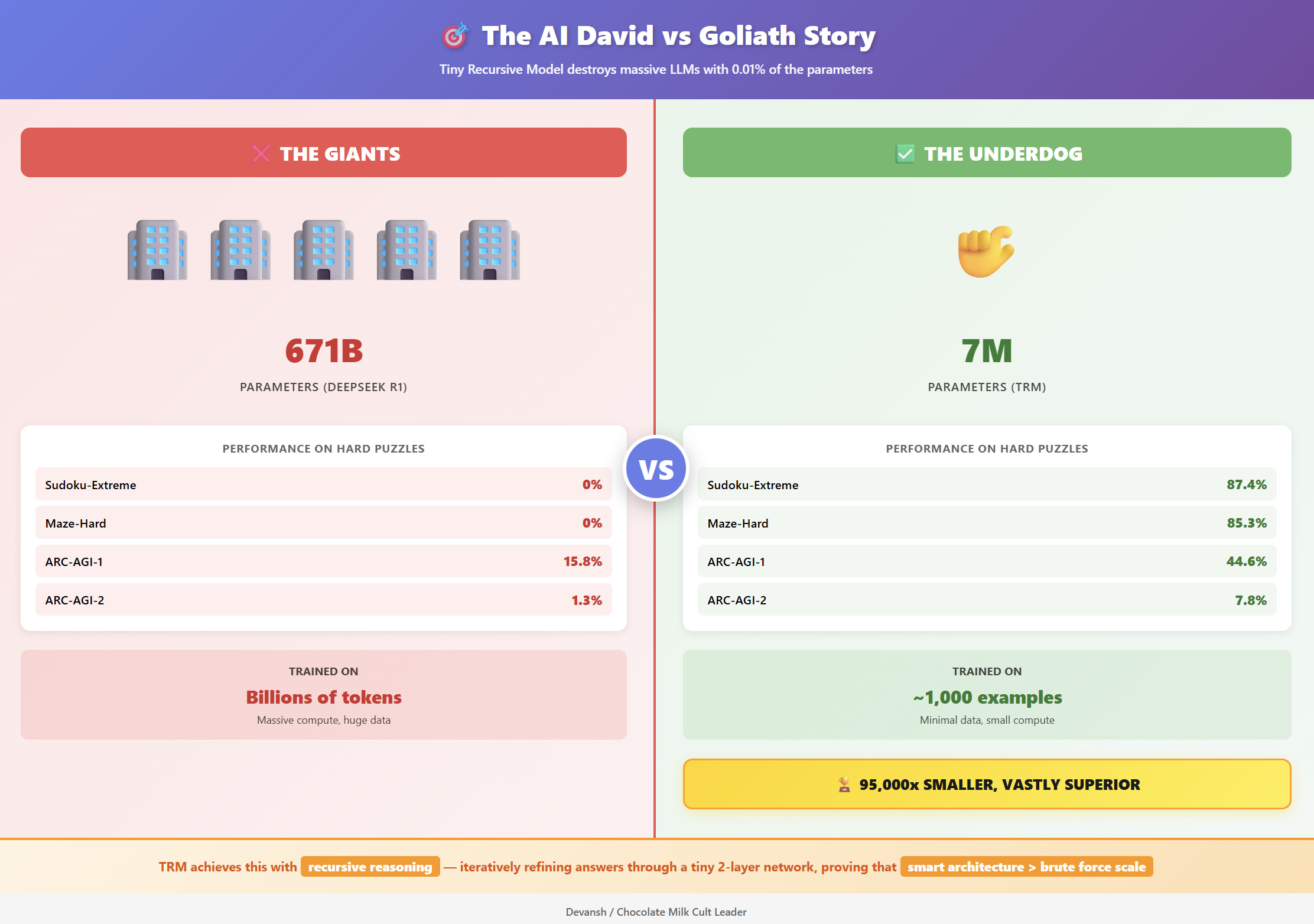

700만 파라미터 AI가 GPT를 이긴다: 삼성 TRM이 증명한 작은 모델의 반격

단 700만 파라미터로 거대 언어모델을 능가한 삼성의 Tiny Recursive Model. 생각을 반복하며 답을 수정하는 새로운 AI 패러다임을 소개합니다.

Written by

HTML 주석으로 AI 모델 망가뜨리기: 250개면 충분하다

AI 스크래퍼들이 HTML 주석 속 링크까지 수집하는 치명적 약점을 발견. 250개의 조작된 문서만으로 거대 언어모델을 무력화할 수 있다는 최신 연구와 함께 실전 대응 전략을 소개합니다.

Written by

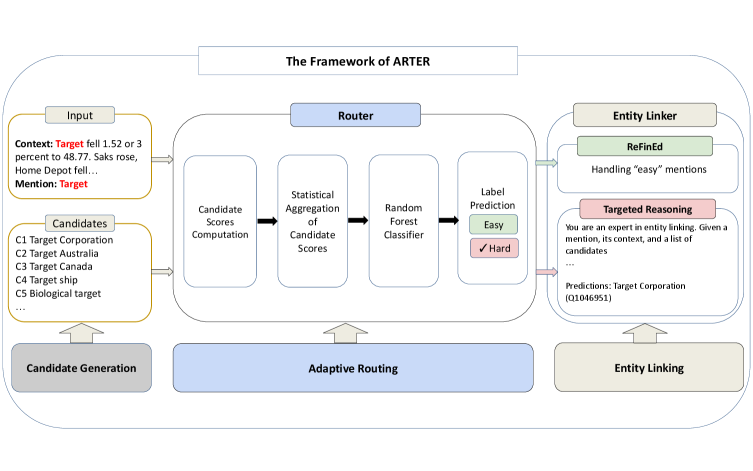

LLM 추론 비용 58% 절감: Apple의 ARTER가 보여준 적응형 라우팅 전략

Apple이 개발한 ARTER 시스템이 적응형 라우팅으로 LLM 추론 비용을 58% 절감하면서도 Entity Linking 정확도를 향상시킨 방법을 상세히 분석합니다.

Written by

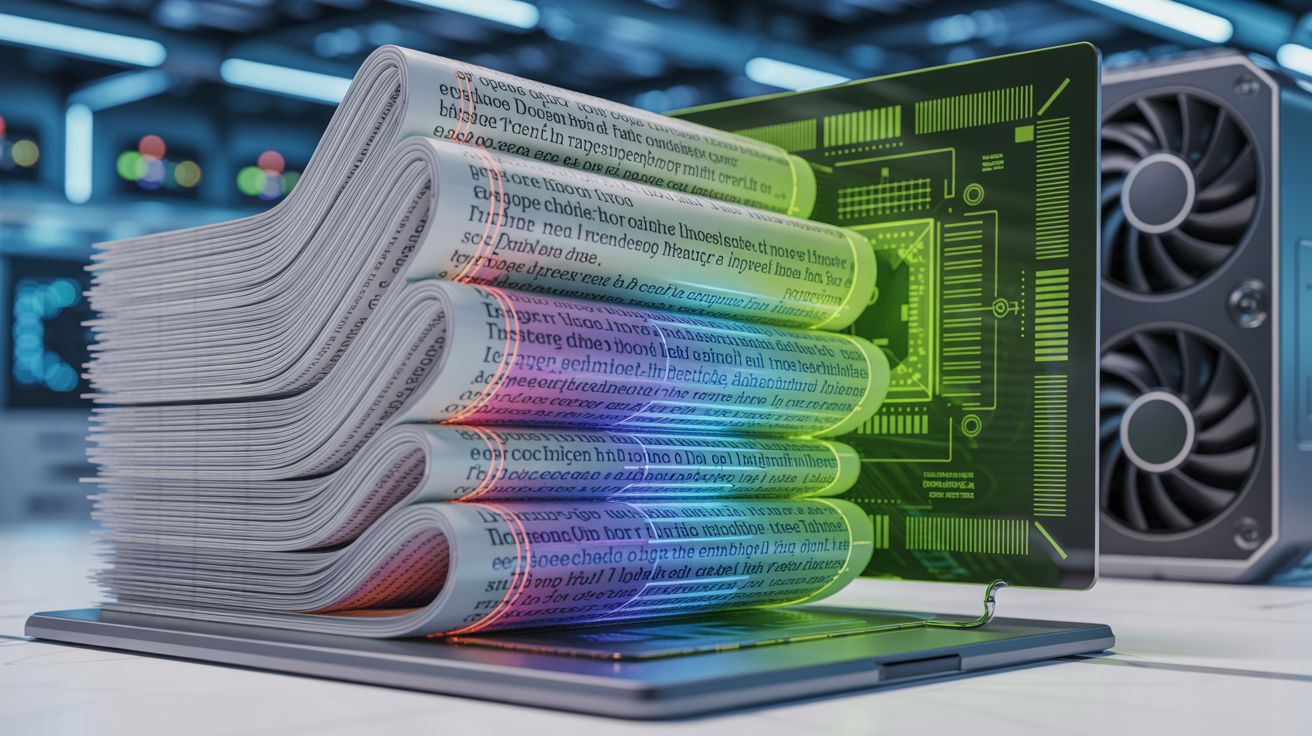

Glyph와 DeepSeek-OCR, 같은 문제 다른 해법: 긴 컨텍스트 압축 전쟁

LLM의 긴 컨텍스트 처리 비용 문제를 텍스트-이미지 압축으로 해결하는 두 가지 혁신적 접근법, Glyph와 DeepSeek-OCR을 비교 분석합니다. 3-4배 토큰 압축과 4배 빠른 추론 속도의 비밀을 알아보세요.

Written by

GPT-5 기반 Aardvark, 취약점 92% 탐지하며 보안 연구의 새 기준 제시

OpenAI가 GPT-5 기반 자율형 보안 연구 에이전트 Aardvark를 공개했습니다. 벤치마크 테스트에서 92% 취약점 탐지율을 기록하며 인간 보안 연구자처럼 코드를 읽고 분석하는 새로운 접근 방식을 제시합니다.

Written by

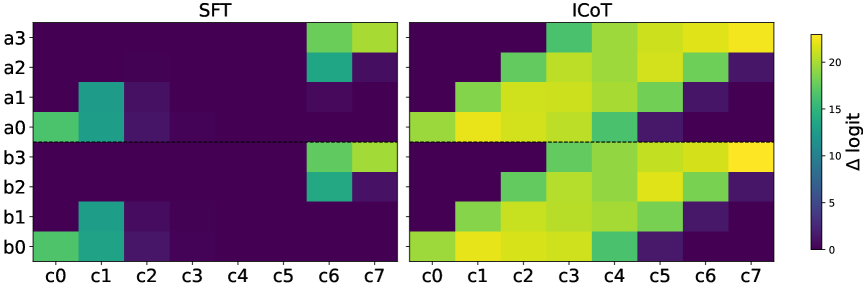

GPT가 곱셈을 못하는 진짜 이유: 트랜스포머의 숨겨진 약점

GPT-4도 4×4 곱셈에서 95% 이상 실패하는 이유를 하버드와 MIT 연구진이 밝혔습니다. 트랜스포머의 장거리 의존성 학습 한계와 실무 적용 가능한 해결책을 소개합니다.

Written by