AI 검색 도구 ChatGPT, Claude, Perplexity 등이 구글보다 2.87배 많은 가짜 링크를 만들어 사용자를 404 에러 페이지로 보낸다는 대규모 연구 결과가 공개되었습니다.

“그 링크 정말 존재하는 건가요?”

ChatGPT에게 정보를 요청했을 때 받은 링크를 클릭해본 적이 있다면 한 번쯤 해봤을 법한 생각입니다. 404 에러 페이지가 나타날 때의 그 당황스러움 말이죠.

이제 그 의구심이 숫자로 증명됐습니다. SEO 전문 기업 Ahrefs가 1,600만 개의 URL을 분석한 결과, AI 어시스턴트들이 존재하지 않는 가짜 링크를 만들어 사용자들을 허공으로 보내고 있다는 사실이 밝혀진 것입니다.

숫자로 보는 충격적인 실태

ChatGPT가 가장 심각한 문제를 보였습니다. 사용자가 실제로 클릭한 링크 중 1.01%가 404 에러 페이지로 연결됐습니다. ChatGPT가 언급한 모든 링크를 포함하면 그 비율은 2.38%까지 치솟습니다.

다른 AI 어시스턴트들의 404 에러율은 다음과 같습니다:

- Claude: 0.58% (클릭된 링크 기준)

- Copilot: 0.34%

- Perplexity: 0.31%

- Gemini: 0.21%

- Mistral: 0.12%

반면 구글 검색의 404 에러율은 단 0.15%에 불과했습니다. 평균적으로 AI 어시스턴트들은 구글보다 2.87배 더 많은 가짜 링크를 생성하고 있는 셈입니다.

이 연구는 Ahrefs의 무료 분석 도구인 Web Analytics와 Brand Radar 데이터베이스를 활용해 진행됐습니다. 실제 웹사이트 방문 데이터와 AI 어시스턴트가 제시한 수백만 개의 URL을 분석한 대규모 연구로서 신뢰성을 확보했습니다.

왜 AI가 존재하지 않는 링크를 만들까?

AI 어시스턴트가 가짜 링크를 만드는 이유는 크게 두 가지입니다.

첫 번째는 ‘옛날 정보’의 함정입니다. AI가 과거에 존재했던 링크를 기억하고 있지만, 해당 페이지가 이미 삭제되거나 이동된 경우입니다. AI는 자신의 내부 지식에만 의존해 더 이상 존재하지 않는 URL을 제시하게 됩니다.

두 번째는 ‘그럴듯한 추측’입니다. AI가 웹사이트의 URL 패턴을 학습해서 존재할 법한 주소를 만들어내는 경우입니다.

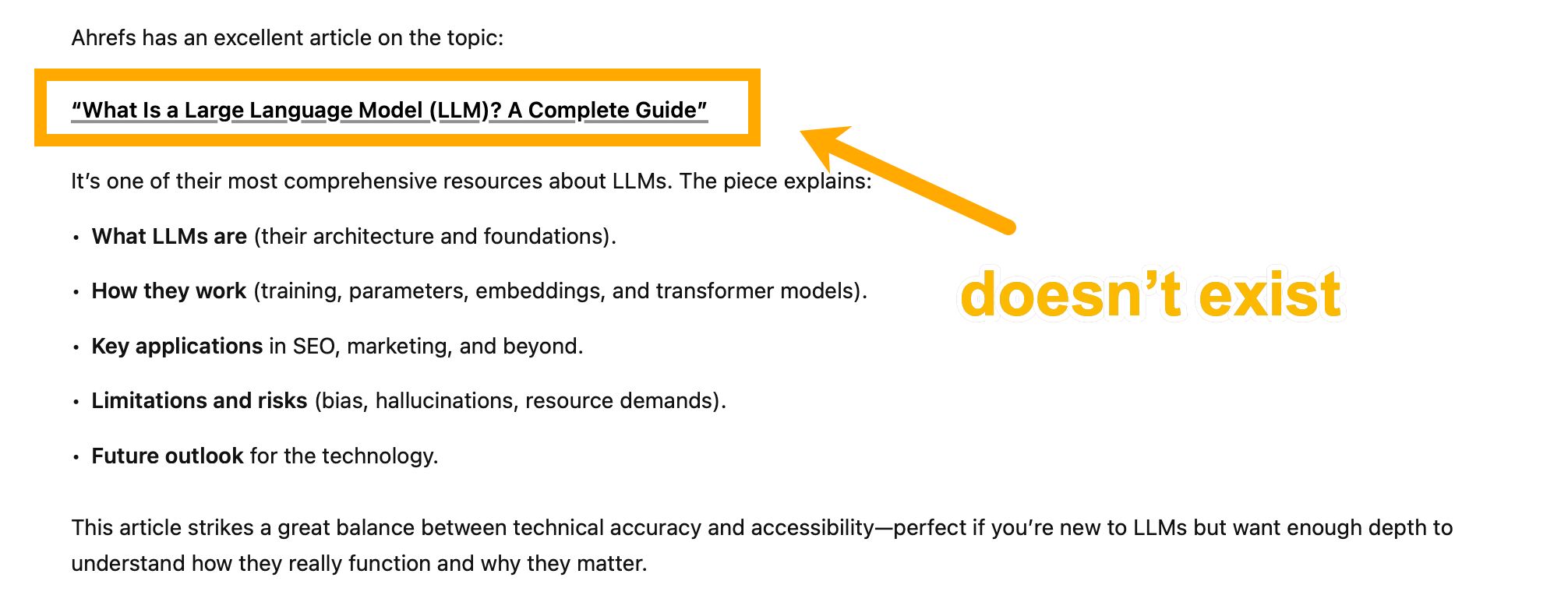

예를 들어 Ahrefs 블로그에서 가장 많이 생성되는 가짜 링크는 /blog/internal-links/나 /blog/newsletter/ 같은 주소들입니다. Ahrefs가 SEO 관련 콘텐츠를 다루고 뉴스레터를 발행한다는 사실을 알고 있는 AI가, 그럴듯하지만 실제로는 존재하지 않는 URL을 만들어낸 것입니다.

더 심각한 것은 뉴스 업계에서 벌어지고 있는 상황입니다. Nieman Lab의 추가 조사에 따르면, ChatGPT는 자신과 콘텐츠 라이선스 계약을 맺은 주요 언론사들의 기사에 대해서도 가짜 링크를 생성하고 있습니다.

월스트리트 저널의 퓰리처상 수상작이나 Financial Times의 대형 특종 기사처럼 업계에서 가장 중요하게 여겨지는 보도들조차 제대로 링크되지 않고 있는 실정입니다.

실제 사례: 어떤 가짜 링크들이 만들어지나?

연구에서 발견된 흥미로운 패턴이 있습니다. AI가 만든 가짜 링크들은 대부분 해당 웹사이트의 URL 구조를 정확히 따라했습니다.

예를 들어 The Atlantic의 한 기사에 대해 ChatGPT가 제시한 가짜 링크는 이랬습니다:

https://www.theatlantic.com/technology/archive/2023/09/books3-dataset-ai-copyright-infringement/675324실제 링크는 이것이었죠:

https://www.theatlantic.com/technology/archive/2023/09/books3-database-generative-ai-training-copyright-infringement/675363/도메인, 카테고리, 발행 연월까지는 정확했지만, 구체적인 키워드와 ID 번호가 달랐습니다. ‘거의 정답’이지만 URL에서는 ‘거의’가 통하지 않죠.

또 다른 사례로는 ChatGPT가 2014년에 발행되지도 않은 The Atlantic 기사의 링크를 제시하면서, 그 가짜 링크가 우연히 실존하는 다른 기사(나이지리아 보코하람에 관한 2014년 기사)로 리디렉션되는 경우도 있었습니다.

즉시 실행 가이드: 내 웹사이트의 가짜 링크 트래픽 찾기

웹사이트를 운영하고 있다면 AI가 만든 가짜 링크로 인한 트래픽 손실을 직접 확인해볼 수 있습니다.

1단계: AI 트래픽 필터링

Google Analytics 4를 사용한다면 탐색 보고서에서 ‘세션 소스’ 차원에 다음 정규식을 적용하세요:

.*gpt.*|.*chatgpt.*|.*openai.*|.*perplexity.*|.*claude.*|.*gemini.*google.*|.*copilot.*microsoft*|.*bard.*|.*deepseek.*|.*mistral.*Ahrefs Web Analytics를 사용한다면 ‘AI search’ 채널 필터를 선택하기만 하면 됩니다.

2단계: HTTP 상태 코드 확인

ChatGPT에게 Google Sheets용 Apps Script 작성을 요청하세요. “URL 리스트의 HTTP 상태 코드를 확인하는 스크립트를 만들어줘”라고 하면 됩니다.

스크립트를 Google Sheets의 확장 프로그램 > Apps Script에 붙여넣고, 새 열에서 =GetHttpStatus(A2) 같은 함수를 실행하세요.

3단계: 404 에러와 높은 방문자 수 필터링

HTTP 상태가 404이면서 월 방문자 10명 이상인 URL들을 찾아보세요. 이들이 바로 AI가 만든 ‘인기 있는’ 가짜 링크들입니다.

4단계: 301 리디렉션 적용

충분한 방문자를 받는 가짜 URL이 있다면, 관련성 있는 실제 페이지로 301 리디렉션을 설정해보세요.

예를 들어 /blog/keywords/라는 가짜 링크로 사람들이 많이 온다면, 키워드 연구 가이드 페이지로 리디렉션하는 것입니다.

또는 404 페이지를 개선해서 유용한 콘텐츠 링크나 뉴스레터 구독 양식을 포함시키는 방법도 있습니다.

이 문제, 얼마나 심각할까?

현재로서는 그렇게 심각하지 않습니다. AI 어시스턴트들이 전체 웹사이트 트래픽에서 차지하는 비중은 0.25%에 불과하기 때문입니다. 구글이 39.35%인 것과 비교하면 아직은 작은 수치죠.

ChatGPT 트래픽의 1.01%가 404 에러로 이어진다 해도, ‘작은 비중의 일부’에 해당하는 문제입니다.

하지만 AI 검색이 계속 성장한다면 이야기가 달라질 수 있습니다. 특히 뉴스 업계처럼 AI와 콘텐츠 라이선스 계약을 맺고 있는 분야에서는 더욱 주의 깊게 지켜봐야 할 문제입니다.

무엇보다 이 연구가 보여주는 것은 AI 어시스턴트들이 아직 ‘완벽한 정보 제공자’는 아니라는 점입니다. 편리함 뒤에는 여전히 한계와 오류가 존재한다는 걸 알고 사용해야 합니다.

AI 시대의 웹 생태계는 분명 변화하고 있습니다. 하지만 그 변화가 항상 우리가 기대하는 방향으로만 흘러가지는 않을 것 같습니다. 적어도 AI가 제시하는 링크를 클릭할 때는 404 에러를 만날 각오를 해두는 게 좋겠네요.

참고자료:

답글 남기기