로컬 AI 모델의 고질적인 문제인 정보 제한과 환각 현상을 해결하는 Ollama 웹 검색 API가 등장했습니다. 이제 프라이버시를 유지하면서도 최신 정보에 접근할 수 있습니다.

로컬에서 AI 모델을 돌려본 적이 있다면 이런 경험을 해봤을 겁니다. “2024년 대통령 선거 결과가 어떻게 됐어?”라고 물어봤는데 “죄송하지만 2023년 4월 이후 정보는 알 수 없습니다”라는 답변을 받았거나, 아니면 아예 말도 안 되는 거짓 정보를 그럴듯하게 지어내는 걸 봤을 겁니다.

이런 문제들이 바로 로컬 AI 모델의 한계였습니다. 훈련 시점의 데이터만 알고 있고, 모르는 걸 물어보면 환각(hallucination) 현상으로 거짓말을 하죠.

그런데 Ollama가 이 문제를 정면으로 해결했습니다.

웹 검색이 로컬 AI에게 날개를 달아준 순간

Ollama의 웹 검색 API는 단순합니다. 로컬에서 돌리는 AI 모델이 실시간으로 웹을 검색할 수 있게 해주죠. 무료 계정으로도 넉넉하게 사용할 수 있고, 더 많이 써야 한다면 유료 플랜도 있습니다.

핵심은 이겁니다. 이제 로컬 AI 모델이 “모르겠다”고 답하는 대신 실제로 웹에서 최신 정보를 찾아서 정확한 답변을 줄 수 있다는 거예요.

예를 들어 “Ollama가 뭐야?”라고 물어보면 AI가 실시간으로 웹을 검색해서 다음과 같은 결과를 가져옵니다:

- Ollama 공식 홈페이지

- “Ollama란 무엇인가? AI 모델 관리 도구 소개” (Hostinger 튜토리얼)

- “Ollama 설명: AI 접근성과 언어 처리 혁신” (GeeksforGeeks 기사)

그리고 이 정보들을 바탕으로 정확하고 최신 정보가 담긴 답변을 만들어줍니다.

개발자들을 위한 세 가지 방법

Ollama 웹 검색 API는 개발자들이 쉽게 사용할 수 있도록 세 가지 방법을 제공합니다.

REST API로 직접 호출하기

가장 기본적인 방법입니다. 어떤 프로그래밍 언어든 HTTP 요청만 보낼 수 있으면 됩니다.

export OLLAMA_API_KEY="your_api_key"

curl https://ollama.com/api/web_search \

--header "Authorization: Bearer $OLLAMA_API_KEY" \

-d '{"query": "what is ollama?"}'Python 라이브러리 사용하기

Python으로 개발한다면 ollama 라이브러리를 쓰세요. 설치부터 사용까지 정말 간단합니다.

pip install 'ollama>=0.6.0'

import ollama

response = ollama.web_search("What is Ollama?")

print(response)JavaScript 라이브러리 활용하기

웹 애플리케이션이나 Node.js 환경에서는 JavaScript 라이브러리가 제격입니다.

npm install 'ollama@>=0.6.0'

import { Ollama } from "ollama";

const client = new Ollama();

const results = await client.webSearch({ query: "what is ollama?" });

console.log(JSON.stringify(results, null, 2));세 방법 모두 똑같은 결과를 줍니다. 제목, URL, 콘텐츠가 포함된 검색 결과들을 JSON 형태로 받을 수 있어요.

실전 활용: 검색 에이전트 만들기

이론만 알아서는 재미없죠. 실제로 웹 검색 기능을 활용한 AI 에이전트를 만들어보겠습니다.

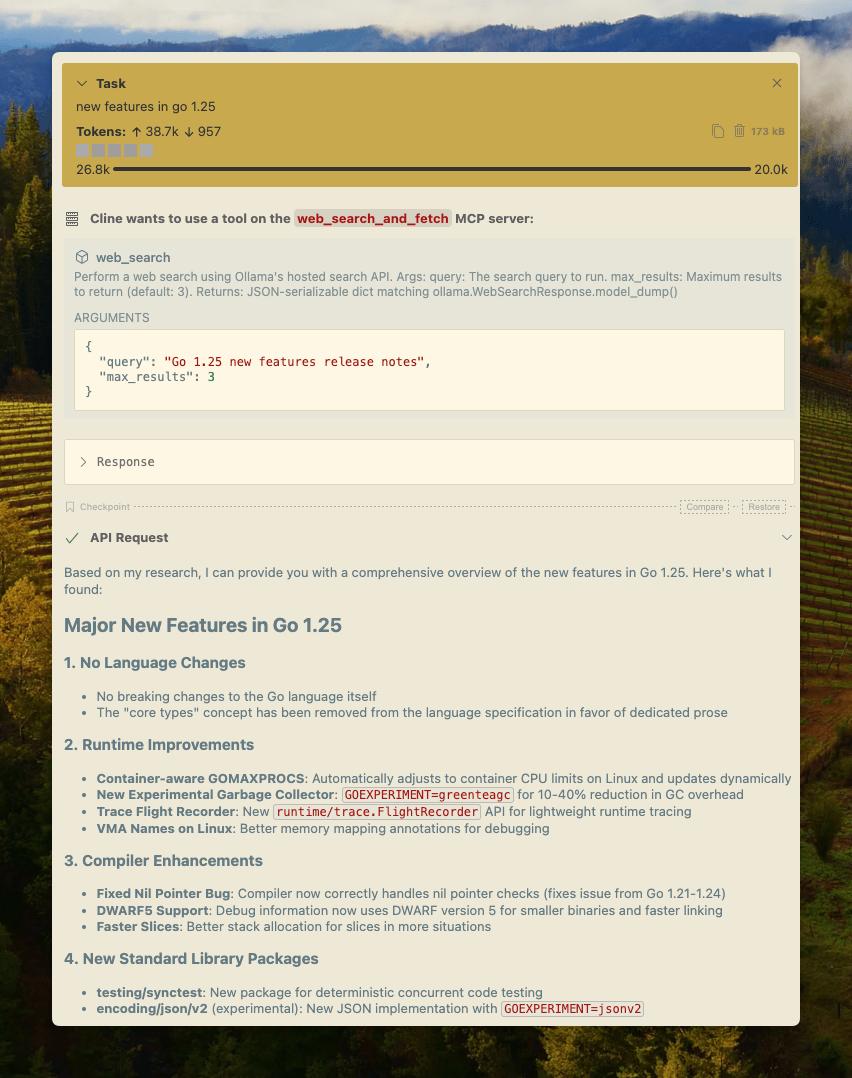

Ollama에서 추천하는 Qwen3 4B 모델을 사용해보겠습니다. 이 모델은 크기도 적당하고 도구 사용 능력이 뛰어납니다.

ollama pull qwen3:4b이제 Python 코드로 검색 에이전트를 만들어보겠습니다:

from ollama import chat, web_fetch, web_search

available_tools = {'web_search': web_search, 'web_fetch': web_fetch}

messages = [{'role': 'user', 'content': "Ollama의 새로운 엔진에 대해 알려줘"}]

while True:

response = chat(

model='qwen3:4b',

messages=messages,

tools=[web_search, web_fetch],

think=True

)

if response.message.thinking:

print('생각 중: ', response.message.thinking)

if response.message.content:

print('답변: ', response.message.content)

messages.append(response.message)

if response.message.tool_calls:

print('도구 호출: ', response.message.tool_calls)

for tool_call in response.message.tool_calls:

function_to_call = available_tools.get(tool_call.function.name)

if function_to_call:

args = tool_call.function.arguments

result = function_to_call(**args)

print('결과: ', str(result)[:200]+'...')

messages.append({'role': 'tool', 'content': str(result)[:8000], 'tool_name': tool_call.function.name})

else:

break이 코드를 실행하면 AI가 스스로 생각해서 웹 검색을 하고, 그 결과를 바탕으로 답변을 만들어줍니다. 정말 똑똑한 비서가 생긴 것 같죠?

실제로 실행해보면 AI가 “Ollama 새 엔진”을 검색해서 2025년에 출시된 두 가지 주요 업데이트를 찾아줍니다:

- 향상된 모델 스케줄링 (2025년 9월): 메모리 관리 개선, GPU 활용도 증가, 멀티 GPU 지원

- 멀티모달 엔진 (2025년 5월): 비전 모델 지원, 이미지와 비디오 분석 가능

개발 도구와의 완벽한 통합

웹 검색 API의 진짜 힘은 기존 개발 도구들과 자연스럽게 연결된다는 점입니다. MCP(Model Context Protocol) 서버를 통해 다양한 IDE와 AI 도구들에 연결할 수 있어요.

Cline과 연결하기

AI 코딩 도구인 Cline에서 웹 검색을 사용하려면 MCP 서버 설정만 추가하면 됩니다:

{

"mcpServers": {

"web_search_and_fetch": {

"type": "stdio",

"command": "uv",

"args": ["run", "path/to/web-search-mcp.py"],

"env": { "OLLAMA_API_KEY": "your_api_key_here" }

}

}

}

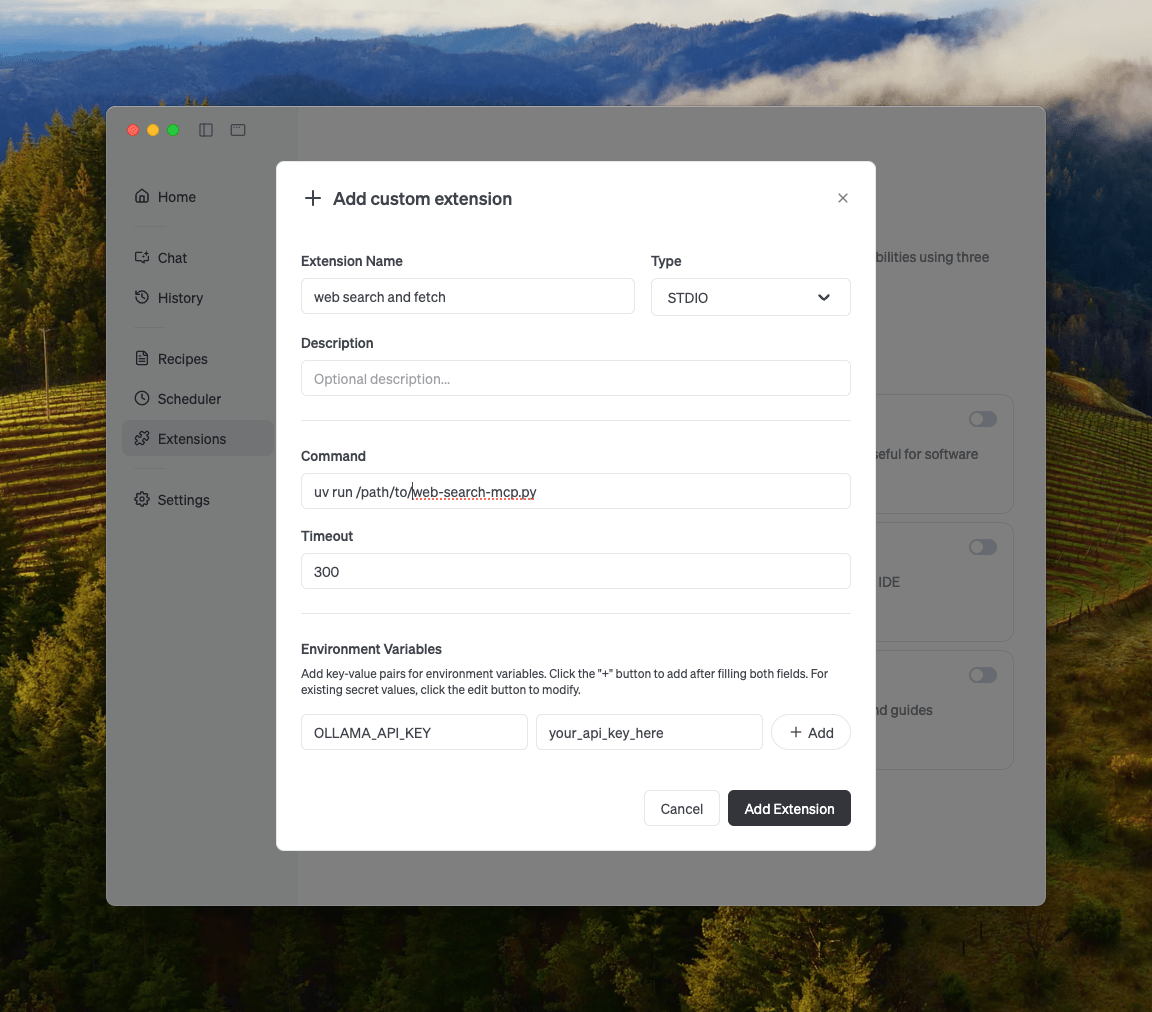

Goose와의 연동

Goose는 AI 기반 코딩 도구인데, Ollama의 웹 검색과 연결하면 최신 프로그래밍 정보를 실시간으로 찾아서 코드를 작성해줍니다.

이런 통합의 장점은 명확합니다. 코딩하다가 막히면 AI가 알아서 최신 문서를 찾아서 해결책을 제시해주는 거죠.

웹 페이지 직접 가져오기도 가능

검색뿐만 아니라 특정 웹 페이지의 내용을 직접 가져오는 기능도 있습니다. 사용자가 URL을 제공하면 그 페이지 내용을 바로 분석할 수 있어요.

from ollama import web_fetch

result = web_fetch('https://ollama.com')

print(result)결과는 이런 식으로 나옵니다:

WebFetchResponse(

title='Ollama',

content='클라우드 모델들이 Ollama에서 사용 가능합니다...',

links=['https://ollama.com/', 'https://ollama.com/models']

)제목, 본문 내용, 그리고 페이지에 있는 링크들까지 모두 깔끔하게 정리해서 줍니다.

추천 모델들

Ollama에서는 웹 검색과 특히 잘 맞는 모델들을 추천하고 있습니다:

로컬 모델: qwen3, gpt-oss

클라우드 모델: qwen3:480b-cloud, gpt-oss:120b-cloud, deepseek-v3.1-cloud

이 모델들은 도구 사용 능력이 뛰어나고 여러 번의 대화를 통해 복잡한 작업을 처리하는 데 특화되어 있습니다.

한 가지 팁을 드리자면, 웹 검색 결과는 수천 개의 토큰을 반환할 수 있어서 모델의 컨텍스트 길이를 32,000 토큰 정도로 늘려서 사용하는 게 좋습니다.

마무리

Ollama의 웹 검색 API는 로컬 AI의 게임을 바꿨습니다. 이제 프라이버시는 지키면서도 최신 정보에 접근할 수 있고, 환각 현상도 크게 줄일 수 있어요.

무료 계정만으로도 충분히 테스트해볼 수 있으니, 로컬 AI에 관심이 있다면 한번 시도해보시길 추천합니다. 특히 개발자라면 기존 워크플로우에 쉽게 통합할 수 있을 거예요.

참고자료: Web search · Ollama Blog

답글 남기기