AI 챗봇에게 “경쟁사 트래픽을 보여줘”라고 물으면 답변을 내놓습니다. 하지만 “경쟁사를 모니터링하다가 트래픽이 기준치를 넘으면 나한테 알려줘”라고 하면요? 이건 챗봇이 할 수 없는 일입니다. 바로 여기서 AI 에이전트가 등장합니다.

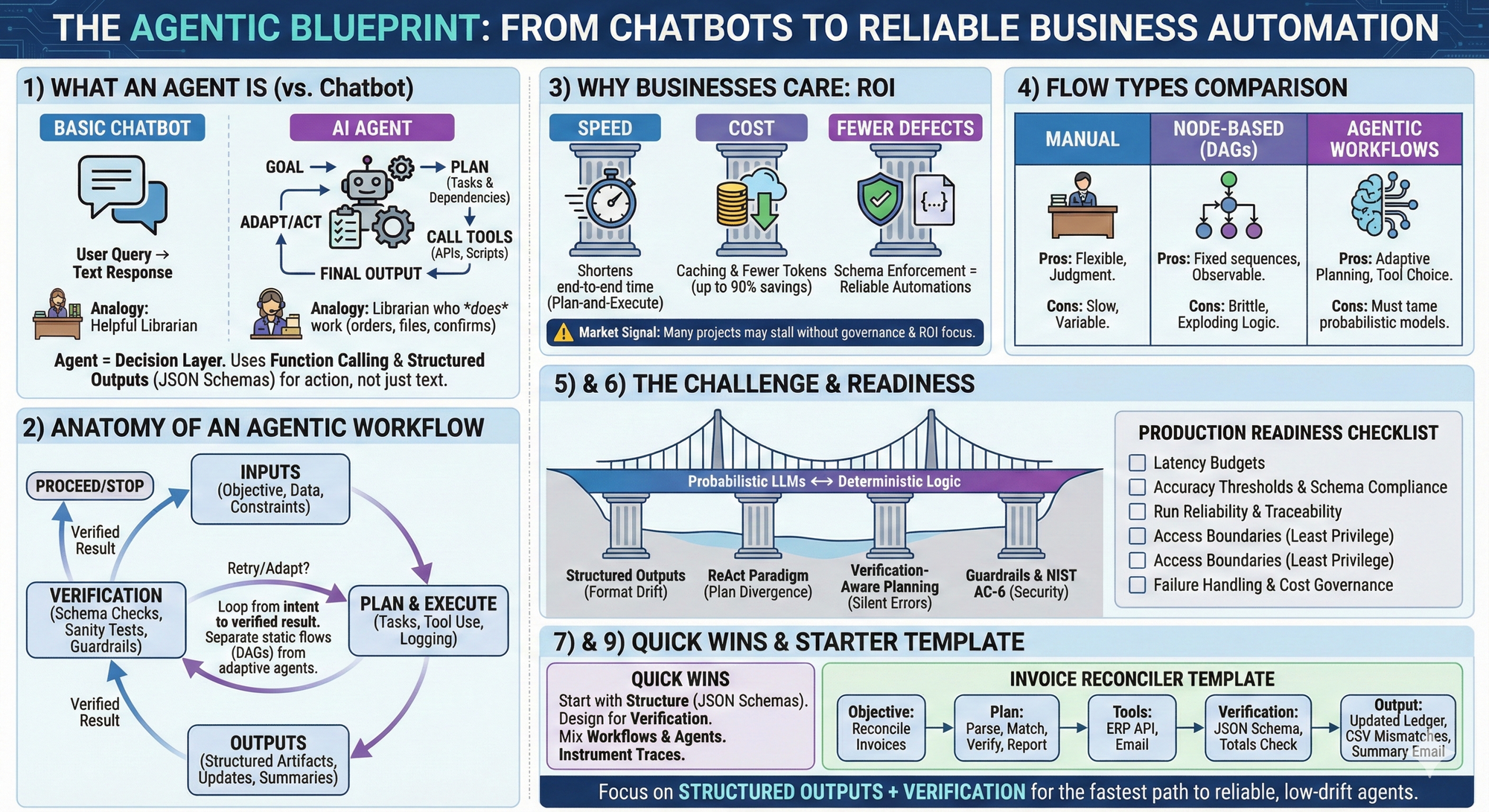

챗봇은 반응형입니다. 질문에 답하죠. 에이전트는 능동형입니다. 작업을 실행하고 변화를 감지하며 시간이 지나도 결정을 내립니다. 더 중요한 건, 역할이 정의되고 맥락을 인식하며 자율적으로 움직인다는 점입니다.

McKinsey 데이터에 따르면 이미 23%의 조직이 에이전트 시스템을 확장 중이고, 39%가 테스트 단계에 있습니다. Gartner는 2026년까지 기업 애플리케이션의 40%가 AI 에이전트를 탑재할 것으로 예측하는데, 이는 현재 5% 미만에서 급증하는 수치입니다.

챗봇과 에이전트, 무엇이 다른가

비교표로 보면 차이가 명확합니다:

| 구분 | 챗봇 | AI 에이전트 |

|---|---|---|

| 기능 | 질문에 답변 | 작업 실행 및 의사결정 |

| 맥락 | 단기 메모리 | 장기 목표와 상태 유지 |

| 행동 | 요약 생성 | 데이터 수집, 워크플로우 트리거, 다른 에이전트와 협업 |

| 자율성 | 사용자 주도 | 자기 주도, 프롬프트 없이도 일정 관리 및 알림 실행 |

| 예시 | “경쟁사 트래픽 보여줘” | “경쟁사를 모니터링하다가 트래픽이 급증하면 알려줘” |

핵심은 자율성입니다. 에이전트는 목표를 받으면 계획을 세우고, 도구를 선택하고, 결과를 검증한 뒤 다음 행동을 결정합니다. 사람이 매 단계를 지시할 필요가 없죠.

에이전트 워크플로우의 실제 작동 방식

한 기업의 사례를 봅시다. 이 회사는 브랜드 성과를 벤치마킹하는 복합 스코어카드를 만드는 데 6개월을 투입했습니다. 수작업이 많고, 리소스가 많이 들고, 확장도 어려웠죠.

그런데 SEO MCP(Model Context Protocol)를 도입한 뒤 같은 작업이 하루 만에 자동화됐습니다. 에이전트가 적절한 지표를 가져오고, 맞춤 가중치를 적용하고, 경영진용 요약을 즉시 생성했습니다.

또 다른 회사는 월간 성과 대시보드를 만드는 데 매달 여러 시간을 썼습니다. SERP 성과, AI 검색 트래픽, 키워드 트렌드를 여러 플랫폼에서 수집해야 했거든요. 이제는 자연어 프롬프트 하나로 브랜딩된 보고서가 몇 분 만에 나옵니다.

에이전트 오케스트레이션: 협업하는 AI들

진짜 힘은 여기서 나옵니다. 단일 에이전트가 아니라 각자 역할이 있는 에이전트 네트워크를 구축하는 거죠:

- 검색 트렌드 에이전트: 외부 수요 변화 추적

- 경쟁 인텔리전스 에이전트: SEO 도구에서 사이트 트래픽과 참여도 모니터링

- 소셜 리스닝 에이전트: 서드파티 소스에서 감성 데이터 수집

- 보고서 작성 에이전트: 결과를 경영진 요약으로 컴파일

한 에이전트는 경쟁사를 모니터링하고, 다른 하나는 키워드 트렌드를 추적하고, 또 다른 하나는 주간 요약을 생성합니다. 이들은 자율적으로 작동하면서도 인사이트를 교환하고 협력하죠.

프로덕션급으로 만들기: 확률을 결정론으로

여기서 중요한 질문이 생깁니다. LLM은 확률적입니다. 같은 입력에도 다른 출력이 나올 수 있죠. 하지만 비즈니스는 결정론적 결과가 필요합니다. 일관된 스키마, 반복 가능한 단계, 감사 가능한 기록이요. 이 긴장을 어떻게 해결할까요?

1. 구조화된 출력으로 형식 고정

가장 먼저 할 일은 모든 출력에 JSON 스키마를 정의하고 강제하는 겁니다. OpenAI의 Structured Outputs나 Anthropic의 Claude Structured Outputs를 쓰면 에이전트가 정확한 형식으로만 응답하게 만들 수 있습니다. 형식이 흔들리면 다운스트림 시스템이 깨지니까요.

2. 검증을 1등급 작업으로

에이전트 워크플로우는 다섯 단계로 구성됩니다:

- 입력: 비즈니스 목표, 제약, 소스 데이터

- 계획: 작업과 종속성, 단계별 성공 체크

- 도구: API, 스크립트, 접근 규칙, 속도 제한

- 출력: CSV나 JSON 같은 구조화된 결과물

- 검증: 스키마 검증, 상식 체크, 진실과 대조

검증은 선택이 아닙니다. 각 서브목표마다 통과/실패 체크를 인코딩해서 에이전트가 계속 진행할지 멈출지 사실에 근거해 판단하게 만들어야 합니다.

3. ReAct 패턴: 추론과 행동의 교차

에이전트가 환각을 줄이려면 생각과 행동을 교차시켜야 합니다. 관찰에 기반해 계획을 세우고, 도구를 사용한 결과를 다음 단계 추론에 반영하는 거죠. 이게 바로 ReAct(Reasoning and Acting) 패러다임입니다.

4. 거버넌스와 보안

에이전트를 실제 소프트웨어 사용자처럼 취급하세요. NIST의 최소 권한 원칙(AC-6)을 따르고, OWASP LLM Top 10으로 프롬프트 인젝션이나 안전하지 않은 출력 처리 같은 LLM 특유의 위협을 방어해야 합니다.

Guardrails AI 같은 라이브러리를 쓰면 입력과 출력에 정책, 형식, PII 체크를 위한 검증자를 적용할 수 있습니다.

프로덕션 준비 체크리스트

에이전트를 실전에 투입하기 전에 확인해야 할 것들:

운영 지표

- [ ] 엔드투엔드 지연 목표와 단계별 상한선 설정

- [ ] 필드나 결과물마다 정확도 임계값 정의

- [ ] 모든 결정과 도구 호출에 대한 추적 가능성 확보

품질과 통제

- [ ] 스키마 준수 100% 또는 자동 복구

- [ ] 입력, 중간 결과물, 최종 결과에 검증 적용

- [ ] 각 도구 호출과 근거에 대한 불변 로그 유지

리스크와 안전

- [ ] 최소 권한으로 접근 경계 강제

- [ ] 재시도, 회로 차단기, 신뢰도 낮을 때 에스컬레이션

- [ ] 실행당 비용 상한, 가능한 곳은 배치, 토큰 트리밍

감사관이 단일 로그나 추적에서 무슨 일이 왜 일어났는지 파악할 수 있나요? 실패가 외부 이해관계자를 놀라게 하지 않고 안전하게 저하되나요?

당장 시작할 수 있는 것

복잡하게 생각할 필요 없습니다. 간단한 템플릿으로 시작하세요:

목표: 지난주 인보이스를 원장과 대조하고 예외 사항을 매주 금요일 오후 4시까지 회계팀에 이메일로 보내기

계획: 신규 인보이스 파싱 → PO와 매칭 → 합계 검증 → 불일치 CSV 생성 → 요약 초안 작성 → 승인 경로 설정

도구: ERP API, 스프레드시트 유틸리티, 이메일 서비스, 스키마 검증자

검증: 파싱된 레코드에 JSON 스키마, 반올림과 세금 규칙 단위 테스트, 샘플 스팟 체크

출력: CSV, 업데이트된 원장 항목, 결과물 링크가 포함된 요약

하나만 고른다면 구조화된 출력 + 검증부터 시작하세요. 이게 신뢰할 수 있고 흔들림 없는 에이전트로 가는 가장 빠른 길입니다.

정적 워크플로우는 언제 더 나은가

모든 걸 에이전트로 만들 필요는 없습니다. 프로세스가 예측 가능한 파이프라인이라면 DAG(Directed Acyclic Graph) 스케줄러가 결정론과 내구성 있는 재시도를 보장해줍니다. Apache Airflow나 Temporal 같은 도구가 이런 용도에 적합하죠.

언제 무엇을 쓸까요?

- 정적 워크플로우: 작업 순서가 명확하고 입력이 깨끗할 때

- 에이전트 워크플로우: 입력이 지저분하거나 분기 로직이 복잡할 때

- 혼합: 고정 파이프라인을 쓰되 데이터가 정말 요구할 때만 에이전트가 분기하도록

마치며

AI 에이전트는 더 이상 미래 이야기가 아닙니다. 실제 비즈니스에서 6개월 작업을 하루로 줄이고, 매달 몇 시간 걸리던 보고서를 몇 분으로 단축시키고 있습니다.

하지만 Gartner가 2027년까지 프로젝트의 40% 이상이 취소될 것으로 예측하는 데는 이유가 있습니다. 기술만으로는 부족합니다. 명확한 목표, 구조화된 출력, 끊임없는 검증, 그리고 거버넌스가 필요합니다. 확률적인 LLM을 결정론적인 비즈니스 로직으로 바꾸는 건 가능하지만, 설계부터 그걸 염두에 둬야 합니다.

이번 달 에이전트에게 맡길 수 있는 실제 비즈니스 목표가 하나 있다면, “완료”의 정의를 측정 가능하게 만드는 것부터 시작하세요. 나머지는 따라옵니다.

참고자료:

- What Are Agentic Workflows – Similarweb

- Agents At Work: The 2026 Playbook for Building Reliable Agentic Workflows – Prompt Engineering

- OpenAI Function Calling

- Claude Structured Outputs

- OpenAI Structured Outputs

- LangGraph: Workflows vs Agents

- ReAct: Synergizing Reasoning and Acting in Language Models

- OWASP Top 10 for LLM Applications

- Gartner: 40% of Enterprise Apps Will Feature AI Agents by 2026

- Gartner: Over 40% of Agentic AI Projects May Be Canceled by 2027

답글 남기기