Anthropic과 OpenAI가 거의 동시에 “fast mode”를 발표했습니다. 그런데 속도를 비교해보면 이상한 점이 있어요. Anthropic은 2.5배, OpenAI는 15배 빠릅니다. 둘 다 같은 걸 하는데 왜 차이가 6배나 날까요?

GitHub 소속 엔지니어 Sean Goedecke가 두 회사의 fast mode가 어떻게 다르게 작동하는지를 분석했습니다. 결론부터 말하면, 둘은 이름만 같을 뿐 완전히 다른 원리로 작동합니다.

출처: Two different tricks for fast LLM inference – seangoedecke.com

Anthropic의 방법: 버스를 혼자 타기

LLM 추론의 핵심 병목은 메모리입니다. GPU 자체는 빠르지만, 데이터를 GPU에 올리는 과정이 느리거든요. 그래서 AI 서비스는 보통 여러 사용자의 요청을 한 번에 묶어서 처리합니다. 이걸 배칭(batching)이라고 해요.

버스에 비유하면 이해가 쉽습니다. 승객이 탈 때마다 버스가 바로 출발하면 그 승객은 빠르게 가지만, 전체 승객 처리량은 떨어집니다. 반대로 버스가 꽉 찰 때까지 기다리면 효율은 좋아지지만 승객은 오래 기다려야 하죠.

Anthropic의 fast mode는 버스를 혼자 타는 것과 같습니다. 다른 요청을 기다리지 않고 즉시 처리하는 방식이에요. 비용이 6배 비싼 이유도 여기 있습니다. 원래 함께 탔을 다른 승객들의 몫까지 비용을 내는 셈이니까요. 대신 실제 Claude Opus 4.6 모델을 그대로 쓸 수 있다는 게 핵심 장점입니다.

OpenAI의 방법: 웨이퍼 크기의 칩

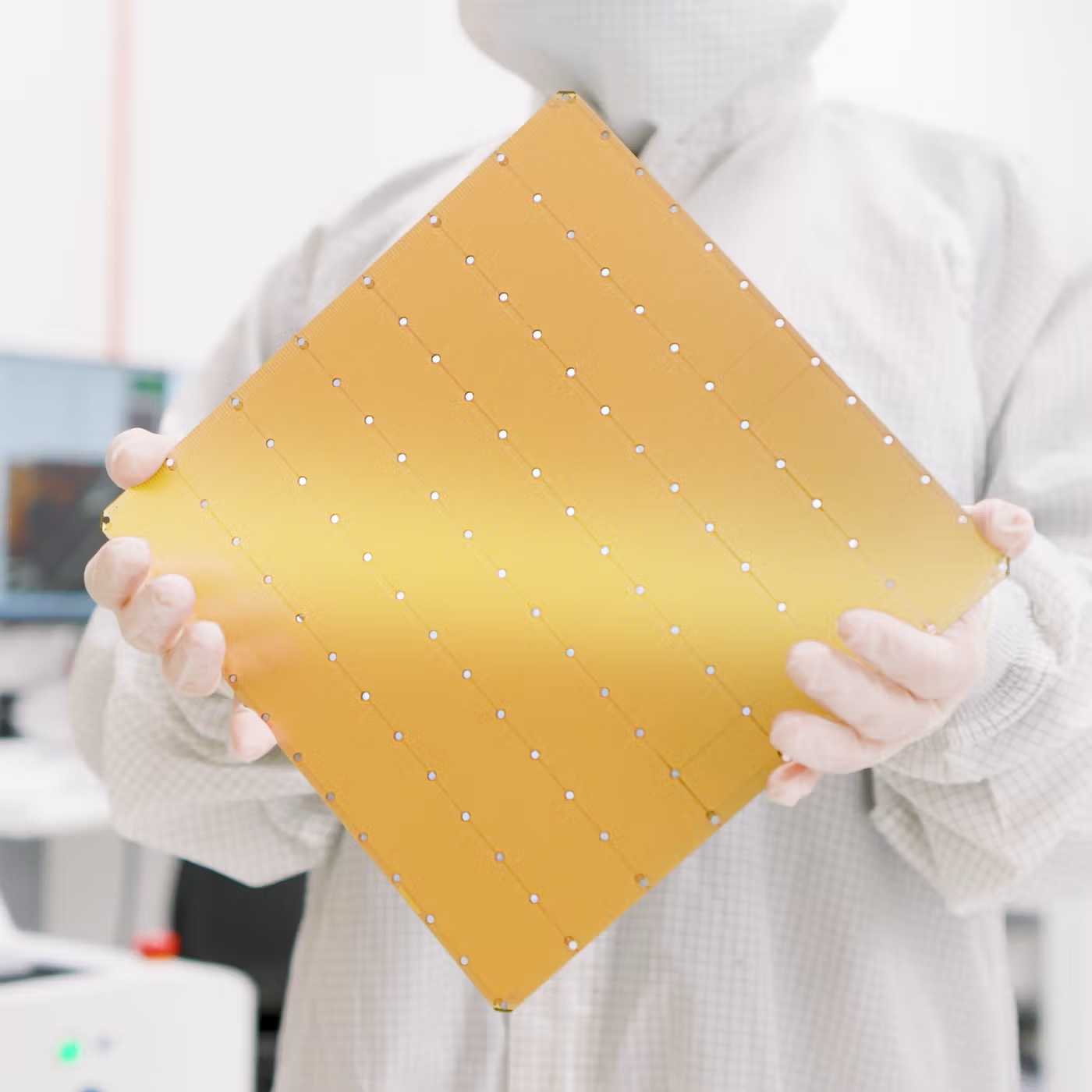

OpenAI의 접근법은 하드웨어 자체를 바꾸는 것입니다. 파트너사인 Cerebras가 만드는 칩이 핵심인데요, 일반 H100 GPU가 약 1평방인치라면 Cerebras 칩은 무려 70평방인치, 웨이퍼 전체 크기입니다.

이렇게 큰 칩을 만드는 이유는 내부 메모리(SRAM)를 최대한 많이 확보하기 위해서입니다. 일반 GPU는 SRAM이 수십 메가바이트 수준이라, 추론 중에 모델 가중치를 외부 메모리에서 계속 끌어와야 합니다. 반면 Cerebras 칩은 SRAM이 44GB에 달해 모델 전체 또는 상당 부분을 칩 안에 올려놓을 수 있어요. 메모리 이동이 줄면서 속도가 15배까지 빨라지는 겁니다.

다만 여기서 트레이드오프가 생겼습니다. 44GB라는 용량으로는 GPT-5.3-Codex 같은 거대 모델을 그대로 올릴 수 없어요. 그래서 OpenAI는 원본 모델을 지식 증류(knowledge distillation)로 압축한 경량 버전, GPT-5.3-Codex-Spark를 따로 만들었습니다. 속도는 훨씬 빠르지만 원본보다 성능이 떨어지고, 특히 툴 호출에서 오류가 더 잦다는 게 저자의 평가입니다.

더 인상적인 건 OpenAI지만, 영리한 건 Anthropic

기술적 난이도만 보면 OpenAI가 앞섭니다. 새로운 하드웨어에 모델을 이식하고, 성능을 최대한 유지하면서 압축하는 건 쉬운 일이 아니니까요. 반면 Anthropic은 기존 인프라에서 배치 크기를 조정하는 비교적 단순한 방식을 택했습니다.

저자는 흥미로운 추측도 덧붙입니다. OpenAI가 1월에 Cerebras와 파트너십을 맺자, Anthropic이 OpenAI의 발표를 앞질러 먼저 fast mode를 내놓았을 가능성이 있다는 거예요. 기술적으로는 단순하지만, 발표 타이밍으로 주도권을 가져가는 전략이라는 분석이죠.

빠른 추론이 AI의 다음 핵심 경쟁 축이 될지는 아직 불확실합니다. 저자는 AI 에이전트의 유용성은 속도보다 정확도에 달려 있다고 봅니다. 실수를 처리하는 시간이 모델 대기 시간보다 훨씬 크다는 이유에서예요. 다만 Claude Code가 이미 Haiku를 일부 작업에 활용하듯, 빠르고 가벼운 추론이 AI 시스템의 내부 부품으로 자리잡을 가능성은 열려 있습니다. 두 방식의 기술적 세부 분석과 Hacker News 커뮤니티의 반론까지, 원문에서 더 깊이 확인할 수 있습니다.

답글 남기기