AI 코딩 도구가 실제로 얼마나 생산성을 높일까요? 막연한 기대가 아니라 실측 데이터로 답할 수 있는 시점이 왔습니다.

AI 코드 리뷰 도구를 만드는 Greptile이 “The State of AI Coding 2025” 보고서를 발표했습니다. 2025년 3월부터 11월까지 추적한 실제 개발팀 데이터를 분석한 결과, 개발자당 작성하는 코드 라인이 4,450줄에서 7,839줄로 76% 증가했습니다. 특히 6-15명 규모의 중형 팀에서는 개발자당 7,005줄에서 13,227줄로 거의 두 배 가까이 늘었죠.

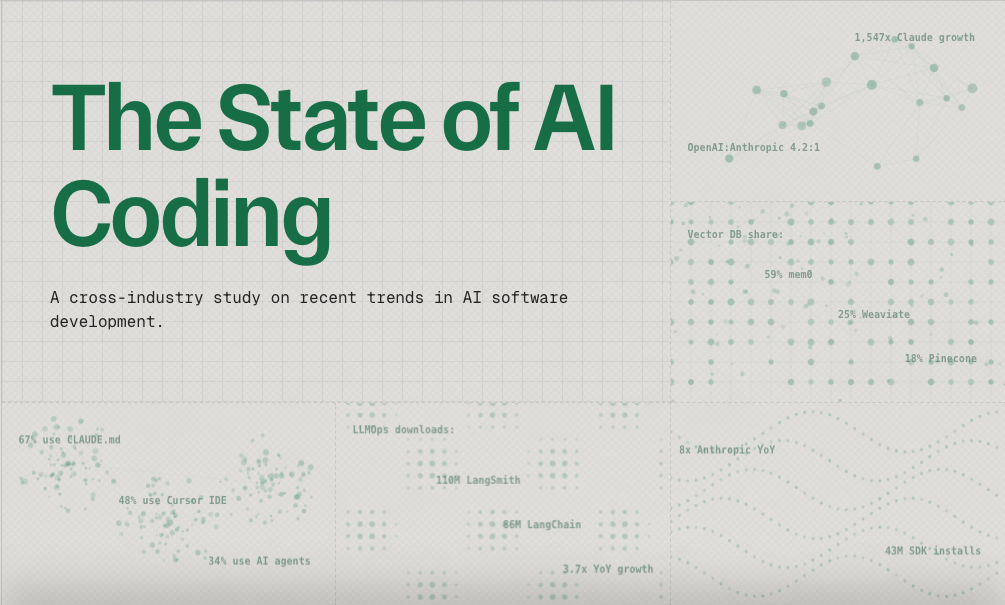

출처: The State of AI Coding 2025 – Greptile

단순히 코드가 많아진 게 아니다

흥미로운 건 양적 증가만이 아닙니다. PR(Pull Request) 하나당 변경되는 코드 라인도 57줄에서 76줄로 33% 늘었고, 파일당 변경 라인도 18줄에서 22줄로 20% 증가했어요. 이건 개발자들이 AI의 도움을 받아 더 많은 코드를 쓰는 동시에, 한 번에 더 큰 단위의 작업을 처리하고 있다는 뜻입니다.

AI 코딩 도구가 단순히 자동완성을 넘어서 “힘 증폭기(force multiplier)” 역할을 하고 있다는 거죠. 개발자는 고민하고 설계하는 데 집중하고, 반복적인 코드 작성이나 보일러플레이트는 AI에게 맡기는 패턴이 자리잡은 겁니다.

Claude가 OpenAI를 빠르게 따라잡는다

보고서는 AI 모델 시장의 극적인 변화도 보여줍니다. 2024년 1월, OpenAI SDK 다운로드는 Anthropic SDK의 47배였어요. 그런데 2025년 11월에는 그 비율이 4.2배로 급감했습니다.

왜일까요? 성능 벤치마크가 힌트를 줍니다. 보고서는 GPT-5 Codex, Sonnet 4.5, Opus 4.5, Gemini 3 Pro를 직접 테스트했는데요:

첫 응답 속도(TTFT):

- Claude Sonnet 4.5: 2.0초 (중간값)

- Claude Opus 4.5: 2.2초

- GPT-5 Codex: 5.0초

- Gemini 3 Pro: 13.1초

Claude는 GPT-5보다 2배 이상 빠르게 첫 토큰을 반환합니다. 코딩 세션에서 이 2-3초 차이는 “흐름을 유지하느냐, 기다리다 딴 짓을 하느냐”를 가르는 결정적 순간이죠.

반면 생성 처리량은 GPT-5 Codex가 62 tok/s로 가장 빠르고, Claude는 18-19 tok/s로 중간 수준입니다. 즉 긴 코드를 한 번에 생성하는 속도는 GPT-5가 앞서지만, 대화형 작업에서 체감 반응속도는 Claude가 훨씬 낫다는 겁니다.

개발자들이 실제로 쓰는 도구들

보고서는 AI 코딩 생태계의 도구 점유율도 공개했습니다:

AI 메모리 인프라: mem0가 59%로 압도적입니다. AI가 대화 맥락을 기억하고 학습하는 기능에서 사실상 표준이 된 거죠.

프롬프트 관리: CLAUDE.md가 67%로 1위입니다. 개발자들이 AI에게 코드베이스 컨텍스트를 전달할 때 가장 많이 쓰는 형식이에요. 17%의 저장소는 CLAUDE.md, .cursorrules, .aiderignore 세 가지를 모두 사용하고 있습니다.

SDK 다운로드: OpenAI SDK가 여전히 1억 3천만으로 1위지만, Anthropic SDK는 2023년 4월 대비 1,547배 성장해 4,300만을 기록했습니다. Pydantic AI는 3.7배 급증해 600만 다운로드를 찍었고요.

LiteLLM(여러 LLM API를 통합하는 도구)은 4배 성장해 4,100만 다운로드에 도달했습니다. 개발자들이 특정 모델에 종속되지 않으려는 전략적 선택이 보이네요.

연구도 실무를 따라간다

보고서 후반부는 최신 학술 연구 9편을 소개합니다. 특히 눈에 띄는 건:

DeepSeek-V3: 671B 파라미터 모델이지만 토큰당 37B만 활성화하는 MoE 구조. “크기가 아니라 효율”로 승부합니다.

RAG vs Long Context 논쟁: 두 논문이 정반대 결론을 내렸어요. 한 연구는 “긴 컨텍스트가 구조화된 정보에 강하고 RAG는 파편화된 데이터에 유리”라고 했고, 다른 연구(RetroLM)는 “KV 캐시를 검색 대상으로 삼으면 RAG가 긴 컨텍스트를 이긴다”고 주장합니다. 실무 선택의 여지가 넓어진 거죠.

Self-MoA: 여러 모델을 섞는 대신 하나의 강한 모델을 반복 샘플링해도 성능이 나온다는 발견. 복잡한 앙상블 대신 단순한 전략으로 갈 수 있다는 뜻입니다.

2025년, AI 코딩의 의미

이 보고서가 보여주는 건 단순한 숫자가 아닙니다. AI 코딩 도구가 이제 “실험”이 아니라 “기본값”이 되고 있다는 거죠. 개발자당 생산성이 76% 오른 건 도구가 성숙했다는 증거고, Claude가 급성장한 건 개발자들이 실제 사용 경험을 바탕으로 도구를 선택하고 있다는 신호입니다.

동시에 한계도 명확합니다. 속도와 처리량 사이의 트레이드오프, RAG와 긴 컨텍스트 중 무엇을 선택할지, 단일 모델에 의존할지 여러 모델을 조합할지. 이런 선택은 여전히 팀의 상황과 작업 특성에 따라 달라집니다.

하지만 확실한 건, 2025년의 개발자는 2024년의 개발자보다 훨씬 더 많은 일을 해낼 수 있다는 거예요. 그리고 그 변화는 이제 막 시작입니다.

답글 남기기