병원 예약이 몇 주씩 밀리고, 보험 약관은 도통 이해가 안 되고, 새벽에 갑자기 이상 증상이 생겼을 때 어디에 물어봐야 할까요? 전 세계 4천만 명이 매일 같은 질문을 ChatGPT에 던지고 있습니다.

OpenAI가 Axios와 단독 공유한 보고서에 따르면, 전 세계에서 ChatGPT로 주고받는 전체 메시지의 5% 이상이 건강 관련 질문입니다. 사람들은 의료비 청구서 해석, 보험 플랜 비교, 증상 확인 등을 ChatGPT에 맡기고 있죠. 특히 미국에서 건강보험 보조금이 만료된 올해 초부터 보험 관련 질문이 주당 160만~190만 건으로 급증했습니다. 그런데 같은 시기, Guardian의 조사는 Google의 AI 요약 기능이 생명을 위협할 수 있는 잘못된 건강 정보를 제공하고 있다는 사실을 밝혀냈습니다.

출처: OpenAI’s ChatGPT helps users navigate health care and health insurance – Axios

왜 이렇게 많은 사람들이 AI에 건강을 묻나

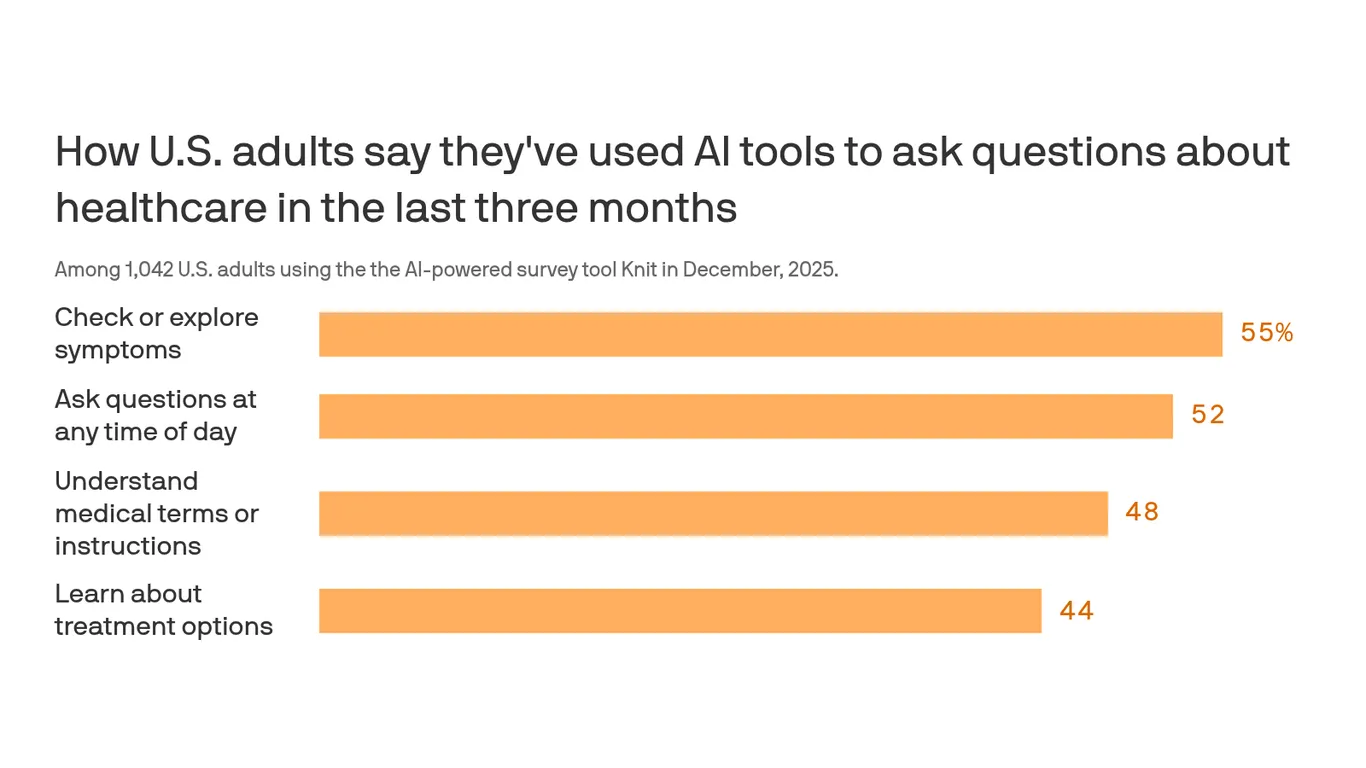

숫자가 말해줍니다. ChatGPT 건강 관련 대화의 70%가 일반 진료 시간 외에 일어납니다. 의사를 만나기 어려운 시골 지역에서는 매주 60만 건의 건강 메시지가 오갑니다. 사람들은 단순히 정보를 찾는 게 아닙니다. 증상을 입력하고, 의사의 조언을 붙여넣고, 자신의 상황을 설명하면서 “이게 응급실에 가야 할 정도인지” 판단을 구합니다.

OpenAI 보고서는 “보험 플랜 문서, 진료 지침, 의료 포털 데이터 같은 환자별 맥락이 있을 때 신뢰성이 향상된다”고 밝혔습니다. 실제로 항목별 의료비 청구서를 ChatGPT에 올려 중복 청구나 부적절한 코딩을 찾아낸 사례들이 화제가 됐죠. 한 가족은 Claude를 이용해 19만 5천 달러짜리 병원비를 3만 3천 달러로 줄이기도 했습니다.

접근성 문제를 AI가 메우고 있다는 건 분명합니다. 하지만 이게 안전한 해결책일까요?

생명을 위협하는 오답들

Guardian이 발견한 사례들은 충격적입니다. Google AI Overviews는 췌장암 환자에게 고지방 식품을 피하라고 조언했습니다. 췌장암 환자는 체중 유지를 위해 고지방 식품을 먹어야 하는데 말이죠. Pancreatic Cancer UK의 Anna Jewell은 “환자가 이 조언을 따르면 충분한 칼로리를 섭취하지 못해 화학요법이나 생명을 살릴 수 있는 수술을 견디지 못할 수 있다”며 “정말 위험하다”고 말했습니다.

간 기능 검사 정상 범위를 검색하면 AI는 맥락 없는 숫자 더미를 쏟아냅니다. 국적, 성별, 민족, 나이를 고려하지 않은 채로요. British Liver Trust의 Pamela Healy는 “간 질환은 말기까지 증상이 없는 경우가 많아서 검사가 중요한데, AI가 말하는 ‘정상’은 실제 정상 범위와 크게 다를 수 있다”고 경고했습니다. 심각한 간 질환이 있는데도 결과가 정상이라고 착각해 후속 진료를 건너뛸 수 있다는 겁니다.

자궁경부암 증상을 검색하면 AI는 팝 검사(pap test)를 질암 검사라고 잘못 안내했습니다. Eve Appeal의 Athena Lamnisos는 “완전히 틀린 정보”라며 “최근 자궁경부 검진에서 이상이 없었다는 이유로 질암 증상을 확인하지 않을 수 있다”고 우려했습니다. 더 문제는 같은 검색어를 입력해도 매번 다른 답변이 나온다는 점입니다.

정신 건강 관련 조언은 더 심각했습니다. Mind의 Stephen Buckley는 섭식 장애와 정신병 관련 AI 요약이 “매우 위험하고, 부정확하며, 해롭거나 사람들이 도움을 구하지 않도록 유도할 수 있다”고 지적했습니다.

신뢰와 책임 사이의 간극

아이러니는 여기 있습니다. 펜실베니아대 Annenberg Public Policy Center의 2025년 4월 조사에 따르면, 미국 성인의 80%가 건강 증상에 대해 온라인 검색을 할 것이라고 답했고, 그중 64%가 AI가 생성한 정보를 “다소 또는 매우 신뢰할 만하다”고 평가했습니다. MIT 연구는 더 놀라운 사실을 발견했습니다. 참가자들은 정확도가 낮은 AI 답변도 “타당하고, 신뢰할 만하며, 완전하고 만족스럽다”고 평가했고, 잠재적으로 해로운 의학적 조언을 따를 가능성이 높았습니다.

OpenAI는 GPT-5 모델이 더 많은 후속 질문을 하고, 최신 연구를 검색하며, 필요시 전문가 평가를 권하도록 개선했다고 밝혔습니다. Google 대변인은 “건강 같은 주제에는 특히 AI Overviews의 품질에 많은 투자를 하고 있으며, 대다수가 정확한 정보를 제공한다”고 말했습니다.

하지만 캐나다 의사협회(CMA)는 웹사이트에서 AI 건강 조언을 “위험하다”고 명시하고 있습니다. 할루시네이션, 알고리즘 편향, 오래된 정보가 “잘못된 판단을 유도하고 건강에 해를 끼칠 수 있다”는 이유에서죠. 전문가들은 여전히 인간 의사와 면허를 가진 의료 전문가를 만나라고 권고합니다. 현실적으로 많은 나라에서 적절한 의료 서비스를 받기 어렵다는 점을 생각하면 비극적인 조언입니다.

재미있는 점은, AI Overviews 자신도 자기 한계를 알고 있다는 겁니다. “AI Overviews가 건강 조언에 신뢰할 만한가”라고 검색하면, 이 기능은 Guardian의 조사 기사를 친절히 안내합니다. “Guardian 조사에 따르면 Google의 AI Overviews가 사람들을 해칠 위험이 있는 거짓되고 오해를 불러일으키는 건강 정보를 표시했습니다”라고 말이죠.

AI가 의료 접근성 문제를 일부 해결하는 건 분명합니다. 하지만 잘못된 정보 하나가 생명을 좌우할 수 있는 영역에서, 편리함과 안전 사이의 균형을 어떻게 맞출 것인지는 여전히 풀리지 않은 숙제입니다.

참고자료:

답글 남기기