LLM

AI의 화려한 착각: ‘그럴듯한 헛소리’의 과학적 해부

최신 연구 결과를 통해 밝혀진 AI의 추론 한계와 ‘그럴듯한 헛소리’ 문제를 분석하고, AI를 현명하게 활용하는 방법을 제시하는 글입니다.

Written by

Redis 8의 시맨틱 캐싱으로 LLM 비용 90% 절감하기

Redis 8의 혁신적인 시맨틱 캐싱 기술로 LLM 운영 비용을 대폭 절감하는 방법을 상세히 알아보세요. Vector Sets, LangCache, Redis Flex 등 새로운 기능들과 다양한 캐싱 전략을 실무 관점에서 분석합니다.

Written by

AI 에이전트에 기억력을 선사하는 메모리 시스템: 무상태에서 개인화된 AI로의 진화

AI 에이전트의 무상태 한계를 극복하고 개인화된 서비스를 제공하기 위한 메모리 시스템 구현 방법과 핵심 도전과제를 다룬 기술 가이드

Written by

AI 에이전트를 위한 컨텍스트 엔지니어링: Manus 개발팀이 찾은 6가지 핵심 원칙

AI 에이전트 개발에서 컨텍스트 엔지니어링의 중요성과 실제 프로덕션 환경에서 검증된 6가지 핵심 원칙을 소개하는 실무 가이드. Manus 개발팀의 경험을 바탕으로 KV-캐시 최적화, 도구 관리, 파일 시스템 활용 등 구체적인 구현 방법을 다룹니다.

Written by

VoltAgent: TypeScript 네이티브 AI 에이전트 프레임워크 완전 가이드

Python 중심의 AI 개발 환경에서 벗어나 TypeScript 개발자를 위해 처음부터 설계된 VoltAgent 프레임워크의 특징과 실무 활용법을 상세히 소개합니다.

Written by

LLM 도입 가이드: 언제, 어떤 모델을 선택해야 할까?

LLM을 언제 사용해야 하는지, 오픈소스와 유료 모델 중 어떤 것을 선택해야 하는지에 대한 실무적 판단 기준과 상황별 최적 전략을 제시하는 완전 가이드입니다.

Written by

LLM들의 이미지 속 인물 식별 능력 비교: Google Gemini가 앞서는 이유

주요 멀티모달 LLM들의 이미지 속 인물 식별 능력을 비교 분석하고, Google Gemini가 높은 정확도를 보이는 반면 ChatGPT와 Claude는 개인정보 보호 정책으로 인해 제한되는 현상을 다룬 글

Written by

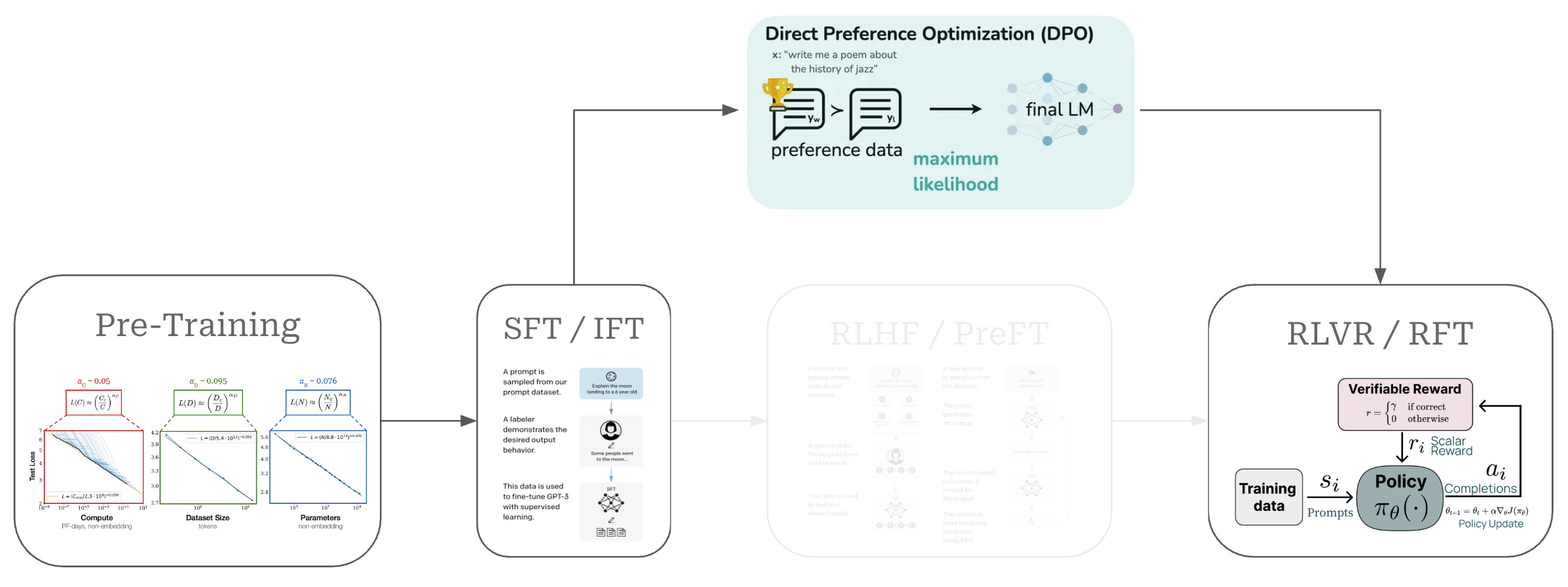

DPO: RLHF를 대체하는 혁신적인 LLM 정렬 기법 – 복잡성을 제거하고 효율성을 높이다

DPO(Direct Preference Optimization)는 기존 RLHF의 복잡성을 제거하면서도 동일한 성능을 달성하는 혁신적인 LLM 정렬 기법입니다. 별도의 보상 모델과 강화 학습 없이도 인간 선호도에 맞는 고품질 언어 모델을 훈련할 수 있어, AI 개발의 접근성을 크게 향상시켰습니다.

Written by

프로덕션 AI 에이전트 개발의 핵심 원칙 6가지 – 실무자가 전하는 검증된 가이드라인

실제 프로덕션 환경에서 안정적으로 작동하는 AI 에이전트를 구축하기 위한 6가지 핵심 원칙을 실무 경험을 바탕으로 소개합니다. 명확한 프롬프트 작성부터 체계적인 오류 분석까지, 개발자들이 시행착오를 줄이고 효과적인 AI 에이전트를 만들 수 있는 실용적인 가이드라인을 제공합니다.

Written by

LLM의 시각으로 세상 보기: 컨텍스트가 모든 것을 결정한다

LLM의 예상치 못한 행동들이 왜 발생하는지, 그리고 컨텍스트 엔지니어링을 통해 어떻게 해결할 수 있는지에 대한 실용적 인사이트를 제공하는 글입니다.

Written by